# 《云应用系统开发技术》

# 内容简介

本书从云计算理论基础知识、历史发展过程与现阶段状态、国内外云厂商的特色等入手介绍云平台。在此基础上,站在企业的视角,介绍云应用程序在开发、测试、部署、运维等各个软件开发周期中涉及的主流技术。

全书共9章,通过一个 Java 语言编写的 Web 应用程序案例,按开发顺序由浅至深,循序渐进地讲述了一个云端 Web 应用涉及到的基础开发技术,包括版本控制、自动化测试、容器(Docker)、持续集成/持续交付/持续部署、DevOps 以及云平台等内容。本书结构合理、条理清晰、内容丰富。在每一章后面都配有一定数量的习题,在附录中还提供了额外的相关知识,便于读者参考。

本书既可以作为高等院校计算机及软件相关专业本科生的课程教材,也可以作为个软件培训机构培训教材,还可以作为软件工程师,广大软件爱好者的自学读物和参考用书。

# 前言

关于本书书名《云应用系统开发技术》的解释:

- 应用系统 —— 针对某个明确商业目的开发的应用软件系统,可能包含多个子软件或功能模块,与第三方软件模块(如数据库、网络存储、负载均衡、消息中间件、高速缓存等)共同集成以提供具体的商业服务。例如电子商务网站、企业客户关系管理系统等。

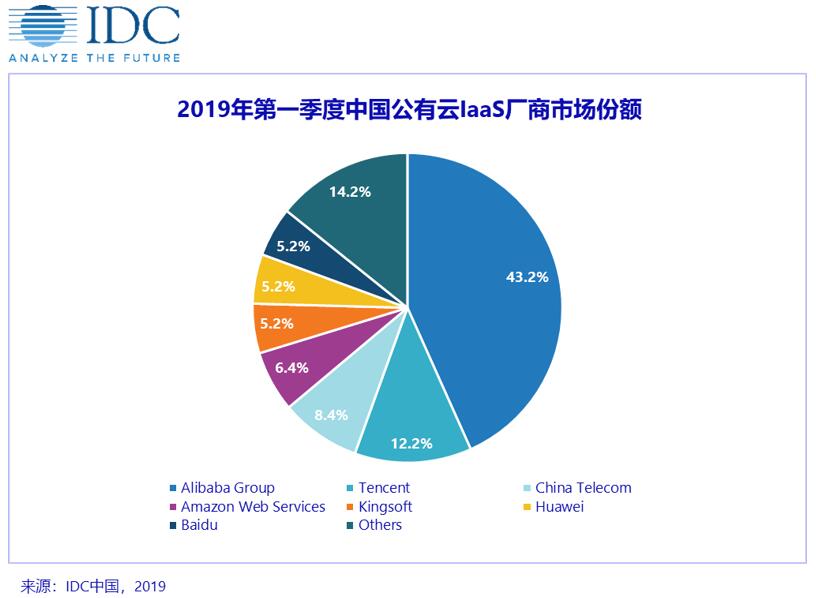

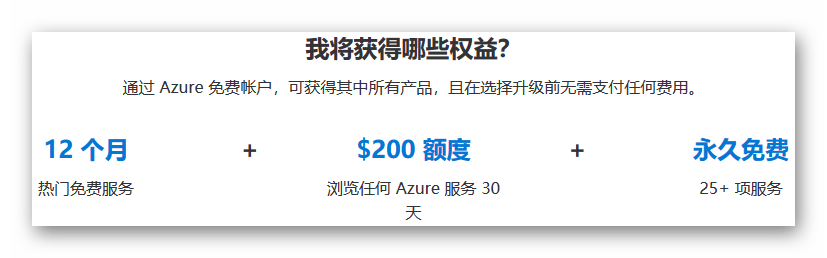

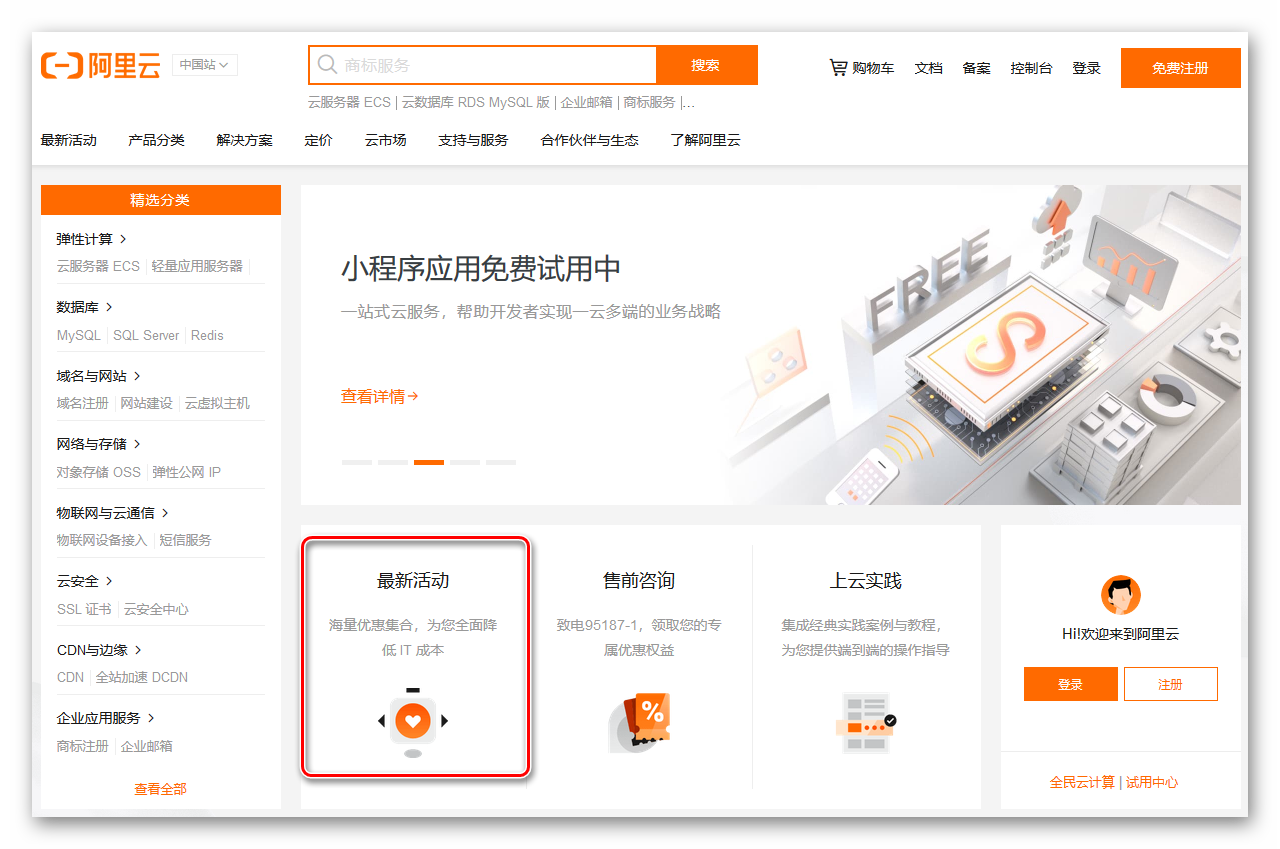

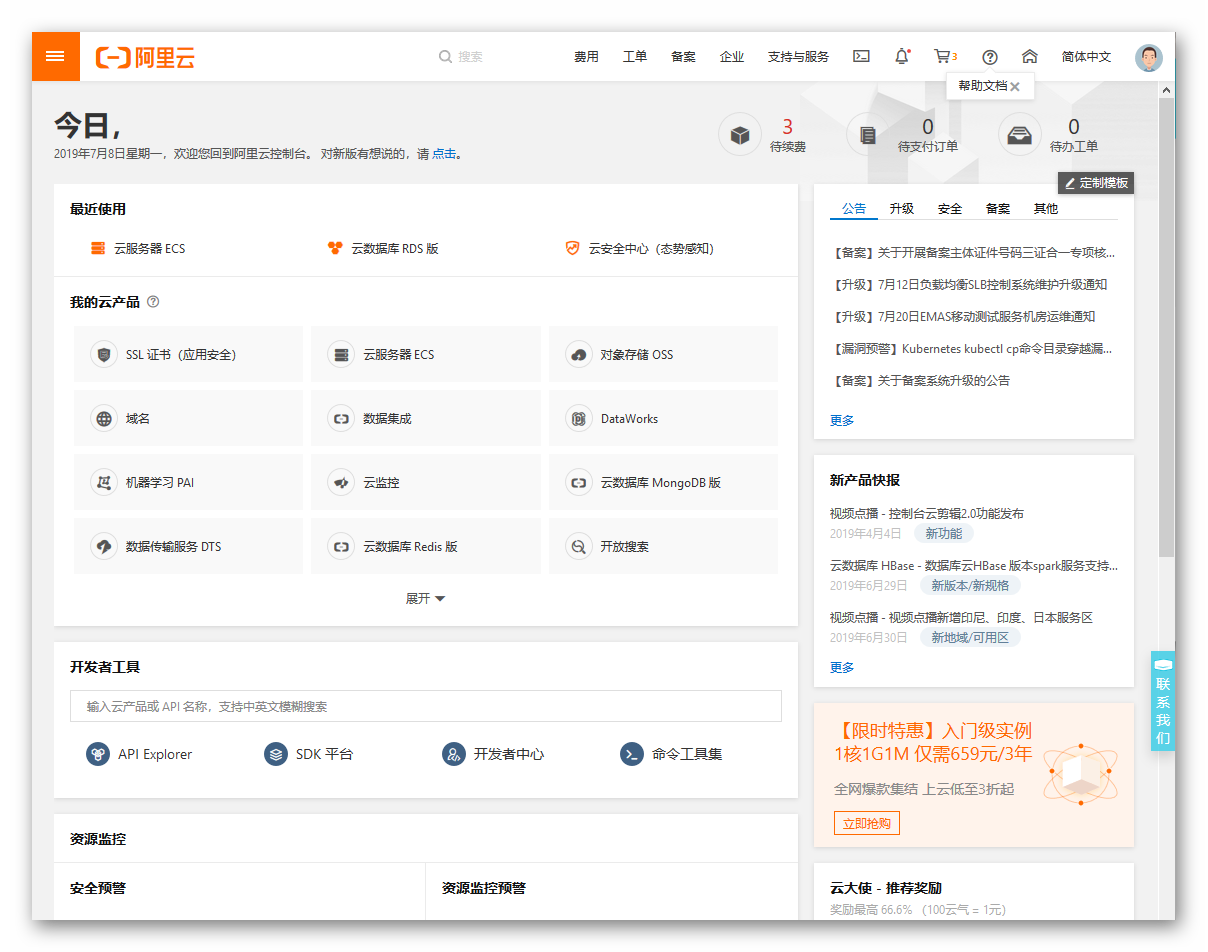

- 云 —— 应用系统部署在云端,是应用系统的载体。云服务提供商有很多个,国外知名的如亚马逊、微软、谷歌等,国内知名的如阿里云、腾讯云等。云服务包括各厂商都能够提供的,标准化且同质化的服务,如虚拟服务器;也有厂商私有的,独特的服务,如微软 Office 365,谷歌的 AppEngine,Salesforce.com 等。

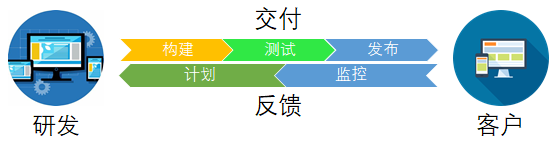

- 开发技术 —— 不同于传统的自建机房的开发技术,基于公有云平台的流行而伴生的新的开发技术,它们形成了一套生态系统,包括开发、测试、部署、运维等各个软件开发生命周期涉及的技术。

从书名的意思解释,本书的侧重点是“开发技术”,而开发出的“应用系统”将最终部署在“云”平台上。

本书不会纵向深入具体的开发技术细节,而是侧重于横向给读者建立一个高层次的,概要性的思维框架。即云应用系统包含哪些云平台,如何选择,有哪些相关的主流开发技术,未来的发展趋势,以及举例实现一个云应用串起这些开发技术。

因此,本书总体将分为以下几部分:

- 概要性地介绍云理论基础,历史发展过程与现阶段的状态,对比传统开发技术的不同之处与特点,未来的发展趋势。

- 列举和对比国内外云厂商各自的优劣与特色,如何选择。挑选亚马逊(国外)和阿里云(国内)两个做一个简要介绍。

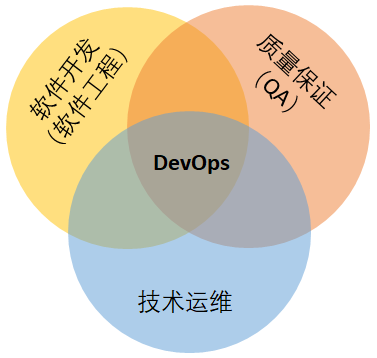

- 基于云的应用系统开发技术的生态系统,这是本书内容的重心所在。讲解在开发、测试、部署、运维等各个软件开发生命周期涉及的主流技术。例如:分布式版本控制系统 Git、自动化测试、持续集成/持续交付/持续部署、容器 Docker、运维 DevOps 等。

- 站在企业的视角,模拟从一个业务需求开始,到具体实施上线的全过程,以此串起本课程的全部知识点。

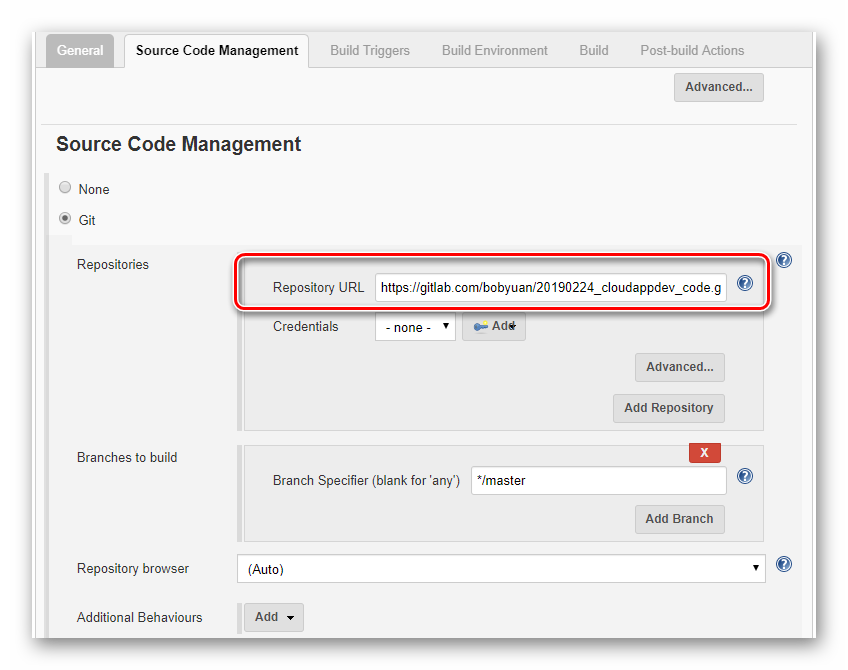

本书的示例代码托管在 GitLab 上,是开放的,读者可以自行下载。地址:

https://gitlab.com/bobyuan/20190224_cloudappdev_code (opens new window)

限于作者的水平和学识,书中难免存在疏漏和错误之处,诚望读者不吝赐教,以便修正,让更多读者收益。

最后,谨向关心和支持本书编写工作的各方面人士表示感谢!

编者 2019年7月9日

# 第1章 概述

# 1.1 什么是云计算

云计算(Cloud Computing)是一种基于虚拟化和互联网的计算方式。这种模式提供按需使用,可配置的计算资源共享池——包括网络、服务器、存储、应用软件和服务等,只需投入很少的管理工作,就能够将这些资源快速按需配置,为外界提供服务。在互联网时代,利用云计算的优势,我们所能够使用的计算资源将不再局限于自己所拥有的物理设备,还可以通过租用云服务的方式来满足我们的计算需求,而且在大多数情况下更具有成本优势。

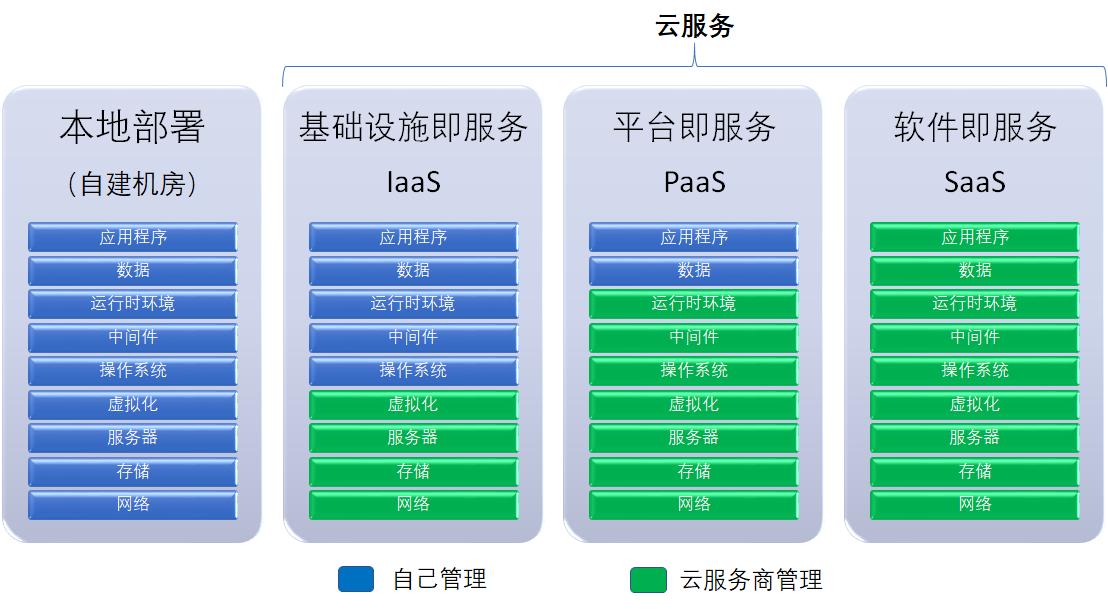

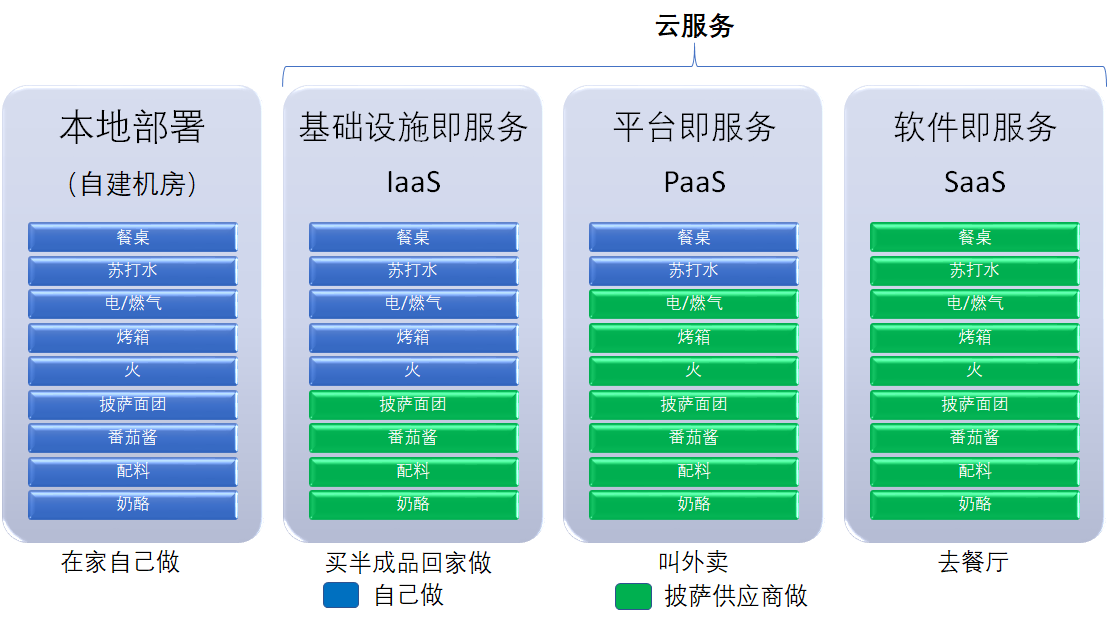

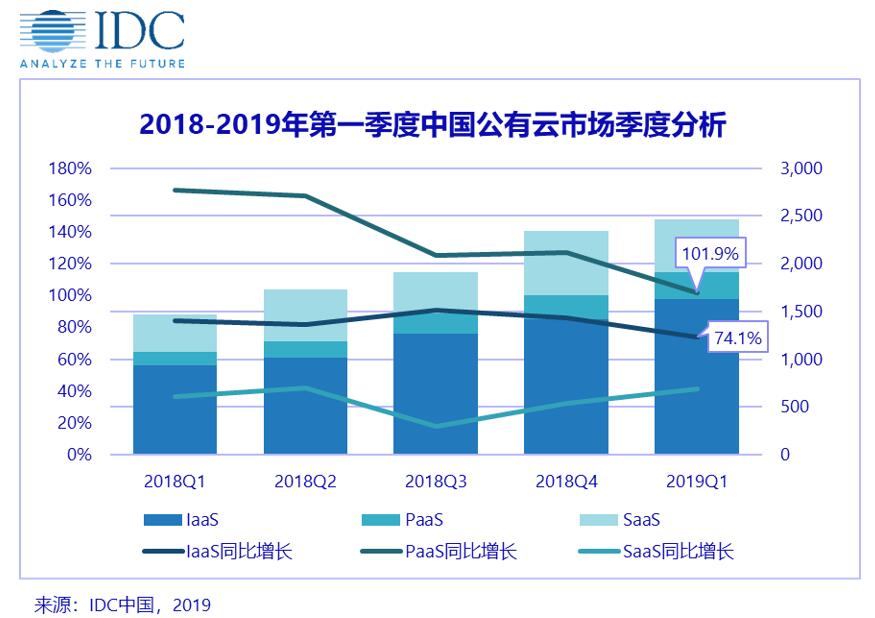

云计算的服务模型可分为三种,分别是:IaaS、PaaS 和 SaaS。

IaaS(Infrastructure as a Service,基础设施即服务)指客户可以从完善的计算机基础设施提供商获得服务。有了 IaaS,我们可以将公司运营所需要的服务器、储存器和网络硬件外包给别的公司,即 IaaS 云服务提供商,从而节省日常设备维护以及办公场地的成本。IaaS 云服务提供商会帮我们日常维护硬件,还能满足一定的弹性需求。比如当公司需要进行业务扩张,需要更多计算能力的时候,可以轻松地获取更多的服务器;当网站访问人数较少时,可以随时减少部署的服务器以节约开支。

PaaS(Platform as a Service,平台即服务)提供了用户可以使用的应用程序开发平台。公司中所有的开发和部署环境都可以在这个层面上进行,从而达到节省时间和资源的目的。PaaS 的强大之处在于它能够涵盖软件开发的各个阶段,提供了从开发工具、中间件,到数据库软件等开发所需的全部功能,原本分散的工作室之间的合作也变得更加 容易。例如微软的 Azure 服务平台就包含了 Microsoft SQL 数据库服务、Microsoft .Net 服务;用于分享、储存和同步文件的 Live 服务;针对商业的 Microsoft SharePoint 和 Microsoft Dynamics CRM 服务等,它使得各个开发小组之间的合作能够更加紧密。

SaaS(Software as a Service,软件即服务)提供了完整的可以直接使用的应用程序。这一层面上的应用大多数可以通过网页浏览器进行访问或接入,例如我们日常所使用的电子邮件服务,网盘,微软 Office 365等。用户一般只需要注册一个账号,或简单的集成就可以使用,方便快捷,省时省力。

图1.1.1 自建机房与云服务平台对比

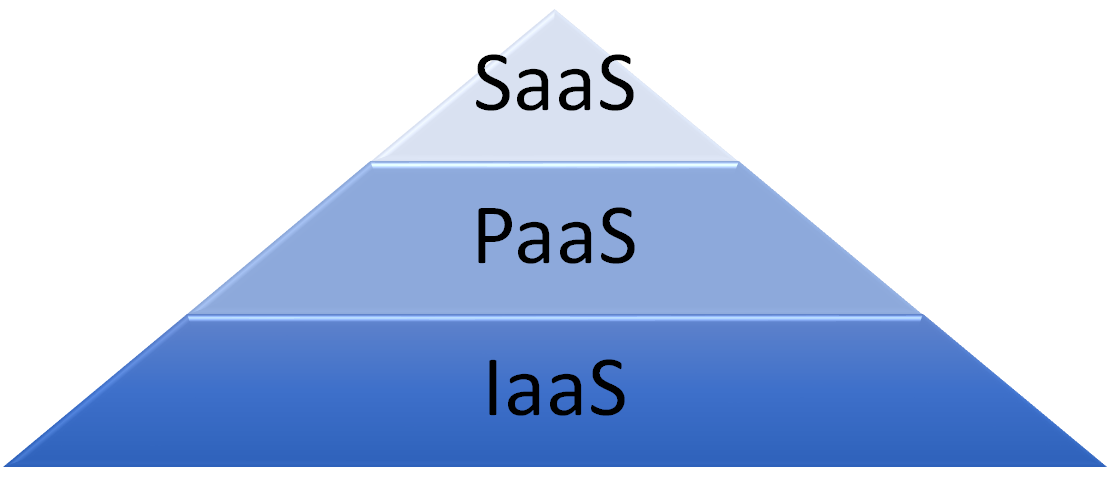

在云计算的服务模型中,我们把基础设施(Infrastructure)、平台(Platform)和软件(Software)即服务分为三层:基础设施即服务(Infrastructure-as-a-Service, IaaS)在最下端,平台即服务(Platform-as-a-Service, PaaS)在中间,软件即服务(Software-as-a-Service, SaaS)在顶端。它们的复杂程度和抽象程度,由下往上递增。如下图:

图1.1.2 云服务平台的金字塔模型

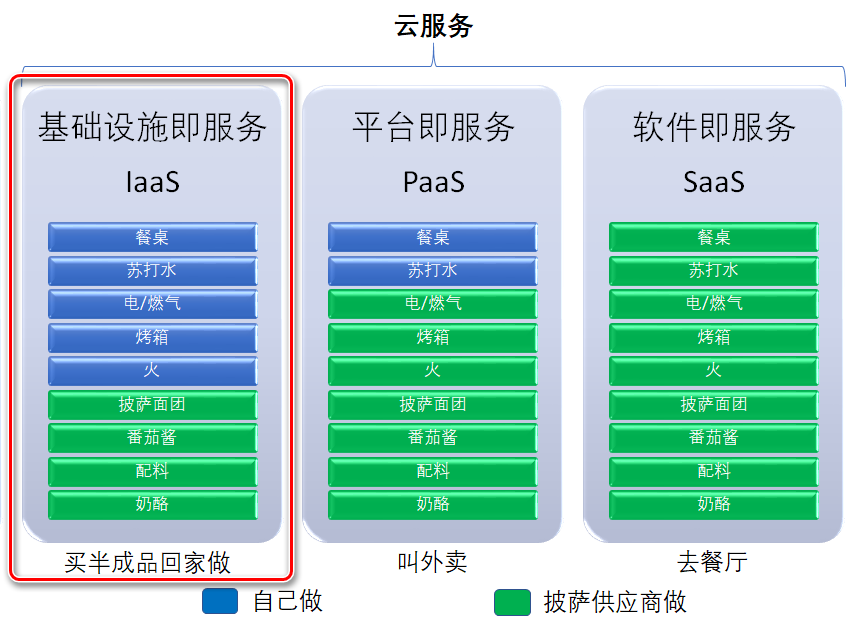

为了更好的解释以上三者的含义,我们借用一个经典的例子“Pizza As A Service”来做一个类比。假设你现在想吃披萨,那么现在有几种做法:

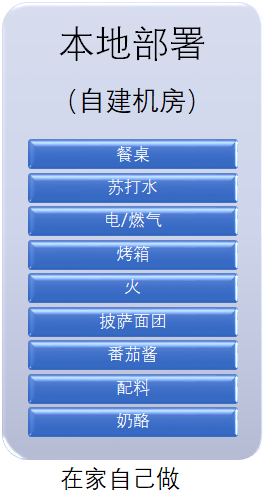

在家自己做披萨

这显然是自己需要动手最多的方式,而且需要准备全部的原料和厨具。想要吃上披萨,需要经历发面、做面团、切菜、调酱、撒料、进烤箱、准备苏打水和餐桌等众多步骤。

图1.1.3 Pizza As A Service 之在家自己做

这时候你开始犯嘀咕了,我就想吃个披萨,这也太麻烦了,什么都要自己做,耗时费力,更别说自己厨艺不佳,说不定把它烤焦了呢。于是,就想到了下面第二种方法。

买半成品披萨回家做

你根本就不会做披萨,但又不想花精力去学习如何才能做出好吃的披萨。于是你去超市买一个半成品披萨,只需要放入烤箱,过一会儿便可以享受美味的披萨了。但是这次,你需要一个供应商来为你提供这个披萨半成品。图中的蓝色部分代表需要自己完成的,绿色部分是披萨供应商提供的。

图1.1.4 Pizza As A Service 之买半成品回家做

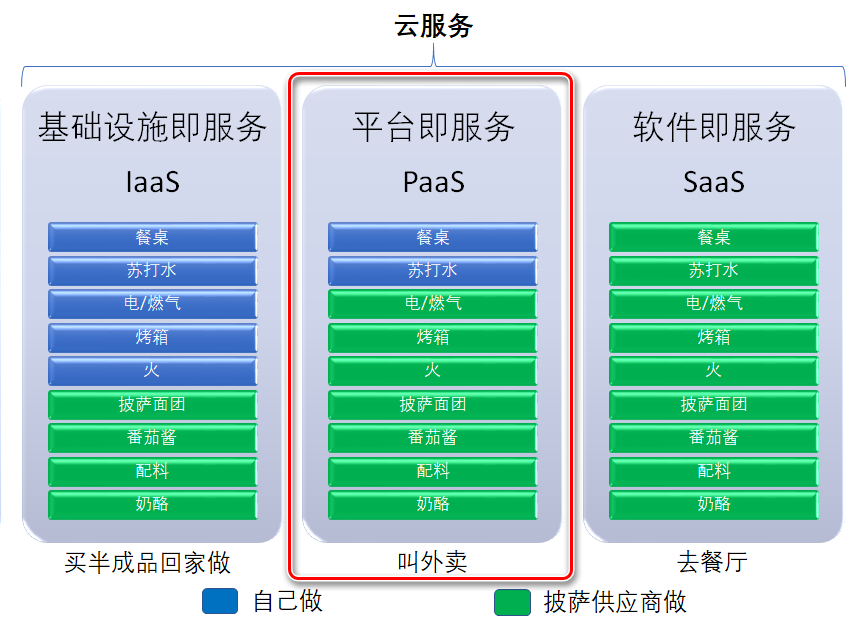

叫外卖

你想到一年也许只吃一两次披萨,而家里又恰巧没有烤箱,怎么办?订外卖吧!这次供应商为你省去了所有的制作环节,还省去了购置烤箱的成本,但具体如何享用这份披萨,还是需要自己来决定。

图1.1.5 Pizza As A Service 之叫外卖

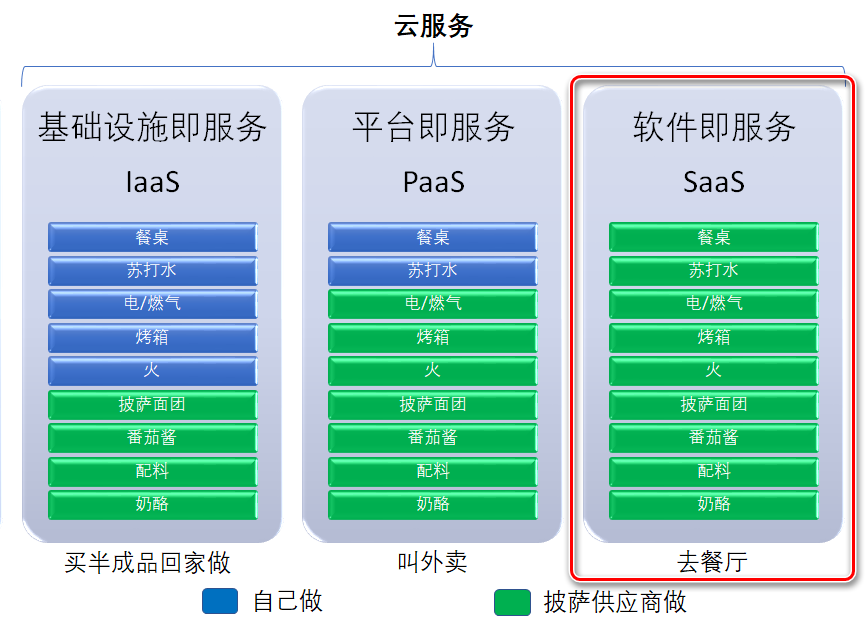

去披萨餐厅吃

最简便的方法,还是去披萨餐厅吃吧!你什么都不需要做,甚至用不着收拾桌子和洗盘子,餐厅会为你提供需要的一切。

图1.1.6 Pizza As A Service 之去餐厅

如果我们把披萨替换成软件,将“吃”替换成“使用”。那么我们就不难理解这三种模式所代表的含义了。云计算的存在能够让我们忽略很多底层的实现细节,得到一个更加高效的使用环境。

图1.1.7 Pizza As A Service 之汇总对比

# 1.2 云计算的优点

介绍完上述的例子,相信我们对云计算已经大体有了一些了解,接下来总结一下云计算的优点。

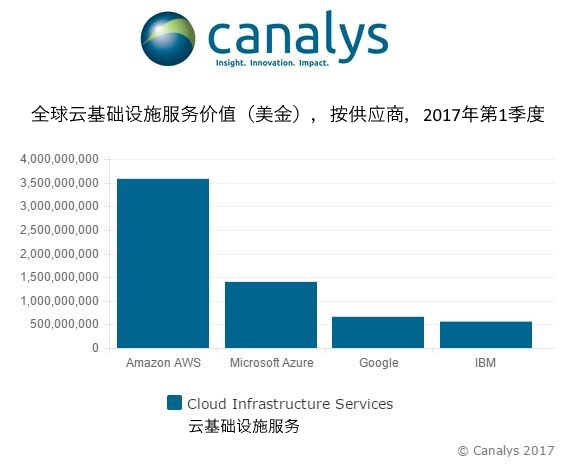

- 规模大

云计算厂商为了能够向外界提供云服务,其自身必须拥有强大的计算资源。例如亚马逊的 Amazon Web Services (简称为 AWS),微软的 Microsoft Azure 云服务背后都有着数十万台服务器的支持,谷歌(Google)的云计算更拥有多达百万级服务器的计算能力。这种规模的计算能力是一般企业单独依靠自身能力所不能想象的。

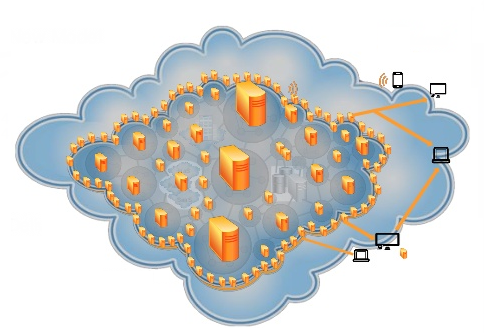

- 虚拟化

云计算的执行过程在云端完成,并不需要确定在某个物理地点,用户可以在任意位置使用任一终端来获取这一服务,这就实现了我们计算资源的虚拟化。用户无需了解应用运行的具体位置就可以通过网络获取强大的计算能力。虚拟化的另一个好处是我们可以基于现有的方案随时更改远端的配置,有利于程序的快速部署。

- 可靠性高

云端的数据通常采取多副本容错、计算节点同构可互换等措施来保障服务的高可靠性,相对来说使用云计算比使用本地计算机更加可靠。例如我们本地采取的最常见的备份方式磁盘阵列(RAID),除去价格高昂的问题,如果两个硬盘(存储数据的和校验的)同时损坏,数据依然会发生丢失。对比来看,云端的 Hadoop 集群一般都将同一份数据部署在三个不同的机器上,并周期性检测机器的“心跳信号”,如果有机器出现问题则会自动增加一个备份,使得数据丢失的可能性更小。

- 通用性强

云计算并不针对特定的应用,即用户可以使用强大的计算能力构建出千变万化的应用,并使用同一片云来支撑不用的应用运行。例如,PaaS 只是提供给用户一个平台,而在这个平台上如何进行开发,怎样开发则完全取决于用户自身。

- 节约成本

云计算的服务是具有弹性的,用户可以按需动态调度虚拟的计算资源,随用随弃,不必为了短期的使用高峰去购买额外的服务器硬件。此外,日常硬件维护、容错措施、电力成本等额外开销,在云服务上也都不必考虑,在一定程度上能够节约开支。

# 1.3 云计算对传统软件工程的影响

云计算的诸多优点必然会对现有的软件开发过程带来影响,下面我将从六个方面来进行论述。

软件架构的开放性

软件架构描述了一个软件系统从整体到局部的层次划分,架构的优劣不仅影响软件开发过程的效率,还会影响系统后续的可扩展性。在传统软件工程中,系统架构一般由开发经验最丰富的程序员进行设计,这样的人一般被称为“架构师”。那么,当没有丰富的技术水平以及编程经验的时候,我们该如何设计我们自己的软件呢?云计算给了我们答案。在软件工程里,提升复用率一直是提高软件开发效率的重要一环。由于云平台软件架构的开放性,我们可以选择现在已经成熟的构建模块加以复用,这样一来能够缩短程序的开发时间,二来还能够减少软件开发中的不合理之处,提升软件的可靠性。

软件对象的多样性

面向对象已经成为了现在软件开发的重要方法,我们在设计软件的时候会首先将大的问题分解为若干个小问题,分析不同软件对象之间的交互行为,之后再从局部到整体,从抽象到具体一步步完成。云计算给我们提供了大量的可复用的软件模块,这使得我们编写软件时可用的原材料更加多样。工欲善其事,必先利其器,更多的软件对象势必有利于我们施展拳脚,但是跟传统软件开发一样,我们依旧需要先分析清楚软件之间的交互关系,然后再进行充分利用。在 PaaS 的平台中,开发者有可能写很少的代码甚至不需要代码,而只需按照业务流程对平台中提供的各类资源进行组织和配置即可。这种模式下,需求与开发具有了同等的语境,同时需求在软件工程中的地位也将显得更加重要。

软件过程的动态性

软件过程是指软件的整个生命周期,从需求获取开始,经过需求分析、设计、编码实现、测试、到发布上线和运营维护为一个周期。传统的软件开发使用反复迭代的方法来进行开发,开发的软硬件资源经常是固定的。但是借助于网络和虚拟化等技术,云计算实现了对软硬件资源的集中化、动态化管理,我们可以更加弹性地管理我们所拥有的资源。例如我们开发一个网站,我们设计上的缺陷可能会导致网站在大流量时访问缓慢。如果没有云计算平台,我们只能另外购买其他更强大的服务器,但是云计算的存在可以使我们随时扩大计算能力,满足我们的计算需求。这种软件过程的动态性更加方便了软件开发。

开发组织的社会化

云计算依赖网络来获取强大的计算能力,在网络环境下,软件开发从封闭的计算机平台逐渐走向互联、互通、协作的网络平台环境。传统的软件企业正在逐渐走向开源。近年来软件技术的飞速发展,闭门造车有可能导致技术的落后。通过云计算,软件的开发过程可以由多个团队来协作完成,众多的开发团队形成了开发组织的社会化。通过多个团队之间的技术共享,我们不仅能够节省“造轮子”的时间,还能够确保我们的软件始终能够接触到新的技术。更有意义的是,这个社会中还可能包含全球不同时区的工作人员,这样一来就可以实现软件在一天24小时中都有人进行开发和维护,更加有利于提高软件开发效率和服务稳定性。

资源部署的虚拟化

正如上面所说,云计算将计算能力部署在云端,并通过网络来进行访问。这样做不仅有利于我们随时进行资源的扩展,更有利于节省空间和相关的硬件维护费用。云端的服务器集群还有利于数据的安全,更多的备份可以保障数据不容易丢失,这点是本地储存很难避免的。

云计算面临的挑战 虽然云计算有着诸多的优点,但是它并不是万能的。在某些场景下,传统的软件开发仍然有着不可替代的地位。

数据传输的瓶颈

在传统的软件开发中,我们的开发平台一般距离服务器很近,因此数据传输的速度也很快。但是云计算因为需要将数据上传到网络上进行计算,在面对大量数据传输的时候可能会出现数据传输瓶颈的问题,尤其是我国的访问国外的部分网站较为困难,这给我们的软件开发和运行都造成了不可忽视的影响。

数据的机密性

云端数据的安全性仅是保证数据不丢失,但是如果涉及特别私密的数据,还是应当采用传统的软件开发方法进行开发,并且将数据在本地进行储存。

大型分布式系统的弊端

大型的分布式系统虽然能够保证存储大量的数据,但是很难做到实时响应。因此像通信部门等需要实时响应的软件不宜部署在云端。

云计算的诸多优点已然给传统软件工程带来了诸多转变。我们在进行软件开发之前,需要先分析我们的软件到底适不适合使用云平台进行开发或运行。在笔者看来,未来的一段时间之内,传统的软件开发和云计算的软件开发将会共存。现阶段随着网络的飞速发展,云计算将有更大的增长空间,并且会给我们带来更多的价值。

# 1.4 云计算历史,现状与趋势

计算机自上世纪40年代发明以来,一直处于孤岛状态,网络一方面没有需求,另外一方面也处于探索阶段,《浪潮之巅》的作者很清晰的介绍了计算机历史的不同阶段出现的伟大公司的辉煌和沉沦,比如贝尔、微软和 IBM。

在上世纪90年代,网络大爆炸,一大批公司粉墨登场,随即网络进入泡沫时代。在离我们并不遥远的互联网泡沫破碎的时候,Web 2.0兴起,网络踏上了新的征程。

在 Web 2.0 的时代,很多细分化网站的访问量远超过传统门户网站。如何有效地为巨大的用户群体服务,让用户也能够享受方便、快捷的服务,成为这些网站不得不面对的一个问题。

而与此同时,一些有影响力的大公司为了提高自身产品的服务能力和计算能力开发了大量新技术,如何有效利用已有技术并结合新技术,为更多的企业或个人提供强大的计算能力与多样化的服务,就成为许多拥有巨大服务器资源的企业必须考虑的问题。

正是因为网络用户的急剧增多并对计算能力的需求愈加旺盛,而计算机等 IT 设备公司、软件公司和计算服务提供商能够满足这样的需求。能否像用电一样,来使用计算机的资源呢?于是一拍即合,云计算便应运而生。

值得提一下的是,2006年8月9日,谷歌(Google)首席执行官埃里克·施密特(Eric Schmidt)在搜索引擎大会首次提出“云计算”(Cloud Computing)的概念。但是其实云计算的概念早在20多年前就开始启蒙了,那是1983年,Sun Microsystems 提出“网络即计算机”的概念;2006年3月,亚马逊(Amazon)推出弹性计算云(Elastic Compute Cloud,EC2)服务。

让我们梳理下云服务的发展、演化各个阶段的历史。

- 前期积累阶段:1983年,Sun 公司提出“网络即计算机”的概念,在那个年代,并行计算,分布式处理和虚拟化技术逐渐成熟。

- 云服务初级阶段:此阶段以一批公司的成立为标志,最著名的为1999年3月 Salesforce 成立,提供云服务,即 SaaS;1999年9月 LoudCloud 成立,提供服务器出租,即 IaaS。

- 云服务形成阶段:此时历史的脚步已经踏进了2006年,云概念由 Google 提出,Amazon 推出了弹性计算云服务;2007年8月,Salesforce 发布 Force.com 成为最早的 PaaS。

- 云服务快速发展阶段:这个阶段,云服务规模高速成长。云服务功能日趋完善、种类日趋多样。各种云服务演化精彩纷呈,很多传统企业结合自身能力扩展、转型,纷纷投入云服务市场。

- 云服务成熟阶段:很多科技产品或热点,都在2016年始称元年。

因此,云计算的发展,主要历经了下面三个阶段:

- 产品功能健全,市场格局相对稳定;

- 专业领域划分细致,个性化需求也能得到灵活响应;

- 主流平台和标准日渐形成,客户和设备规模巨大。

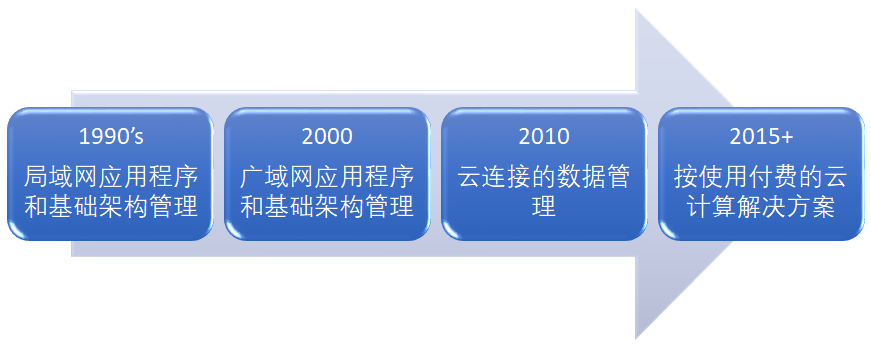

从功能角度,云平台的历史演化路线大致如下。

图1.4.1 云平台的历史演化路线

从商务角度,我们再来看看云平台的市场情况。

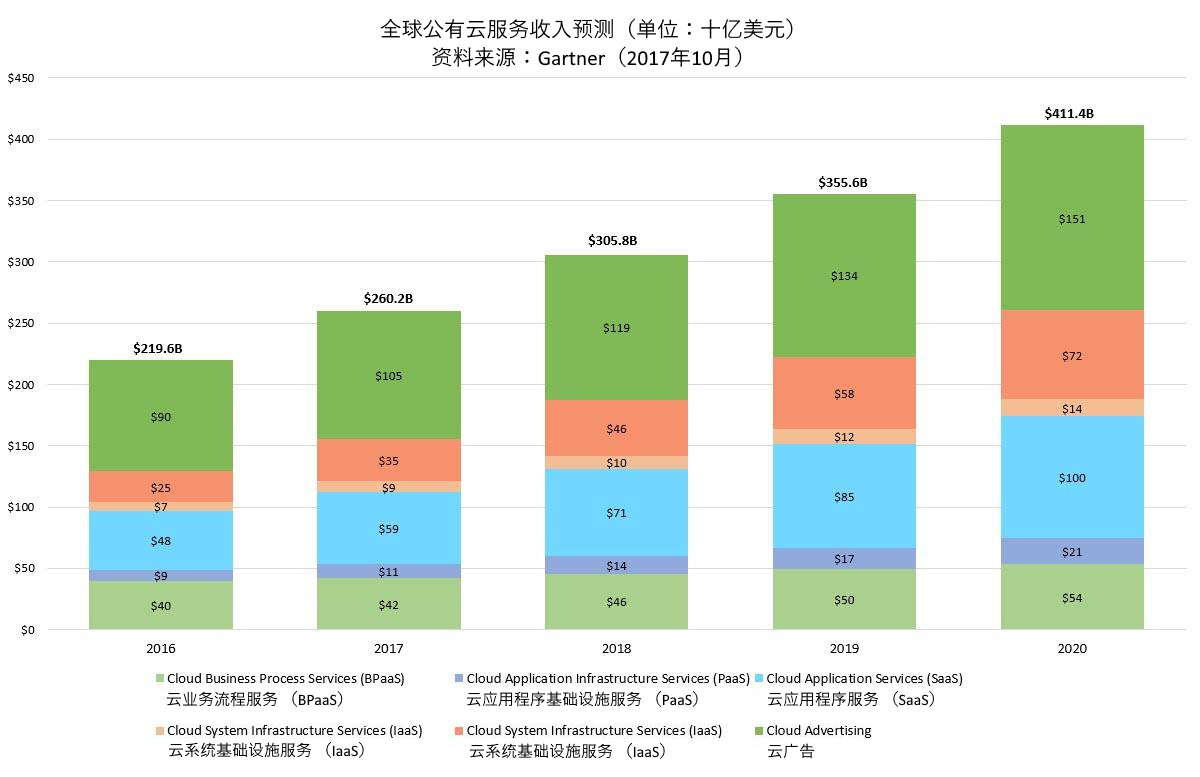

公有云的全球市场需求,据 Gartner 预测在2020年将达到 $4114 亿美金。

图1.4.2 公有云的全球市场需求增长趋势

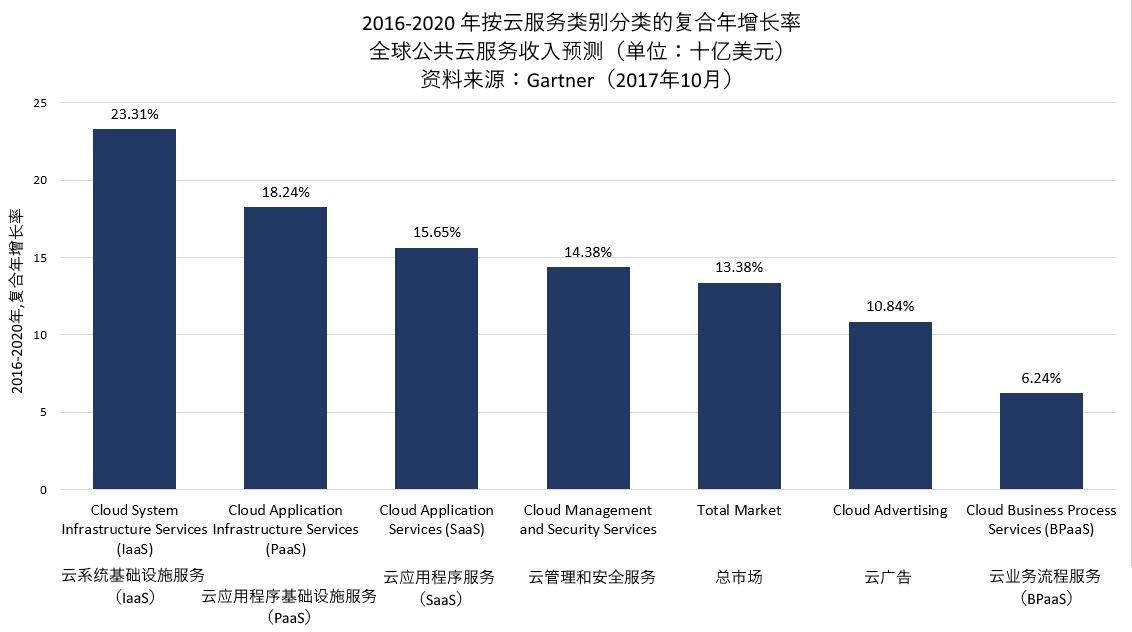

而其中各个细分市场的年化增长率预测为:

图1.4.3 公有云的细分市场全球需求增长率预测

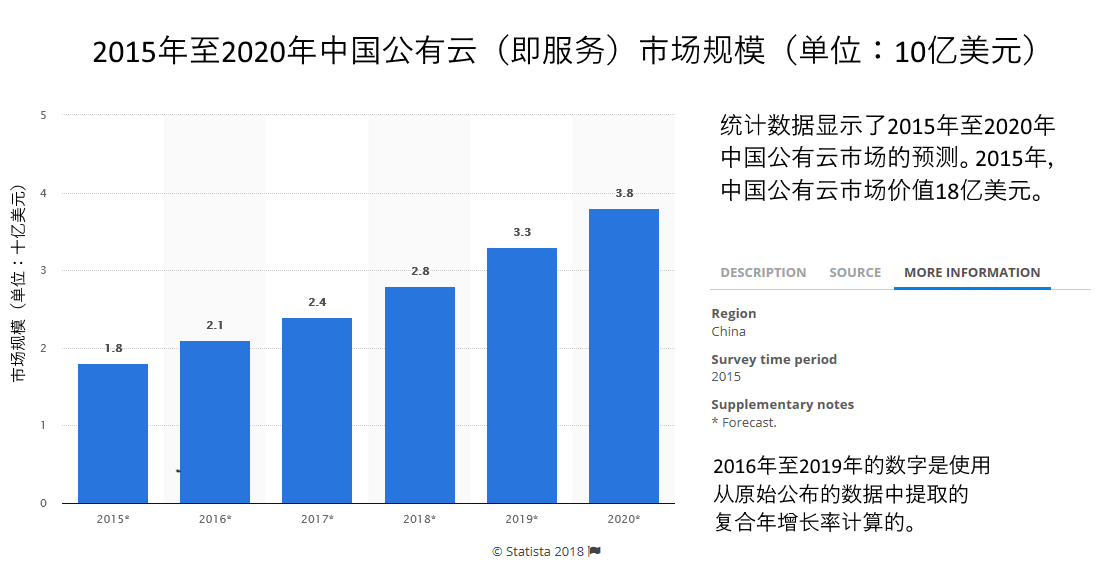

国内云服务市场由于起步晚需求大,近年来一直保持着高速的增长。据 Statista.com 网站在2015年的数据预测,中国国内公有云市场的预估值是在2020年达到38亿美金。

图1.4.4 公有云的国内市场需求增长预测

出自英文原文: https://www.statista.com/statistics/600098/china-public-cloud-market-size/ (opens new window)

综上可见,云平台的市场,不管是国内还是国外,现今看来都是处于高速增长阶段。

# 1.5 云计算核心技术

云计算是一种以数据和处理能力为中心的密集型计算模式,它融合了多项 ICT (Information Communications Technology)技术,是传统技术“平滑演进”的产物。其中以虚拟化技术、分布式数据存储技术、资源管理、编程模型、大规模数据管理技术、信息安全、云计算平台管理技术、绿色节能技术最为关键。

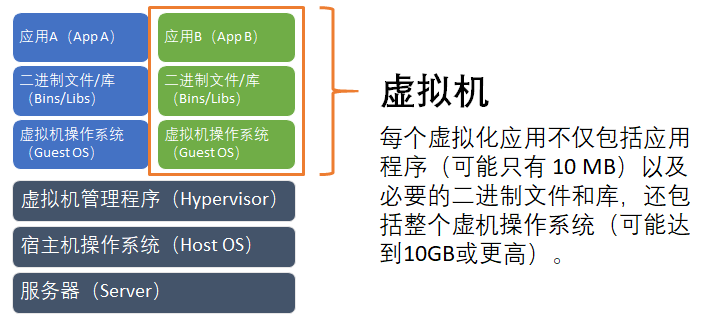

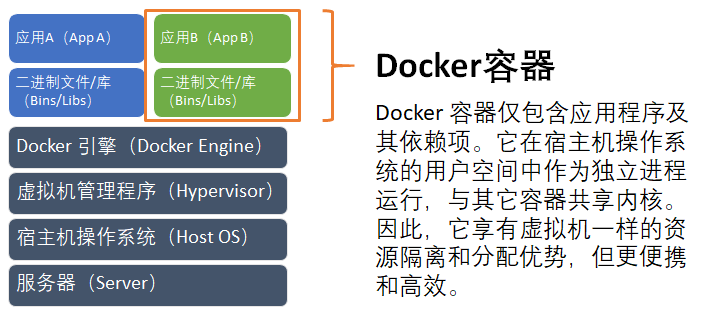

1. 虚拟化技术 虚拟化是云计算最重要的核心技术之一,它为云计算服务提供基础架构层面的支撑。

从技术上讲,虚拟化是一种在软件中仿真计算机硬件,以虚拟资源为用户提供服务的计算形式。旨在合理调配计算机资源,使其更高效地提供服务。它把应用系统各硬件间的物理划分打破,从而实现架构的动态化,实现物理资源的集中管理和使用。虚拟化的最大好处是增强系统的弹性与灵活性、降低成本、改进服务,和提高资源利用效率。

从表现形式上看,虚拟化又分两种应用模式。一是将一台性能强大的服务器虚拟成多个独立的小服务器,服务不同的用户。二是将多个服务器虚拟成一个强大的服务器,完成特定的功能。这两种模式的核心都是统一管理,动态分配资源,提高资源利用率。在云计算中,这两种模式都有比较多的应用。

2. 分布式数据存储技术、资源管理

云计算的另一大优势就是能够快速、高效地处理海量数据。在数据爆炸的今天,这一点至关重要。为了保证数据的高可靠性,云计算通常会采用分布式存储技术,将数据存储在不同的物理设备中。这种模式不仅摆脱了硬件设备的限制,同时扩展性更好,能够快速响应用户需求的变化。

分布式存储与传统的网络存储并不完全一样,传统的网络存储系统采用集中的存储服务器存放所有数据,存储服务器成为系统性能的瓶颈,不能满足大规模存储应用的需要。分布式网络存储系统采用可扩展的系统结构,利用多台存储服务器分担存储负荷,利用位置服务器定位存储信息,它不但提高了系统的可靠性、可用性和存取效率,还易于扩展。

在当前的云计算领域,Google 的 GFS (Google File System,或 GoogleFS)和 Hadoop 开发的开源系统 HDFS (Hadoop Distributed File System)是比较流行的两种云计算分布式存储系统。

云计算采用了分布式存储技术存储数据,那么自然要引入分布式资源管理技术。在多节点的并发执行环境中,各个节点的状态需要同步,并且在单个节点出现故障时,系统需要有效的机制保证其它节点不受影响。而分布式资源管理系统恰是这样的技术,它是保证系统状态稳定的关键。

另外,云计算系统所处理的资源往往非常庞大,少则几百台服务器,多则上万台,同时可能跨跃多个地域。且云平台中运行的应用也是数以千计,如何有效地管理这批资源,保证它们正常提供服务,需要强大的技术支撑。因此,分布式资源管理技术的重要性可想而知。

3. 编程模式

从本质上讲,云计算是一个多用户、多任务、支持并发处理的系统。高效、简捷、快速是其核心理念,它旨在通过网络把强大的服务器计算资源方便地分配到终端用户手中,同时保证低成本和良好的用户体验。在这个过程中,编程模式的选择至关重要。云计算项目中分布式并行编程模式将被广泛采用。

分布式并行编程模式创立的初衷是更高效地利用软、硬件资源,让用户更快速、更简单地使用应用或服务。在分布式并行编程模式中,后台复杂的任务处理和资源调度对于用户来说是透明的,这样用户体验能够大大提升。MapReduce 是当前云计算主流并行编程模式之一。MapReduce 模式将任务自动分成多个子任务,通过 Map 和 Reduce 两步实现任务在大规模计算节点中的分配和汇总。

4. 大规模数据管理

处理海量数据是云计算的一大优势。那么如何处理则涉及到很多层面的东西,因此高效的数据处理技术也是云计算不可或缺的核心技术之一。对于云计算来说,数据管理面临巨大的挑战。云计算不仅要保证数据的存储和访问,还要能够对海量数据进行特定的检索和分析。由于云计算需要对海量的分布式数据进行处理、分析,因此,数据管理技术必需能够高效的管理大量的数据。

Google 的 BT(BigTable)数据管理技术和 Hadoop 团队开发的开源数据管理模块 HBase 是业界比较典型的大规模数据管理技术。

- BigTable 是非关系的数据库,是一个分布式的、持久化存储的多维度排序 Map。BigTable 的设计目的是可靠的处理 PB 级别的数据,并且能够部署到上千台机器上。

- HBase 是 Apache 的 Hadoop 项目的子项目,定位于分布式、面向列的开源数据库。作为高可靠性分布式存储系统,HBase在性能和可伸缩方面都有比较好的表现。利用 HBase 技术可在廉价 PC 服务器上搭建起大规模结构化存储集群。

5. 信息安全

调查数据表明,安全已经成为阻碍云计算发展的最主要原因之一。数据显示,32%已经使用云计算的组织和45%尚未使用云计算的组织的 ICT 管理将云安全作为进一步部署云的最大障碍。因此,要想保证云计算能够长期稳定、快速发展,安全是首先需要解决的问题。

事实上,云计算安全并不是新问题,传统互联网存在同样的问题。只是云计算出现以后,安全问题变得更加突出了。在云计算体系中,安全涉及到很多层面,包括网络安全、服务器安全、软件安全、系统安全等等。因此,有分析师认为,云安全产业的发展,将把传统安全技术提高到一个新的阶段。

现在,不管是软件安全厂商还是硬件安全厂商都在积极研发云计算安全产品和方案。包括传统杀毒软件厂商、软硬防火墙厂商、IDS/IPS (入侵检测系统 Intrusion Detection Systems, 入侵防御系统 Intrusion Prevention System)厂商在内的各个层面的安全供应商都已加入到云安全领域。相信在不久的将来,云安全问题将会越来越被重视。

6. 云计算平台管理

云计算资源规模庞大,服务器数量众多并且分布在不同的地点,同时运行着数百种应用,如何有效地管理这些服务器,保证整个系统提供不间断的服务是巨大的挑战。云计算系统的平台管理技术,需要具有高效调配大量服务器资源,使其更好协同工作的能力。其中,方便地部署和开通新业务、快速发现并且恢复系统故障、通过自动化、智能化手段实现大规模系统可靠的运营是云计算平台管理技术的关键。

对于云平台提供者而言,云计算可以有三种部署模式,即公共云、私有云和混合云。三种模式对平台管理的要求大不相同。对于用户而言,由于企业对于 ICT 资源共享的控制、对系统效率的要求以及 ICT 成本投入预算不尽相同,企业所需要的云计算系统规模及可管理性能也大不相同。因此,云计算平台管理方案要更多地考虑到定制化需求,能够满足不同场景的应用需求。

包括 Google、IBM、Microsoft、Oracle 等在内的许多厂商都有云计算平台管理方案推出。这些方案能够帮助企业实现基础架构整合、实现企业硬件资源和软件资源的统一管理、统一分配、统一部署、统一监控和统一备份,打破应用对资源的独占,让企业云计算平台价值得以充分发挥。

7. 绿色节能技术

节能环保是全球整个时代的大主题。云计算也以低成本、高效率著称。云计算具有巨大的规模经济效益,在提高资源利用效率的同时,节省了大量能源。绿色节能技术已经成为云计算必不可少的技术,未来越来越多的节能技术还会被引入到云计算中来。报告指出,迁移至云端的美国公司每年可以减少碳排放8570万吨,这相当于2亿桶石油所排放出的碳总量。总之,云计算服务提供商们需要持续改善技术,让云计算更绿色。

# 1.6 云应用系统开发技术综述

云技术是指在广域网或局域网内将硬件、软件、网络等系列资源通过虚拟化统一管理,实现数据的计算、储存、处理和共享的一种托管技术。 云计算正蓬勃发展, 云计算技术和云平台已经变成重要的基础支撑平台。

云平台是近些年才得到业界广泛关注的,它发展迅猛,在 IaaS、PaaS 和 SaaS 层有大量不同厂商非标准的实现。我们使用云平台应该考虑这些因素,尽量采用标准化的,容易迁移的服务,慎用或少用厂商独有的,很难或根本无法迁移的服务。

基于云平台的软件开发具有与传统软件开发不同的模式和方法,随着云计算技术的深入发展,软件开发的模式和方法需要进行调整,以更好地适应新的应用环境需求。

云计算和云平台的知识面很宽泛,还涉及到很多云厂商非标准的实现,但最本质的还是提供互联网应用程序开发和部署的基础环境。

本书面对初学者,将仅关注标准化的基础服务,讲述它在软件开发过程中的应用。这将涉及到:

- 开发与测试:分布式版本控制系统(Git)、自动化测试;

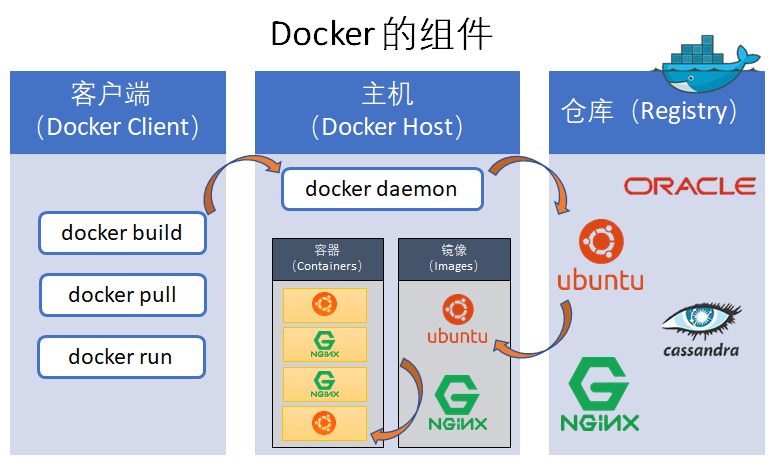

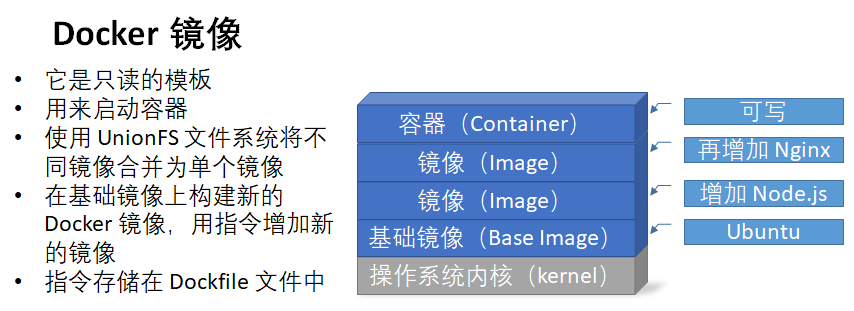

- 部署和运维:持续集成与部署、容器(Docker)、DevOps。

这些技术源自传统软件开发过程,适用于云平台环境下,对互联网应用软件开发有一定参考意义。

# 习题

- 简述什么是云计算。

- 简述云计算的服务模型分类:IaaS、PaaS 和 SaaS,它们所代表的英文全称和中文解释,并举例现实生活中的一个服务或应用。

- 微软的 Office 365、网易云音乐、QQ 邮箱、百度网盘、阿里云虚拟主机、Google AppEngine、Salesforce.com 这些常见的服务,应该归属于哪一类(指 IaaS、PaaS 和 SaaS)?

# 第2章 VirtualBox 虚拟机

Oracle VirtualBox(网址是 https://www.virtualbox.org/ (opens new window)) 是一款知名的开源虚拟机软件,本书后续的实验都将在 Oracle VirtualBox 创建的 Ubuntu Server 虚拟机上完成。虚拟机上安装部分软件的步骤也将逐一介绍,注意它们具有依赖性,因此需要按顺序安装。

VirtualBox 扩展功能的使用还可以参考“附录A - VirtualBox”。

# 2.1 安装 Oracle VirtualBox

Oracle VirtualBox 在 Windows 操作系统上的安装过程很简单。因为开启虚拟机将占用较多内存,推荐 Windows 宿主机器是64位操作系统,且内存至少 8GB 以上。

安装步骤如下:

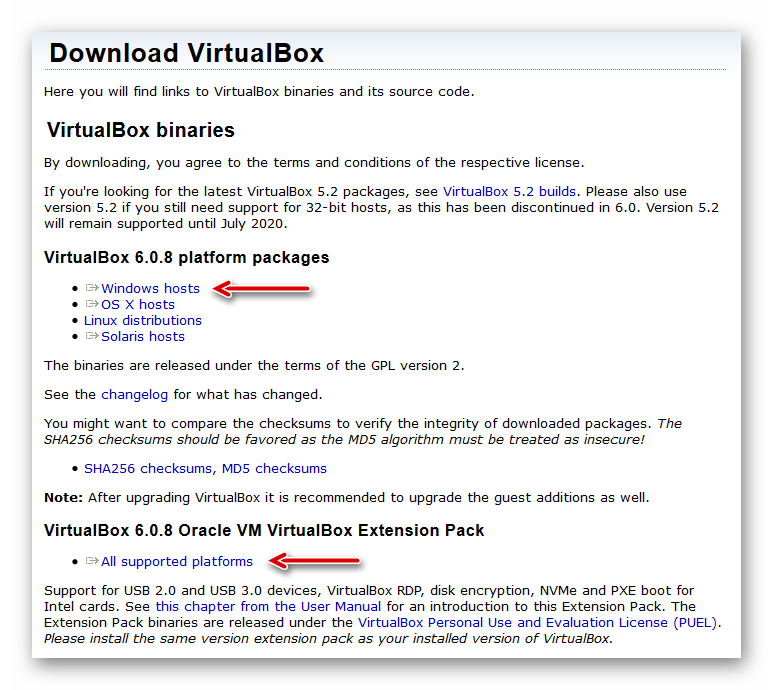

假设 6.0 系列发行版的最新版本是“6.0.8” ,下载 “Windows hosts” 和 “Extension Pack”(如下图)。读者看到的版本应该已经更新,请视情况调整。

图2.1.1 VirtualBox 6.0 下载网页

下载完成后可见:

VirtualBox-6.0.8-130520-Win.exe和Oracle_VM_VirtualBox_Extension_Pack-6.0.8.vbox-extpack共2个文件。

图2.1.2 VirtualBox 6.0 的安装文件

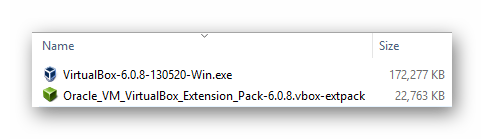

安装 VirtualBox 必须要有管理员权限。以默认的设置和安装路径,先安装

VirtualBox-6.0.8-130520-Win.exe。安装过程中会导致暂时的网络中断,且需要重启 Windows 宿主机。安装完成并重新启动宿主 Windows 计算机后,可以看到

Oracle_VM_VirtualBox_Extension_Pack-6.0.8.vbox-extpack的图标正常显示为绿色小盒子,双击即可安装此扩展包。如果碰到图标未能正常显示,也可以将它拖到 VirtualBox 在桌面的图标上来安装。

需要注意的是,Extension Pack 必须和 VirtualBox 安装相同版本,它包含了很多有用的功能增强,是必须安装的。

本书附录 A 还有 VirtualBox 的进阶使用介绍,供读者参考。

# 2.2 安装 Ubuntu Server 虚拟机

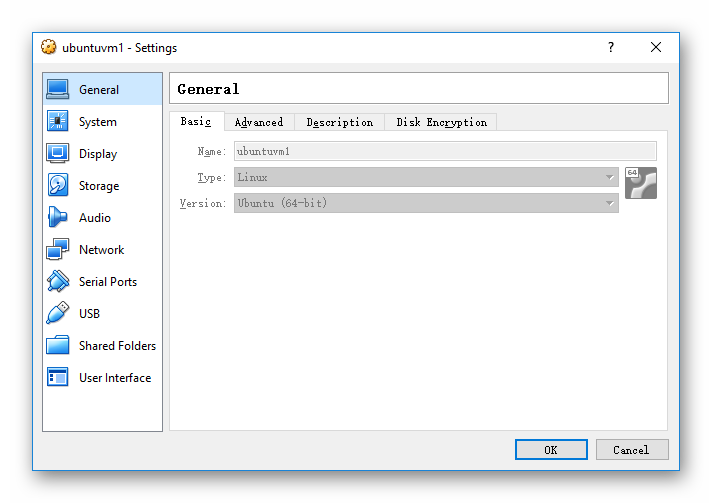

Oracle VirtualBox 安装完成后,我们在 VirtualBox 里创建一个64位 Linux 类型的虚拟机,取名为 “ubuntuvm1”,给它分配 2GB 内存和 80GB 硬盘存储空间。注意这里分配的 80G 硬盘存储空间只是设定了虚拟硬盘的上限,而它实际占用的磁盘空间是根据写入内容的多少相关,因此不必担心一开始它就占用 80G 的磁盘存储空间。相反的,如果我们在创建虚拟机时把硬盘存储空间分配小了,到后面不够用,则扩容会很麻烦,甚至可能不得不重新安装虚拟机。

如下图所示创建虚拟机。输入虚拟机的名称(Name),这里是“ubuntuvm1”,注意选择正确的类型(Type)和版本(Version)。

图2.2.1 VirtualBox Ubuntu 虚拟机设置之通用

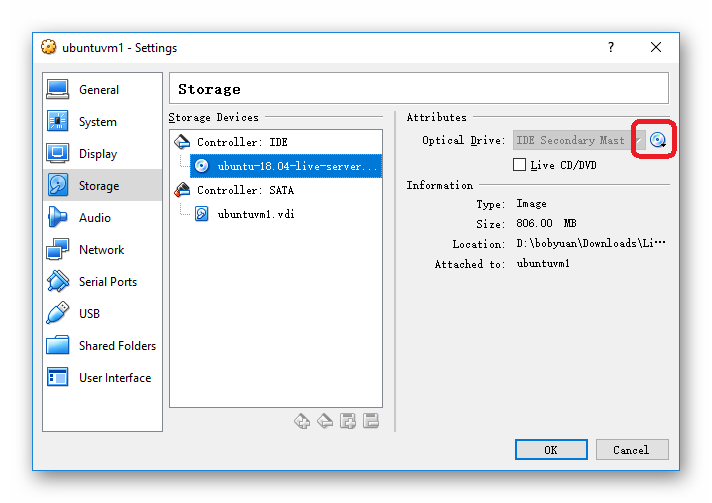

到 Ubuntu Server 官方下载页面(网址是 https://www.ubuntu.com/download/server (opens new window))下载安装光盘镜像文件。请选择下载标记为 LTS 的版本,它是长期支持(Long-Term Support)的版本。例如下面例子中下载的是 ubuntu-18.04-live-server-amd64.iso。另外请注意,此服务器版只有64位的发行版。

在虚拟机 ubuntuvm1 的设置对话框里,将下载的发行版 ISO 文件装载到光盘驱动器里。

图2.2.2 VirtualBox Ubuntu 虚拟机设置之存储

启动虚拟机,即可开始 Ubuntu Server 的安装。大多以默认的选项安装,即以默认的美国英语安装,记得勾选“OpenSSH Server”(默认是不安装),具体过程可以参考 Installation Ubuntu Server(网址是 https://tutorials.ubuntu.com/tutorial/tutorial-install-ubuntu-server (opens new window)),此处从略。

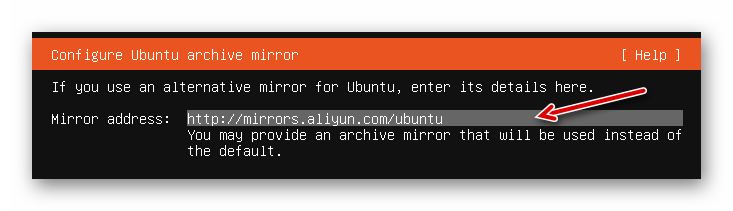

注意: 若您在国内访问国外网站速度过慢的情况下,可以考虑在安装过程中将官方 Ubuntu 的源替换成阿里云的 Ubuntu 镜像,这样会快些。

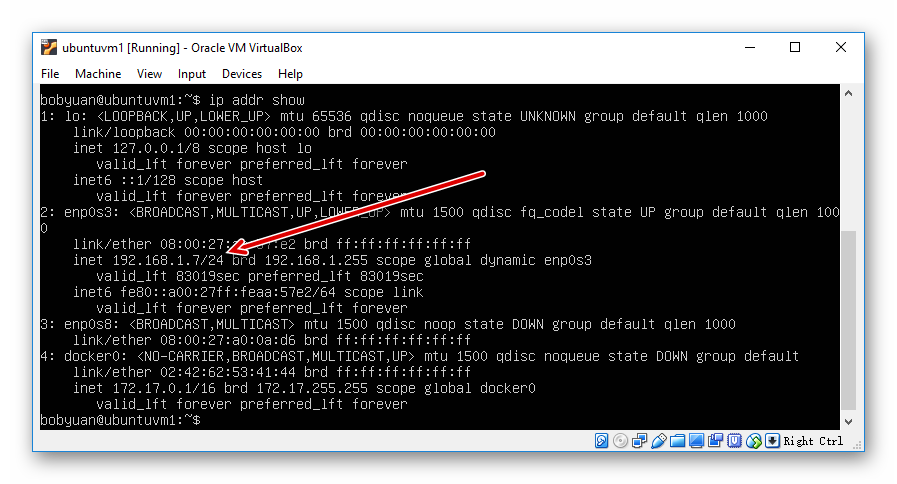

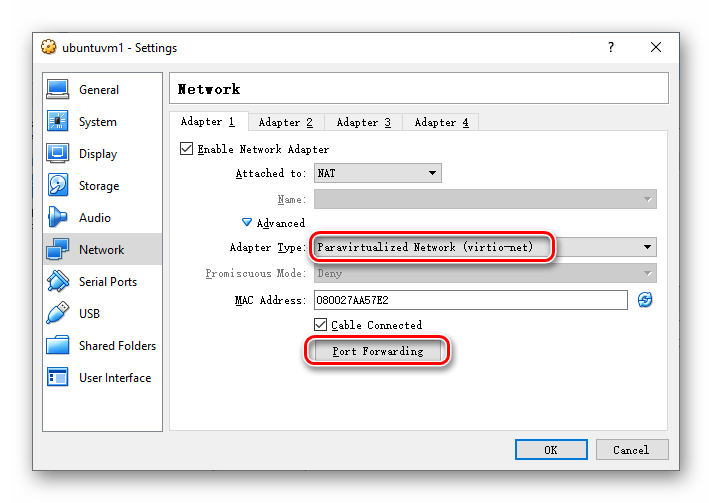

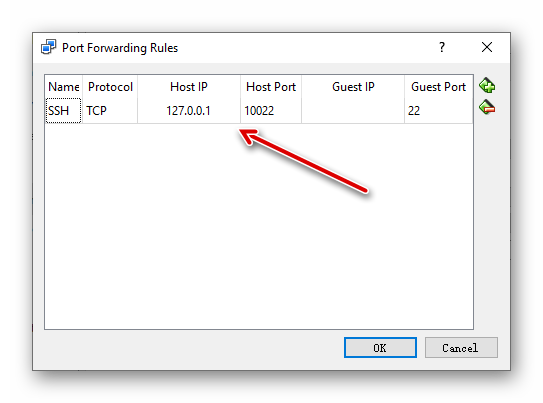

网络设置可以选择 “Bridged Adapter” ,即虚拟机的网卡桥接直连网络,这是最简单的方式。虚拟机启动完成后,登入虚拟机后用 ip addr show,也可以简写为ip addr, 或 ifconfig 命令来找到它的 IP 地址。例如,下图中可见,此虚拟机 ubuntuvm1 的 IPv4 地址是 192.168.1.7。

图2.2.3 VirtualBox Ubuntu 虚拟机的 IP 地址

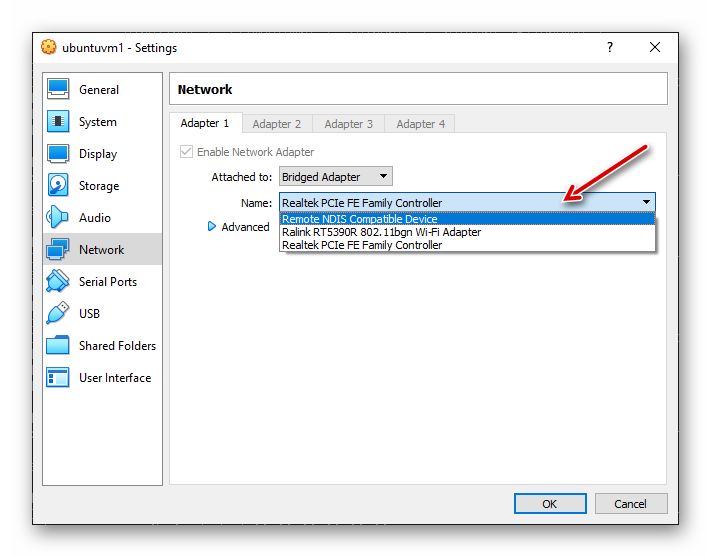

在虚拟机已经启动后,如果桥接模式下我们发现桥接的网络不对,可以在虚拟机的设置里更改,如下图:

图2.2.4 VirtualBox Ubuntu 虚拟机的桥接网络设置

更改成正确的桥接网络后,按“OK”按钮保存。我们还需要在虚拟机的命令行窗口中运行如下命令,重新启动网络让它生效。

sudo netplan apply

之后再去查看它新的 IP 地址。

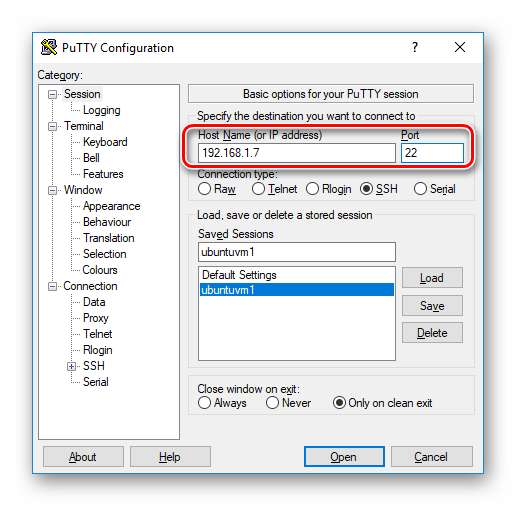

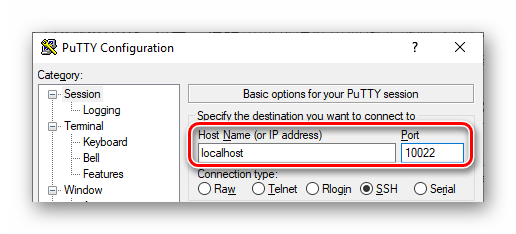

为了方便使用,我们将通过专门的 SSH 客户端软件,例如 PuTTY(网址是 https://putty.org/ (opens new window))或 MobaXterm(网址是 https://mobaxterm.mobatek.net (opens new window))来连接到此虚拟机。其中前者功能相对简单快捷,后者功能丰富,其免费的 Home 版在功能上略有限制,但也足够个人一般使用。SSH 客户端的安装从略。

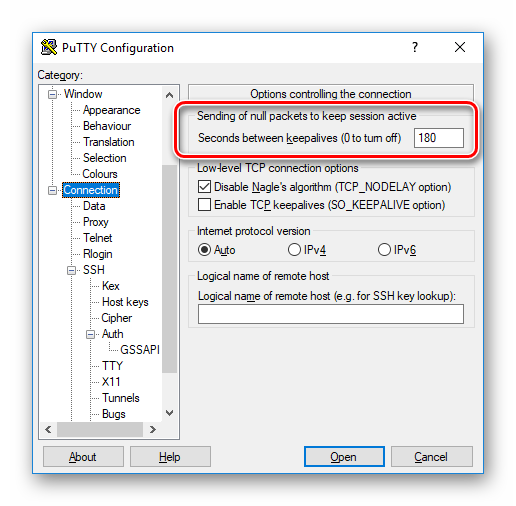

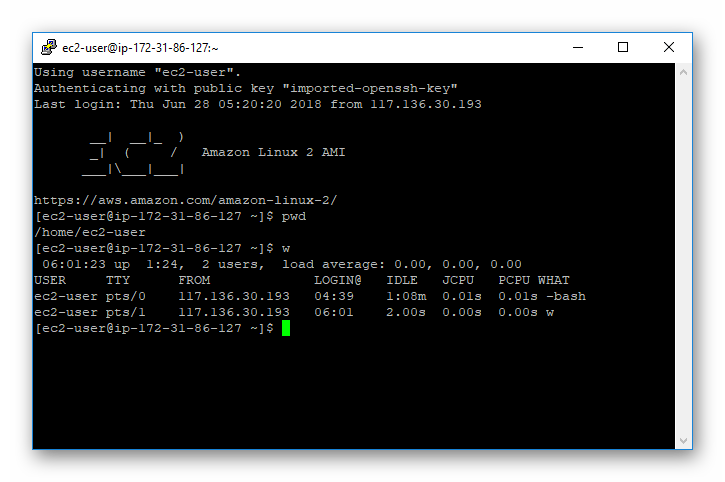

如果我们选择用开源免费的 PuTTY 作为 SSH 客户端,请按下图设置连接到此虚拟机(指定虚拟机的 IP 地址,SSH 服务默认侦听的22端口)。可以取名为“ubuntuvm1”并保存配置,方便下一次快速载入。

图2.2.5 VirtualBox Ubuntu 虚拟机的 PuTTY 连接设置

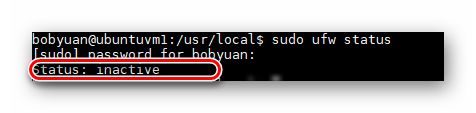

登入后,检查防火墙状态。默认情况下,Ubuntu Server 虚拟机 ubuntuvm1 的防火墙是关闭的(Status: inactive)。本虚拟机是测试环境,暂不考虑安全性,为避免网络连接被防火墙阻隔的问题,可以暂不开启防火墙。

# check firewall status.

sudo ufw status

屏幕显示示例应该如下图。

图2.2.6 VirtualBox Ubuntu 虚拟机的防火墙状态

将系统更新到最新。

# update system to latest.

sudo apt update -y

sudo apt upgrade -y

注意: apt 是继 apt-get 后的改进版命令行工具,它在2016年发布的 Ubuntu 16.04 中首次引入,日常使用上可以取代旧版的 apt-get 命令。也就是说,在 Ubuntu 16.04 和后续的 Ubuntu 操作系统中,apt-get 命令依然存在且可以使用,但在多数情况下,我们可以使用 apt 命令来取代旧版的 apt-get 命令。关于它们的区别,可以阅读这篇文章:

- Difference Between apt and apt-get Explained https://itsfoss.com/apt-vs-apt-get-difference/ (opens new window)

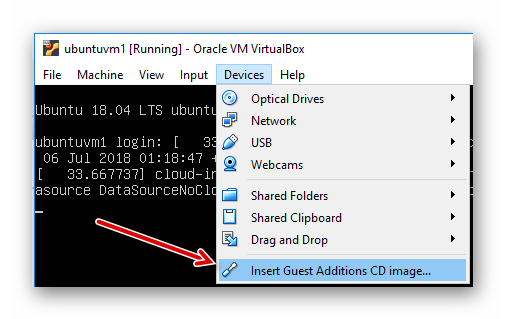

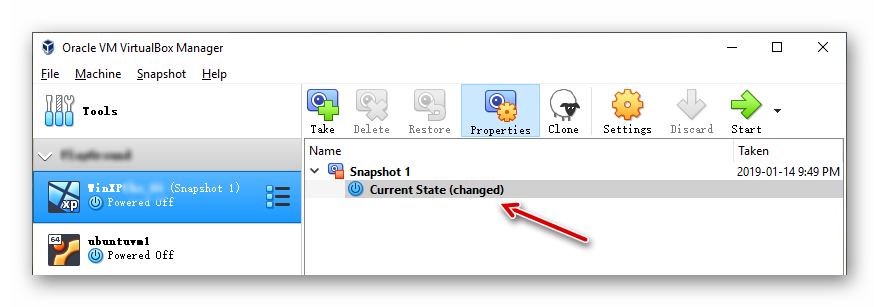

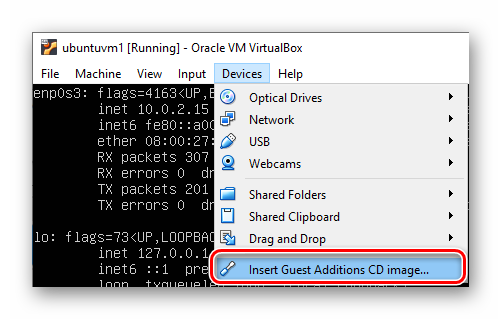

下面安装 “VirtualBox Guest Additions CD”。先在虚拟机的窗口如下图放入光盘。

图2.2.7 VirtualBox Ubuntu 虚拟机放入 Guest Additions 光盘镜像

挂载光盘并安装。

# mount the CD-ROM.

sudo mkdir -p /mnt/cdrom

sudo mount /dev/cdrom /mnt/cdrom

# launch the installer.

cd /mnt/cdrom

sudo ./VBoxLinuxAdditions.run

# check the installed version.

ls /opt | grep VBox

安装完成后,在虚拟机设置里面将此光盘移除,可能需要重启虚拟机(reboot)。

# reboot the machine.

sudo reboot

若实验完成后,需要关闭虚拟机,我们可以用如下任一命令:

# poweroff the machine.

sudo poweroff

# shutdown the machine now.

sudo shutdown -h now

# 2.3 安装 OpenJDK

以下内容是在 Ubuntu Server 虚拟机 ubuntuvm1 上安装免费开源的 OpenJDK (网址是 https://openjdk.java.net (opens new window))。当然,也可以选择 Oracle JDK (网址是 http://www.oracle.com/technetwork/java/javase/downloads/index.html (opens new window))。

关于安装 JDK (Java Development Kit,开发工具包) 的版本,我们这里建议安装 Java SE 8,其原因是:

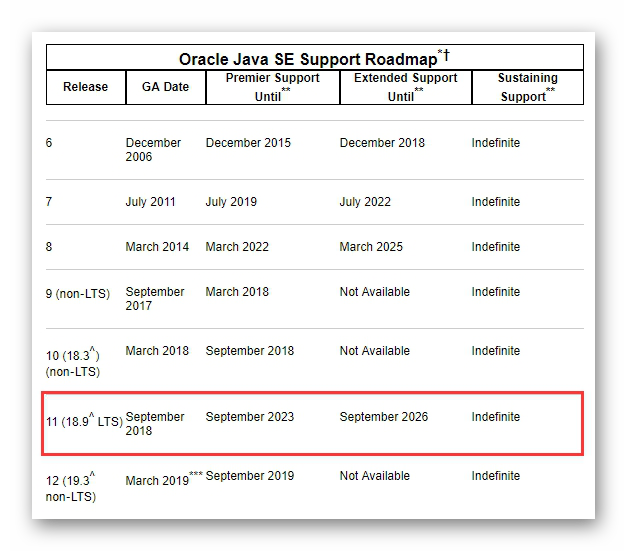

Oracle Java SE 9 、10、12 是非长期支持版本,Java SE 8 因推出的时间久(2014年3月)而支持更为广泛,因此安装 JDK 8 是当前相对稳妥的选择。后续的长期支持版本(Long Term Support, LTS)是 JDK 11,在2018年9月26日发布,第三方软件在11上的支持还不够广泛。

Oracle Java SE 11 是继 Java 8之后首个长期支持版本,也是 Java SE 的首个长期支持版本。根据官方支持路线图,Java 11 的高级支持将持续到2023年9月,扩展支持则会延续到2026年9月,也就是生命周期长达8年。非长期支持的版本例如 Java 9、10、12 仅提供半年的技术支持。见下图:

图2.3.1 Oracle Java SE 技术支持路线图

Java SE 是否免费?这个问题有点复杂,接下来我们探究一下。

现在常见的 OpenJDK 和 Oracle JDK 以及其他服务商提供的变种版本,它们各自的授权许可是什么,又都提供哪些服务和支持,让许多 Java 开发者理不清头绪。Oracle 在2018年7月份启用新的 Java SE 订阅模式,更是让许多开发者认为是不是 Java 从此要开始收费了?

虽然 Java 11 LTS 已经发布,但从统计数据来看,至今(即本书写作时间,2019年)更多的开发者还停留在上一个 LTS 版本上,即 Java 8。关于开发者最为关注的 Java 8 的授权许可问题,官方文档给出了解答:

Oracle 将在2020年12月前为个人桌面用户继续提供 Oracle JDK 8 的公共更新。若是商业用途,则在2019年1月之后不会再有免费的商业版本更新。但是,自 Java SE 9 以后,Oracle 还提供了 OpenJDK 版本,可免费用于商业用途,并且还有其他服务商提供的免费 Open JDK 版本可供选择。

也就是说,商业用途如果在2019年1月之后想继续免费使用 Java 8,可以选择:

- 不再更新,继续无限期地使用旧版 Oracle JDK 8 。注意,这对于商业用途是存在安全隐患的;

- 使用来自其他服务商的免费 Java SE 8 或 OpenJDK 8 二进制发行版。

再有,由于 Oracle 在2018年7月份改变了 Java SE 的商业支持模式,所以从 Java 11 开始,支持方式有所不同:

- OpenJDK —— 使用 GPLv2 + CE 许可,可免费用于商业用途;

- Oracle JDK —— 使用付费商业许可,但个人和非商业使用免费。

总之,商业用途如果想要继续免费使用 Java 11 的,请选择 OpenJDK。

Ubuntu 18.04 服务器操作系统如果更新到最新,已经自带了OpenJDK 11 的 JRE (Java Runtime Environment,Java 运行环境),可以通过下面的命令进行检查:

bobyuan@ubuntuvm1:~$ java -version

openjdk version "11.0.3" 2019-04-16

OpenJDK Runtime Environment (build 11.0.3+7-Ubuntu-1ubuntu218.04.1)

OpenJDK 64-Bit Server VM (build 11.0.3+7-Ubuntu-1ubuntu218.04.1, mixed mode, sharing)

bobyuan@ubuntuvm1:~$ which java

/usr/bin/java

bobyuan@ubuntuvm1:~$ readlink -f $(which java)

/usr/lib/jvm/java-11-openjdk-amd64/bin/java

进一步的信息还有。

bobyuan@ubuntuvm1:~$ apt depends default-jdk

default-jdk

Depends: default-jre (= 2:1.11-68ubuntu1~18.04.1)

Depends: default-jdk-headless (= 2:1.11-68ubuntu1~18.04.1)

Depends: openjdk-11-jdk

bobyuan@ubuntuvm1:~$ apt list --installed | grep jdk

WARNING: apt does not have a stable CLI interface. Use with caution in scripts.

openjdk-11-jre-headless/bionic-updates,bionic-security,now 11.0.3+7-1ubuntu2~18.04.1 amd64 [installed,automatic]

为了保证 Ubuntu 操作系统的稳定性,我们不卸载默认安装的 OpenJDK 11 JRE,只是并行安装额外的 OpenJDK 8,修改符号链接和环境变量指向我们想要使用的那个 OpenJDK 8 即可。

如前所述,出于免费商业使用的考虑,推荐安装使用 OpenJDK 而非 Oracle JDK。在当前(2019年)JDK 8 的使用和支持更广泛,鉴于 JDK 11 新推出,部分应用程序的兼容性支持还不足的原因,我们将按如下方式安装 OpenJDK 8:

# update system to latest.

sudo apt update -y

sudo apt upgrade -y

# install OpenJDK 8.

sudo apt install openjdk-8-jdk

安装完成之后,我们需要设置它为默认的 JDK。先用下面命令进行查看:

# list the installed JDKs.

sudo update-java-alternatives --list

屏幕输出示例如下。

bobyuan@ubuntuvm1:~$ sudo update-java-alternatives --list

java-1.11.0-openjdk-amd64 1111 /usr/lib/jvm/java-1.11.0-openjdk-amd64

java-1.8.0-openjdk-amd64 1081 /usr/lib/jvm/java-1.8.0-openjdk-amd64

我们可以看到,第2个选项 java-1.8.0-openjdk-amd64 是我们想要设置为默认的选项。为了将 OpenJDK 8 设置为默认选项,可以用以下命令:

# set to use the specific JDK from the list.

sudo update-java-alternatives --set java-1.8.0-openjdk-amd64

屏幕输出示例如下。

bobyuan@ubuntuvm1:~$ sudo update-java-alternatives --set java-1.8.0-openjdk-amd64

update-alternatives: error: no alternatives for jaotc

update-alternatives: error: no alternatives for jdeprscan

update-alternatives: error: no alternatives for jhsdb

update-alternatives: error: no alternatives for jimage

update-alternatives: error: no alternatives for jlink

update-alternatives: error: no alternatives for jmod

update-alternatives: error: no alternatives for jshell

update-alternatives: error: no alternatives for mozilla-javaplugin.so

update-java-alternatives: plugin alternative does not exist: /usr/lib/jvm/java-8-openjdk-amd64/jre/lib/amd64/IcedTeaPlugin.so

更改完成后,检查一下:

bobyuan@ubuntuvm1:~$ readlink -f $(which java)

/usr/lib/jvm/java-8-openjdk-amd64/jre/bin/java

bobyuan@ubuntuvm1:~$ java -version

openjdk version "1.8.0_212"

OpenJDK Runtime Environment (build 1.8.0_212-8u212-b03-0ubuntu1.18.04.1-b03)

OpenJDK 64-Bit Server VM (build 25.212-b03, mixed mode)

一切正常,符合预期。

根据上面的屏幕输出信息,我们可以看到 OpenJDK 8 的实际安装路径是 /usr/lib/jvm/java-8-openjdk-amd64,于是我们用 root 用户修改适用于虚拟机系统全局的配置文件 /etc/profile,在文件末尾添加如下几行内容:

# added by bobyuan.

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

export JRE_HOME=/usr/lib/jvm/java-8-openjdk-amd64/jre

export PATH=$JAVA_HOME/bin:$PATH

这将使得上面两个环境变量(JAVA_HOME 和 JRE_HOME)成为虚拟机 ubuntuvm1 的全局环境变量。

重启虚拟机,让设置生效。最后,分别用普通用户和 root 用户都检查一下,屏幕输出示例如下:

bobyuan@ubuntuvm1:~$ echo $JAVA_HOME

/usr/lib/jvm/java-8-openjdk-amd64

bobyuan@ubuntuvm1:~$ echo $JRE_HOME

/usr/lib/jvm/java-8-openjdk-amd64/jre

bobyuan@ubuntuvm1:~$ which java

/usr/lib/jvm/java-8-openjdk-amd64/bin/java

bobyuan@ubuntuvm1:~$ java -version

openjdk version "1.8.0_212"

OpenJDK Runtime Environment (build 1.8.0_212-8u212-b03-0ubuntu1.18.04.1-b03)

OpenJDK 64-Bit Server VM (build 25.212-b03, mixed mode)

bobyuan@ubuntuvm1:~$ sudo -i

[sudo] password for bobyuan:

root@ubuntuvm1:~# echo $JAVA_HOME

/usr/lib/jvm/java-8-openjdk-amd64

root@ubuntuvm1:~# echo $JRE_HOME

/usr/lib/jvm/java-8-openjdk-amd64/jre

root@ubuntuvm1:~# which java

/usr/lib/jvm/java-8-openjdk-amd64/bin/java

root@ubuntuvm1:~# java -version

openjdk version "1.8.0_212"

OpenJDK Runtime Environment (build 1.8.0_212-8u212-b03-0ubuntu1.18.04.1-b03)

OpenJDK 64-Bit Server VM (build 25.212-b03, mixed mode)

输出符合预期,OpenJDK 8 安装完毕。

# 2.4 安装 Apache Maven

Apache Maven(网址是 http://maven.apache.org/ (opens new window))是一个开源项目,它是一个 Java 的构建工具。在虚拟机 ubuntuvm1 上安装仅需要一条命令:

# install apache-maven package.

sudo apt install maven

安装完毕后,测试一下是否正常。例如:

bobyuan@ubuntuvm1:~$ which mvn

/usr/bin/mvn

bobyuan@ubuntuvm1:~$ mvn --version

Apache Maven 3.6.0

Maven home: /usr/share/maven

Java version: 1.8.0_212, vendor: Oracle Corporation, runtime: /usr/lib/jvm/java-8-openjdk-amd64/jre

Default locale: en_US, platform encoding: UTF-8

OS name: "linux", version: "4.15.0-52-generic", arch: "amd64", family: "unix"

至此,Apache Maven 已经安装完毕。根据上面的信息,我们可以看到 Maven 的实际安装路径是 /usr/share/maven。当前用户的 ~/.m2 文件夹存放着当前用户的设置,还有本地的 jar 包库(repository)。

以上是使用 apt 命令从 Ubuntu 发行版的软件仓库里安装,推荐用这种方式安装,最为简单。

我们有可能会碰到这样一种情况,Maven 的最新版已经发布了一段时间,但还未加入到 Ubuntu 发行版的软件仓库里,导致用上面的方式安装的是旧版。在这种情况下,若希望安装 Maven 的最新版本,可以选择手动安装。

手动安装的步骤也非常简单,请参考下面的步骤。或者参考官方的安装文档(网址是 http://maven.apache.org/install.html (opens new window))。

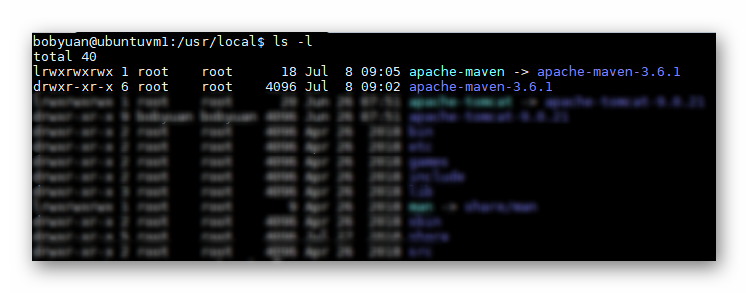

假设我们在 Maven 的官方网站看到最新版是 3.6.1,想选择手动安装这个最新版。我们到官方网站下载最新版的安装包 apache-maven-3.6.1-bin.tar.gz 到当前用户的 Home 文件夹中,想将它安装在 /usr/local 文件夹里。按以下步骤解包并创建符号链接。

# move to the target directory.

cd /usr/local

# extract the release package.

sudo tar zxf ~/apache-maven-3.6.1-bin.tar.gz

# create symbolic link to the real installation.

sudo ln -s apache-maven-3.6.1 apache-maven

完成后,用 ls -la 命令查看文件清单,我们可以看到类似这样的输出。它显示 apache-maven 符号链接指向真正的安装路径 apache-maven-3.6.1。后面我们将使用此符号链接来设置环境变量。之所以使用符号链接,其目的是,若后期我们升级 Maven 到其他的安装版,将仅需要修改此符号链接指向新的安装版路径即可。

图2.4.1 列文件清单查看Maven的安装

用 root 用户修改 /etc/profile 文件。如下例所示,添加了 M2_HOME 环境变量,并修改了环境变量 PATH,将 M2_HOME/bin 添加到 PATH 路径中。

# added by bobyuan.

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

export JRE_HOME=/usr/lib/jvm/java-8-openjdk-amd64/jre

export M2_HOME=/usr/local/apache-maven

export PATH=$JAVA_HOME/bin:$M2_HOME/bin:$PATH

至此手动安装已经完毕。我们退出当前用户,重新登入后,检查一下。

屏幕输出示例如下。

bobyuan@ubuntuvm1:~$ which mvn

/usr/local/apache-maven/bin/mvn

bobyuan@ubuntuvm1:~$ mvn --version

Apache Maven 3.6.1 (d66c9c0b3152b2e69ee9bac180bb8fcc8e6af555; 2019-04-04T19:00:29Z)

Maven home: /usr/local/apache-maven

Java version: 1.8.0_212, vendor: Oracle Corporation, runtime: /usr/lib/jvm/java-8-openjdk-amd64/jre

Default locale: en_US, platform encoding: UTF-8

OS name: "linux", version: "4.15.0-52-generic", arch: "amd64", family: "unix"

可以看到,它显示的路径和版本,都符合我们的预期。

Maven 的基本使用请参考官方用户手册文档(网址是 http://maven.apache.org/users/index.html (opens new window))。 另外,还有多本 Maven 的相关书籍,例如《Maven 实战》,《Maven 应用实战》等。

# 2.5 安装 Jenkins

Jenkins(网址是 https://jenkins.io/ (opens new window)) 是一个开源项目,它是一个基于 Java 的持续集成系统。我们可以在 Jenkins 上配置持续集成的任务,让机器自动完成构建(build),集中展示集成中存在的错误,提供详细的日志文件,提醒功能,以及用图表的形式展示项目构建的趋势和稳定性。

在 Ubuntu 上安装 Jenkins,请参考官方安装文档:

https://jenkins.io/doc/book/installing/#debian-ubuntu (opens new window)

下面的步骤选择用 apt-get 方式来安装,具体命令如下。如果网络访问较慢,请耐心等待。

wget -q -O - https://pkg.jenkins.io/debian/jenkins.io.key | sudo apt-key add -

sudo sh -c 'echo deb http://pkg.jenkins.io/debian-stable binary/ > /etc/apt/sources.list.d/jenkins.list'

sudo apt-get update

sudo apt-get install jenkins

安装完成后,它会自动启动 Jenkins 服务。我们看一下它的状态,从屏幕输出可以看到,它当前正常运行。

bobyuan@ubuntuvm1:~$ sudo systemctl status jenkins

● jenkins.service - LSB: Start Jenkins at boot time

Loaded: loaded (/etc/init.d/jenkins; generated)

Active: active (exited) since Wed 2018-07-11 09:09:56 UTC; 50s ago

Docs: man:systemd-sysv-generator(8)

Tasks: 0 (limit: 2322)

CGroup: /system.slice/jenkins.service

Jul 11 09:09:55 ubuntuvm1 systemd[1]: Starting LSB: Start Jenkins at boot time...

Jul 11 09:09:55 ubuntuvm1 jenkins[5787]: Correct java version found

Jul 11 09:09:55 ubuntuvm1 jenkins[5787]: * Starting Jenkins Automation Server jenkins

Jul 11 09:09:55 ubuntuvm1 su[5833]: Successful su for jenkins by root

Jul 11 09:09:55 ubuntuvm1 su[5833]: + ??? root:jenkins

Jul 11 09:09:55 ubuntuvm1 su[5833]: pam_unix(su:session): session opened for user jenkins by (uid=0)

Jul 11 09:09:55 ubuntuvm1 su[5833]: pam_unix(su:session): session closed for user jenkins

Jul 11 09:09:56 ubuntuvm1 jenkins[5787]: ...done.

Jul 11 09:09:56 ubuntuvm1 systemd[1]: Started LSB: Start Jenkins at boot time.

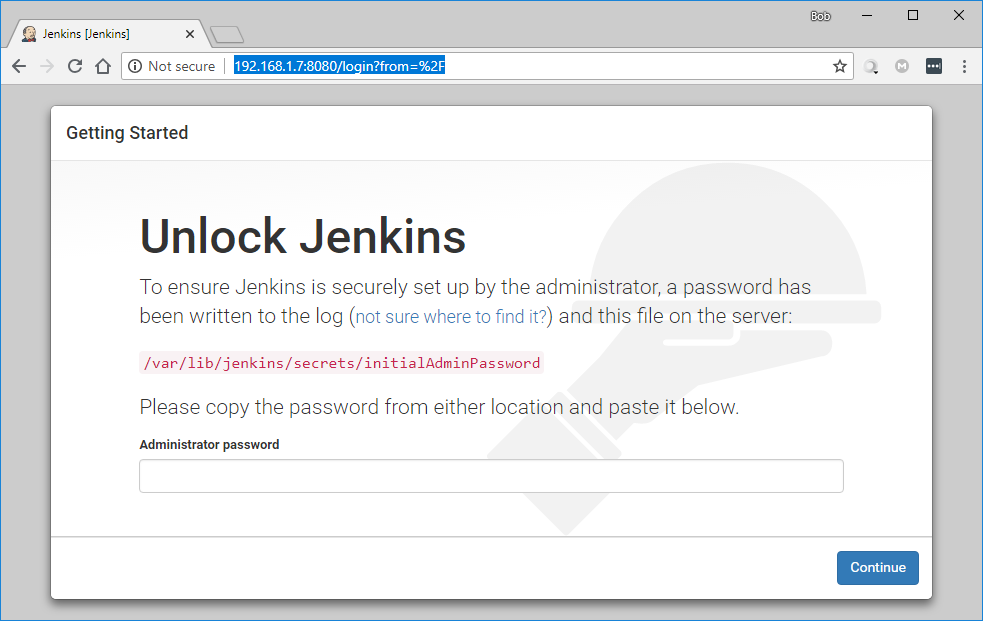

Jenkins 默认的侦听端口是8080,通过浏览器输入 ubuntuvm1 虚拟服务器地址和8080端口即可访问。首次访问需要解锁,请按屏幕提示操作。例如,从虚拟机里面查到密码是 “2bcb508f031743d5ada3fefb93e3167d”,将它填写在 “Administrator password” 输入框里,再按 “Continue” 按钮提交。

图2.5.1 Jenkins 安装后解锁

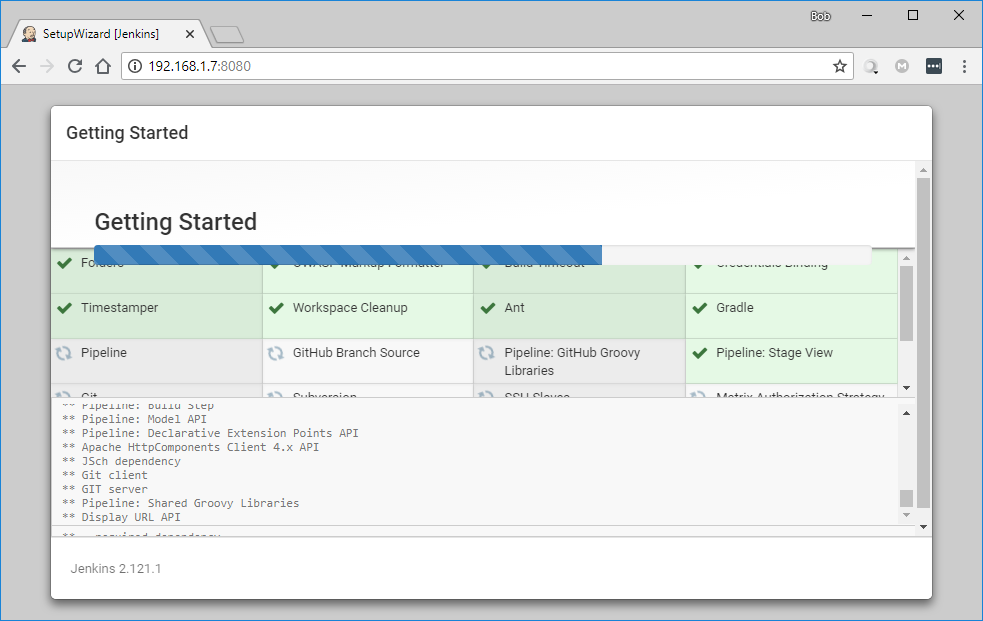

选择让 Jenkins 加载常用的插件。

图2.5.2 Jenkins 加载常用插件

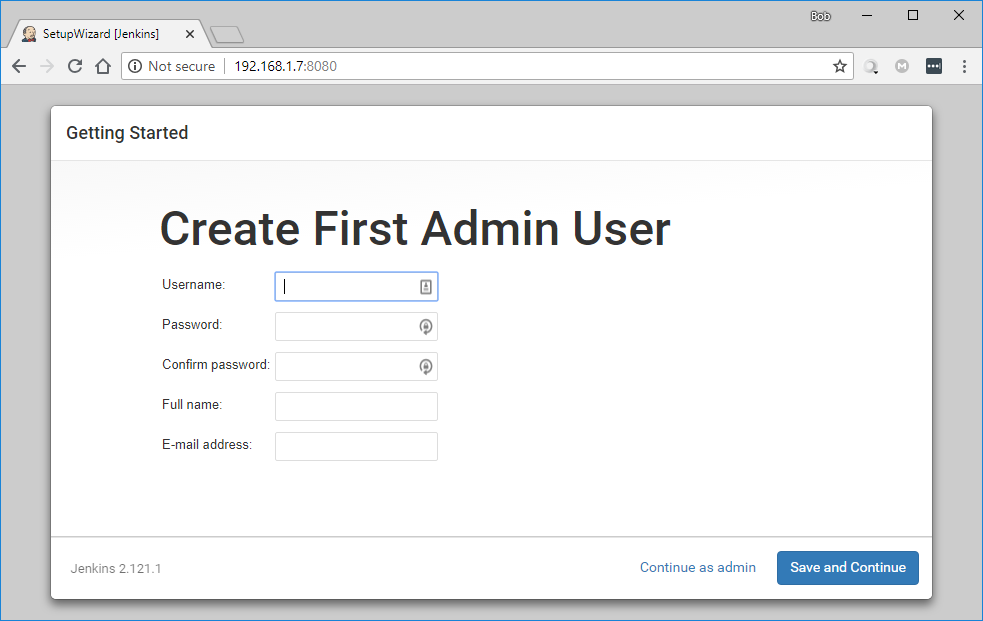

插件加载完成后,将可以设置管理员账号,请牢记用户名和密码。然后设置服务器的URL,这步对于目前安装在虚拟机上供实验实验的 Jenkins 实例不太重要,可以暂时跳过(在 Jenkins 设置页面中还有机会更改)。

图2.5.3 Jenkins 创建首个管理员用户

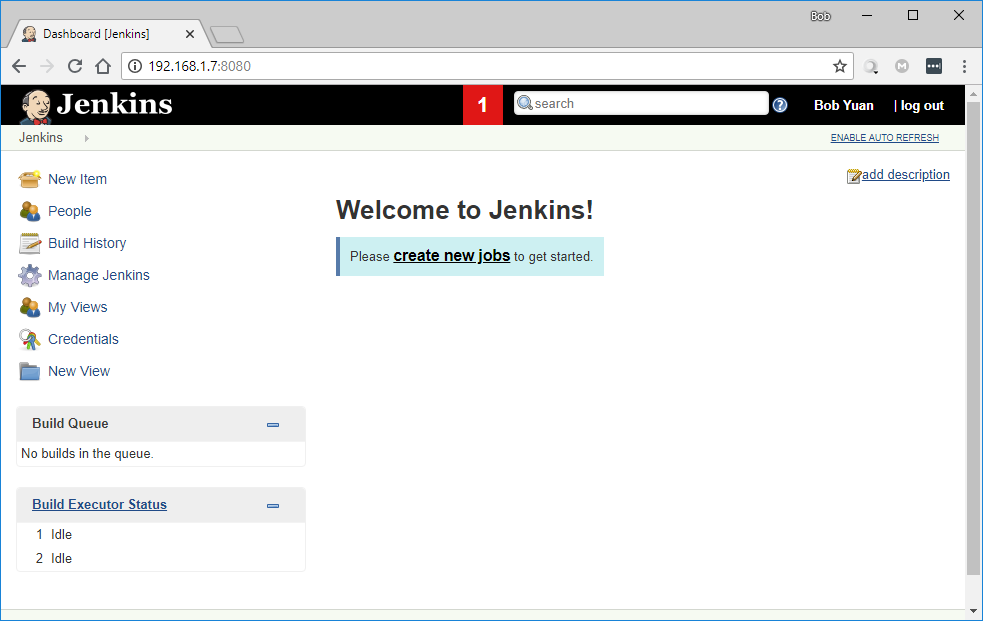

至此安装配置完毕,进入 Jenkins 的欢迎页面。

图2.5.4 Jenkins 欢迎页面

Jenkins 正确安装后:

- Jenkins 的配置文件是:

/etc/default/jenkins - Jenkins 的后台服务进程是:

/etc/init.d/jenkins - Jenkins 的后台日志是:

/var/log/jenkins/jenkins.log - 创建了 jenkins:jenkins 用户以启动 Jenkins 服务。

为了避免端口占用冲突,我们将 Jenkins 的侦听端口从默认的8080改为9090。修改配置文件 /etc/default/jenkins,再重启 Jenkins 服务,具体如下:

# stop Jenkins service.

sudo systemctl stop jenkins

# change from "HTTP_PORT=8080" to "HTTP_PORT=9090" in this file.

sudo vi /etc/default/jenkins

# restart Jenkins service.

sudo systemctl start jenkins

# check service status, should be active now.

sudo systemctl status jenkins

至此,Jenkins 已经修改到侦听于9090端口了。 接上例,若虚拟机 ubuntuvm1 的 IP 地址是192.168.1.7,我们可以通过 http://192.168.1.7:9090/ 来访问虚拟机 ubuntuvm1 上的 Jenkins 应用程序了。

注意本例中 Jenkins 是以服务的方式安装的,即虚拟机重启后,Jenkins 会自动以服务的方式启动。

Jenkins 的基本使用请参考官方文档(网址是 https://jenkins.io/doc/ (opens new window))。 另外,还有多本 Jenkins 的相关书籍,例如《Jenkins 权威指南》,《Mastering Jenkins》等。

# 2.6 安装 Apache Tomcat

Apache Tomcat(网址是 http://tomcat.apache.org/ (opens new window))是知名的 Java Web 应用程序服务器。本文中的 Web 应用程序将部署到 Tomcat 上运行,作为开发和测试环境,因而选择更灵活的手动安装模式。

Apache Tomcat 有多个发行版。在本文写作的时间,可以看见同时有 7、8、9 三个版本,本文将选择最新的 9 版本(下载链接 https://tomcat.apache.org/download-90.cgi),版本号是 9.0.21。

注意: 在您阅读本书的时候,最新的 Tomcat 版本很可能已经不是这个版本了,因此下载链接可能失效,应根据当时的版本号对应的下载链接,适当修改命令。

我们还可以参考以下的官方安装文档:

- Apache Tomcat 官方的安装文档 http://tomcat.apache.org/tomcat-9.0-doc/setup.html (opens new window)

- Ubuntu 官方的安装文档 https://help.ubuntu.com/lts/serverguide/tomcat.html (opens new window)

本机安装的 Tomcat 实例主要用于部署 Web 应用程序,作为测试环境。用当前用户 “bobyuan” 来安装和启动 Tomcat, 它的安装路径选择在 /usr/local。先把安装包下载到当前用户的 Home 路径中,按如下命令执行安装过程,将创建符号链接 /usr/local/apache-tomcat 指向真实的安装路径 ,例如这里是/usr/local/apache-tomcat-9.0.21。

# we will going to install tomcat here.

cd /usr/local

# unpack the tomcat release package.

sudo tar xzf ~/apache-tomcat-9.0.21.tar.gz

# change ownership to current user bobyuan

sudo chown -R bobyuan:bobyuan ./apache-tomcat-9.0.21

# create symbolic link pointing to the specific tomcat release.

sudo ln -s apache-tomcat-9.0.21 apache-tomcat

# remove the tomcat release package.

rm ~/apache-tomcat-9.0.21.tar.gz

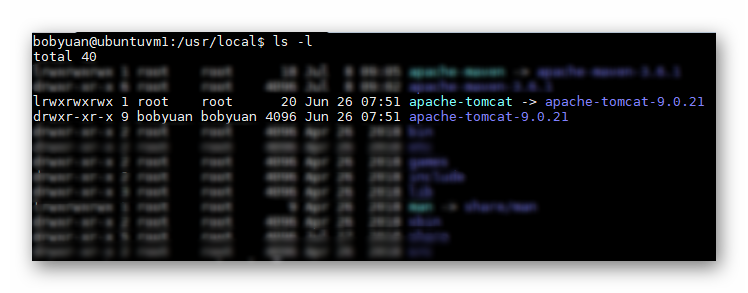

列文件清单,查看 Tomcat 的安装,应该如下图所示。须注意符号连接“apache-tomcat”指向真正的安装路径。

图2.6.1 列文件清单查看Tomcat的安装

修改当前用户 “bobyuan” 的 ~/.profile,在最后添加一行如下内容:

export CATALINA_HOME=/usr/local/apache-tomcat

退出当前用户并重新登录(这将载入更新后的 ~/.profile)。

用当前用户 “bobyuan” 启动和关闭 Tomcat 服务,命令如下:

# start Tomcat server.

$CATALINA_HOME/bin/startup.sh

# stop Tomcat server.

$CATALINA_HOME/bin/shutdown.sh

Tomcat 默认的侦听端口是 8080,启动后,我们可以看到8080端口正在侦听。命令如下:

bobyuan@ubuntuvm1:~$ netstat -an | grep 8080

tcp6 0 0 :::8080 :::* LISTEN

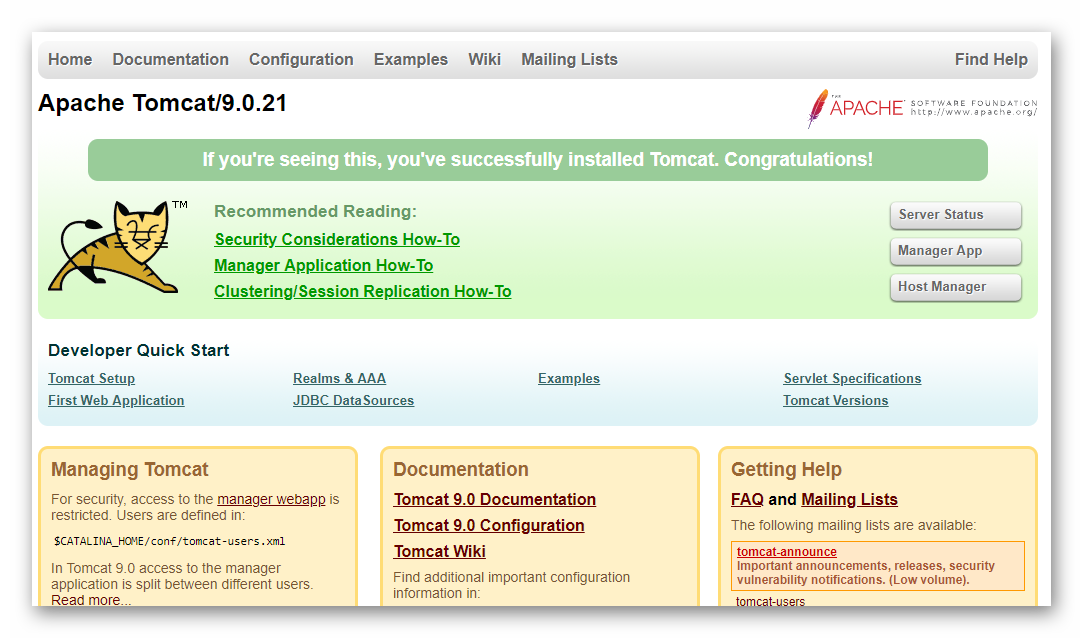

因此,若虚拟机的 IP 地址是 192.168.42.61,则可以用 http://192.168.42.61:8080 来访问 Tomcat,如果看到了 Tomcat 的欢迎页面(如下图),则表示安装和运行是正确的。

图2.6.2 Tomcat的欢迎页面

注意,以上 Tomcat 并非以系统服务的方式安装,因此,启动和关闭 Tomcat 都需要手动操作,执行启动和关闭命令。另外,虚拟机重启后也需要手动启动 Tomcat 服务。

至此,Tomcat 的安装已经完成。

以下是可选的步骤,“manager” 和 “host-manager” 是Tomcat自带的 Web 界面管理应用程序,在后续的实验中并未用到,我们也可以选择跳过。

为了使用 Tomcat 的 “manager” 和 “host-manager” 两个 Web 应用程序,需要继续按如下步骤设置。

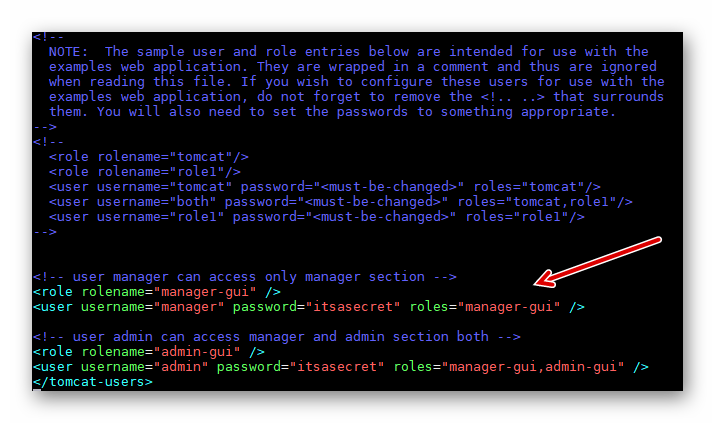

修改 Tomcat 的管理员登录账号。编辑配置文件 conf/tomcat-users.xml ,添加如下内容。注,下例中用 itsasecret 作为密码,它可以更改成其它的密码。

<!-- user manager can access only manager section -->

<role rolename="manager-gui" />

<user username="manager" password="itsasecret" roles="manager-gui" />

<!-- user admin can access manager and admin section both -->

<role rolename="admin-gui" />

<user username="admin" password="itsasecret" roles="manager-gui,admin-gui" />

如下图所示:

图2.6.3 Tomcat 的用户设置

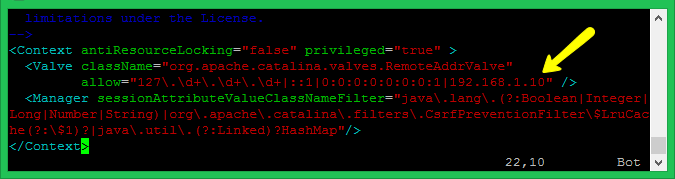

默认的情况下,出于安全考虑,Tomcat 的 “manager” 和 “host-manager” web 应用程序只能从本地(localhost)访问。如果要从其它机器远程访问,则需要修改配置文件,将远端机器的 IP 或 IP 地址段添加到配置文件中。配置文件如下:

- Manager File:

./webapps/manager/META-INF/context.xml - Host Manager File:

./webapps/host-manager/META-INF/context.xml

如下图所示,我们需要从 Windows Host 主机来访问虚拟机上的 “manager” 和 “host-manager” web 应用程序,经查 Windows Host 主机的 IP 地址是 192.168.1.10,则在配置文件里添加 “192.168.1.10” 为远程访问客户端:

图2.6.4 Tomcat 的远程管理访问设置

若虚拟机的 IP 地址是 192.168.42.61,我们于是可以在 Windows Host 主机上,通过浏览器用 http://192.168.42.61:8080/manager/ (用户名 / 密码: manager / itsasecret)来访问 “Tomcat Web Application Manager”,用 http://192.168.42.61:8080/host-manager/ (用户名 / 密码: admin / itsasecret)来访问 “Tomcat Virtual Host Manager”。

# 习题

- Oracle VirtualBox 安装文件,需要下载和安装的是哪两个?

- Ubuntu Server 虚拟机中,怎样放入光盘镜像?怎样弹出光盘?

- Ubuntu Server 虚拟机中,怎样放入“Guest Additions CD”镜像?怎样查看已经安装的“Guest Additions”版本?

- Ubuntu Server 虚拟机中,当修改网络配置后(例如更改了桥接网络),该运行什么命令让网络重启生效?

- Ubuntu Server 虚拟机中,怎样查看 IP 地址?重启、关机的命令是什么?

- 在2019年1月之后,为了免费在商业用途中使用 JDK,应该安装 OpenJDK 还是 Oracle JDK?

- 非长期支持版本的 JDK 的技术支持时间一般是多久?

- Apache Maven 把当前用户的配置文件和 jar 包保存在哪个文件夹里?

- Jenkins 的默认侦听端口是什么?怎样修改默认的侦听端口?

- Apache Tomcat 的默认侦听端口是什么?Tomcat 自带的 “manager” 和 “host-manager” 两个 Web 应用程序是用来做什么的?

- Apache Tomcat 的安装,为什么要设置

CATALINA_HOME而不是TOMCAT_HOME?

# 第3章 云应用示例

现实世界里,常见的典型企业通常可以分为以下两类:

业务导向型企业,IT 作为背后的技术支撑。例如某酒业有限公司,它的主业是白酒酿造和销售,公司内部部署了昂贵的 ERP (企业资源规划,Enterprise Resource Planning)系统,有复杂的 IT 系统为整个公司的业务活动提供支持。

这类企业的主业是其核心竞争力所在,是企业的收入来源。而 IT 部门不直接创造利润,是企业的“成本中心” 。无论自己的 IT 部门有多大,首席执行官(Chief Executive Officer,CEO)对它的关注度总是不会太高,它大概占整个企业营业成本的 1~2%,甚至更少。随着信息化在全国许多企业的全面推进,IT 部门在企业中的作用愈加重要。但是,CEO 仍觉得 IT 部门是只花钱不赚钱的部门,不是核心业务部分。CEO 更多关心,更多投入的是能带来直接盈利的市场营销和财务部门。

IT 产品或服务的供应商。如微软,它提供套装软件如 Office,也提供平台基础设施如 Azure 云服务,还提供专业的 IT 服务外包。这类企业的主业就是为市场提供 IT 产品或服务,当然,它也会有仅服务于内部的 IT 部门,但因对外的 IT 产品和服务是企业的收入来源,技术相关的岗位受重视程度会相对较高,在研发方面的投入比例也较高。

复合型的企业也常见,例如亚马逊最早是传统纸质书的电子商务平台,后来发展出 AWS 云服务。

如果是第一类的企业,很可能作为合同甲方将 IT 服务外包;而第二类企业,通常作为合同乙方承接这些外包项目。我们的例子将以第二类企业为视角,假想有一个业务需求,要开发一个 Web 应用程序为外界提供服务。

获利是企业的主要目标,或许不能称之为唯一目标,但肯定是其多个目标里非常重要的一个部分。不能获利的企业将无法存续,而获利丰厚的企业也一定程度上意味着它的经营活动能够给社会带来更多价值。

企业参与市场竞争,为了获取最大利益,最关切的因素可以简单归纳如下:

- 多。多是指有丰富的产品线,品牌和档次,尽最大可能提高产量满足市场需求。

- 快。快是指效率高,它在不同行业有着不同的定义。例如在制造业,快是指比竞争对手更快地开发或生产出满足市场需求的新产品,或是快速响应市场需求的变化调整产品线。在电子商务网站上,快被定义为将商品快速递送到客户手中。在项目外包的服务业,快被定义为快速实施和交付项目。

- 好。努力提高产品或服务质量,赢得客户的满意与口碑,形成更高的技术壁垒,突出自己在市场中的竞争优势。

- 省。尽最大可能降低总体运营和生产成本。例如依据企业战略决策综合权衡投入产出比或总拥有成本,选择哪些工作必须自主研发或外包,哪些物资购买或租用等。

在这些目标里面,采用新技术都是非常重要的。虽然新技术也意味着不确定性和风险,但它同时伴随着高收益。科技型企业,尤其是初创企业,为了和现存的大企业竞争,会更热衷于采用新技术以提高竞争优势。

新兴的云计算平台就是新技术的一种。对于大多数企业而言,采用云平台来部署 Web 应用程序的优势是显而易见的,从云计算平台近些年来的蓬勃发展就可见一斑。事实上,传统自建机房的部署方式依然有存在的根基,比如出于数据安全方面考虑,银行和政府等对数据安全高度敏感的组织,是不可能将数据存放在外部环境的。再有,在某些特定场景下,若规模和使用时间长度恰当的话,也有可能总使用成本会低于租用云平台的使用费。未来可以预见,传统自建机房的部署方式会逐渐减少,但不会消亡,它和云平台部署两种方式终将达到一个市场占比的均衡并长期并存。

大多数情况下,将 Web 应用程序部署在云平台,与自建机房的传统方式相比更灵活、快捷,也更经济。本书的例子 Web 应用程序的部署方式也毫无疑问的将采用租用云平台的方式来部署。

# 3.1 简单的 Web 应用程序

在企业里,通常业务需求是先导,综合考虑技术、人员等其它因素来确定系统架构。例如选择 Java 这种业界主流的 Web 应用程序开发技术的好处是:

- 技术成熟。有众多大企业商务关键性应用案例,安全稳定性有口碑,碰到技术上无法实现的可能性极小。

- 生态链成熟。有众多的第三方包和开发调试工具可以使用;有大量的文档和书籍可供学习参考;碰到了技术问题很容易通过网络搜索到公开的解决方案,或是可以相对容易在社区和论坛上获得帮助。

- 生命力长。因为有大量商业应用采用此项技术,使得这项技术在未来很长一段时间不会被淘汰,技术上能够持续积累竞争优势,在此技术上的投资将获得相对久远的回报。

- 人才市场上更容易找到开发人员,选择面宽,开发和维护的成本较低。

软件开发没有银弹,没有“最好”的应用程序开发语言或框架,只有适合应用场景的才是最好的。在比较复杂的企业级商业应用场景下,还会综合使用多种程序开发语言,综合多个工具和技术的优势特性来构建整个应用服务。

技术选型通常是由项目经理和经验丰富的高级技术人员(如架构师)来确定,通常会采用快速原型法,制作一个或多个仅具备基本功能的原型(Prototype),证明技术可行性,比选后再最终确定技术路线。

本文假定技术路线已经确定,将采用 Java 作为这个示例 Web 应用程序的开发语言,采用 Spring MVC 作为 Web 应用程序的框架。

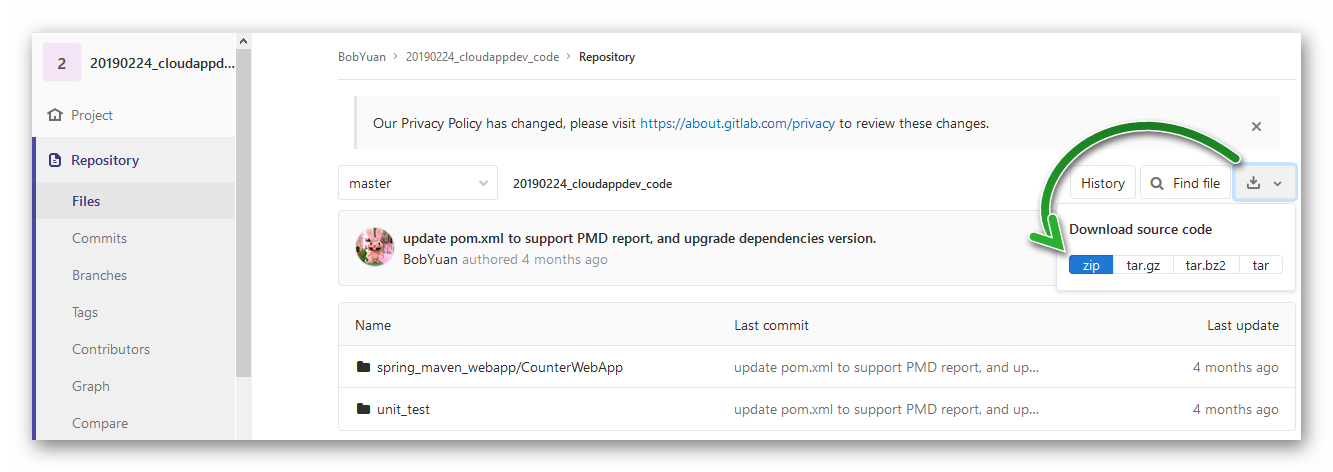

示例 Web 应用程序 CounterWebApp 是一个非常简单的 Browser / Server 架构应用程序,它用来贯穿本书涉及的知识点。它是一个网页版的计数器,没有复杂的业务逻辑。为了方便下载,整个 CounterWebApp 应用程序的代码已经托管在 GitLab 上,其地址是:

https://gitlab.com/bobyuan/20190224_cloudappdev_code (opens new window)

它是公开的项目,我们可以通过网页把它下载到本地,便于稍后与自己创建的项目文件相对比。

图3.1.1 下载 CounterWebApp 的源程序压缩包

以下将简述在 Windows 上从零开始创建 CounterWebApp 项目,用于开发和调试的过程。这也符合通常的现实情况,即在 Windows 桌面环境下开发软件,完成后,将应用程序打包,部署到 Linux 服务器上运行——也就是之前安装配置好的 Ubuntu Server 虚拟机上。

下面假定我们的 Windows 电脑已经安装了 Maven、Eclipse (请注意选择:Eclipse IDE for Enterprise Java Developers)和 Apache Tomcat 9 (下载二进制发行包“zip”即可),这些工具在 Windows 上的安装都非常简单,我们可以参考官方的安装文档,此处从略。

首先用 Maven 创建 Web 应用程序的文件结构。在命令行窗口输入下面的命令。请注意,以下命令是一行,且开头为“#”的是注释,可以忽略。

# create the CounterWebApp web application.

mvn archetype:generate -DgroupId=com.example -DartifactId=CounterWebApp -DarchetypeArtifactId=maven-archetype-webapp -DinteractiveMode=false

添加 “.gitignore” 文本文件,它的作用是让 Git 忽略掉不需要加入版本控制的文件和文件夹。此文本文件的内容是:

# ignore specific folder.

/.settings/

/target/

# ignore specific file.

# ignore any file.

*.class

*.log

*.bak

至此,CounterWebApp 项目的文件夹结构将如下图所示。

CounterWebApp

│

│ .gitignore

│ pom.xml

│

└─src

└─main

├─resources

└─webapp

│ index.jsp

└─WEB-INF

web.xml

修改 “pom.xml” 文件,将其内容替换如下:

<?xml version="1.0" encoding="UTF-8"?>

<project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/maven-v4_0_0.xsd">

<modelVersion>4.0.0</modelVersion>

<groupId>com.example</groupId>

<artifactId>CounterWebApp</artifactId>

<packaging>war</packaging>

<version>1.0-SNAPSHOT</version>

<name>CounterWebApp Maven Webapp</name>

<url>http://maven.apache.org</url>

<properties>

<!-- Set default encoding -->

<project.build.sourceEncoding>UTF-8</project.build.sourceEncoding>

<project.reporting.outputEncoding>UTF-8</project.reporting.outputEncoding>

<!-- Set compiler version -->

<maven.compiler.target>1.8</maven.compiler.target>

<maven.compiler.source>1.8</maven.compiler.source>

<spring.version>5.1.6.RELEASE</spring.version>

<jstl.version>1.2</jstl.version>

<junit.version>4.12</junit.version>

<logback.version>1.0.13</logback.version>

<jcl-over-slf4j.version>1.7.5</jcl-over-slf4j.version>

</properties>

<dependencies>

<!-- Unit Test -->

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>${junit.version}</version>

<scope>test</scope>

</dependency>

<!-- Spring Core -->

<dependency>

<groupId>org.springframework</groupId>

<artifactId>spring-core</artifactId>

<version>${spring.version}</version>

<exclusions>

<exclusion>

<groupId>commons-logging</groupId>

<artifactId>commons-logging</artifactId>

</exclusion>

</exclusions>

</dependency>

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>jcl-over-slf4j</artifactId>

<version>${jcl-over-slf4j.version}</version>

</dependency>

<dependency>

<groupId>ch.qos.logback</groupId>

<artifactId>logback-classic</artifactId>

<version>${logback.version}</version>

</dependency>

<dependency>

<groupId>org.springframework</groupId>

<artifactId>spring-web</artifactId>

<version>${spring.version}</version>

</dependency>

<dependency>

<groupId>org.springframework</groupId>

<artifactId>spring-webmvc</artifactId>

<version>${spring.version}</version>

</dependency>

<!-- jstl -->

<dependency>

<groupId>jstl</groupId>

<artifactId>jstl</artifactId>

<version>${jstl.version}</version>

</dependency>

</dependencies>

<build>

<finalName>CounterWebApp</finalName>

<plugins>

<!-- Apache Maven Eclipse Plugin (RETIRED)

The Maven Eclipse Plugin is used to generate Eclipse IDE files (*.classpath, *.project,

*.wtpmodules and the .settings folder) for use with a project.

Disclaimer: Users are advised to use m2e

https://repo.maven.apache.org/maven2/org/apache/maven/plugins/maven-eclipse-plugin/

-->

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-eclipse-plugin</artifactId>

<version>2.9</version>

<configuration>

<!-- Always download and attach dependencies source code -->

<downloadSources>true</downloadSources>

<downloadJavadocs>false</downloadJavadocs>

<!-- Avoid type mvn eclipse:eclipse -Dwtpversion=2.0 -->

<wtpversion>2.0</wtpversion>

</configuration>

</plugin>

<!-- Apache Maven Resources Plugin

The Resources Plugin handles the copying of project resources to the output directory.

There are two different kinds of resources: main resources and test resources.

The difference is that the main resources are the resources associated to the main

source code while the test resources are associated to the test source code.

https://repo.maven.apache.org/maven2/org/apache/maven/plugins/maven-resources-plugin/

-->

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-resources-plugin</artifactId>

<version>3.1.0</version>

<executions>

<execution>

<phase>test</phase>

<goals>

<goal>resources</goal>

<goal>testResources</goal>

</goals>

</execution>

</executions>

</plugin>

<!-- Apache Maven Site Plugin

The Site Plugin is used to generate a site for the project. The generated site also

includes the project's reports that were configured in the POM.

https://repo.maven.apache.org/maven2/org/apache/maven/plugins/maven-site-plugin/

-->

<!-- Note.

To fix "mvn site" error "NoClassDefFoundError: org/apache/maven/doxia/siterenderer/DocumentContent" problem.

-->

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-site-plugin</artifactId>

<version>3.7.1</version>

</plugin>

<!-- Tomcat Maven Plugin

It provides goals to manipulate WAR projects within the Tomcat servlet container version 7.x

https://repo.maven.apache.org/maven2/org/apache/tomcat/maven/tomcat7-maven-plugin/

-->

<plugin>

<groupId>org.apache.tomcat.maven</groupId>

<artifactId>tomcat7-maven-plugin</artifactId>

<version>2.2</version>

<configuration>

<server>TomcatServer</server>

<path>/CounterWebApp</path>

</configuration>

</plugin>

</plugins>

</build>

<reporting>

<plugins>

<!-- Apache Maven Project Info Reports Plugin

The Maven Project Info Reports plugin is used to generate reports information about the project.

Normally, we take off the dependency report to save time.

https://repo.maven.apache.org/maven2/org/apache/maven/plugins/maven-project-info-reports-plugin/

-->

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-project-info-reports-plugin</artifactId>

<version>3.0.0</version>

<configuration>

<dependencyLocationsEnabled>false</dependencyLocationsEnabled>

</configuration>

</plugin>

<!-- Apache Maven Javadoc Plugin.

The Javadoc Plugin uses the Javadoc tool to generate javadocs for the specified project.

https://repo.maven.apache.org/maven2/org/apache/maven/plugins/maven-javadoc-plugin/

-->

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-javadoc-plugin</artifactId>

<version>3.1.0</version>

</plugin>

<!-- Maven JXR Plugin.

The JXR Plugin produces a cross-reference of the project's sources.

https://repo.maven.apache.org/maven2/org/apache/maven/plugins/maven-jxr-plugin/

-->

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-jxr-plugin</artifactId>

<version>3.0.0</version>

</plugin>

<!-- Apache Maven PMD Plugin.

The PMD Plugin allows you to automatically run the PMD code analysis tool on your project's

source code and generate a site report with its results.

It also supports the separate Copy/Paste Detector tool (or CPD) distributed with PMD.

https://repo.maven.apache.org/maven2/org/apache/maven/plugins/maven-pmd-plugin/

-->

<plugin>

<groupId>org.apache.maven.plugins</groupId>

<artifactId>maven-pmd-plugin</artifactId>

<version>3.12.0</version>

<configuration>

<skipEmptyReport>false</skipEmptyReport>

</configuration>

</plugin>

</plugins>

</reporting>

</project>

按下面的文件夹结构,创建文件夹,并添加源文件:

CounterWebApp

│

│ .gitignore

│ pom.xml

│

└─src

├─main

│ ├─java

│ │ └─com

│ │ └─example

│ │ ├─controller

│ │ │ BaseController.java

│ │ │

│ │ └─model

│ │ SimpleCounter.java

│ │

│ ├─resources

│ │ logback.xml

│ │

│ └─webapp

│ └─WEB-INF

│ │ mvc-dispatcher-servlet.xml

│ │ web.xml

│ │

│ └─pages

│ index.jsp

│

└─test

└─java

└─com

└─example

└─model

SimpleCounterTest.java

其中,“com.example.controller.BaseController.java” 的内容如下:

package com.example.controller;

import org.slf4j.LoggerFactory;

import org.springframework.stereotype.Controller;

import org.springframework.ui.ModelMap;

import org.springframework.web.bind.annotation.PathVariable;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RequestMethod;

import com.example.model.SimpleCounter;

@Controller

public class BaseController {

private static SimpleCounter sc = new SimpleCounter();

private static final String VIEW_INDEX = "index";

private final static org.slf4j.Logger logger = LoggerFactory.getLogger(BaseController.class);

private static synchronized long getNextCounterValue() {

sc.increase();

return sc.getValue();

}

@RequestMapping(value = "/", method = RequestMethod.GET)

public String welcome(ModelMap model) {

long counterValue = BaseController.getNextCounterValue();

model.addAttribute("message", "Welcome");

model.addAttribute("counter", counterValue);

logger.debug("[welcome] counter : {}", counterValue);

// Spring uses InternalResourceViewResolver and return back index.jsp

return VIEW_INDEX;

}

@RequestMapping(value = "/{name}", method = RequestMethod.GET)

public String welcomeName(@PathVariable String name, ModelMap model) {

long counterValue = BaseController.getNextCounterValue();

model.addAttribute("message", "Welcome " + name);

model.addAttribute("counter", counterValue);

logger.debug("[welcomeName] counter : {}", counterValue);

// Spring uses InternalResourceViewResolver and return back index.jsp

return VIEW_INDEX;

}

}

数据模型中,“com.example.model.SimpleCounter.java” 的内容如下:

package com.example.model;

public class SimpleCounter {

private long counter = 0;

public SimpleCounter() {

this.counter = 0;

}

public SimpleCounter(long initValue) {

this.counter = initValue;

}

public void increase() {

this.counter = this.counter + 1;

}

public long getValue() {

return this.counter;

}

}

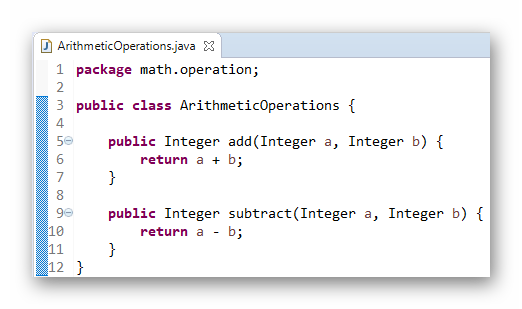

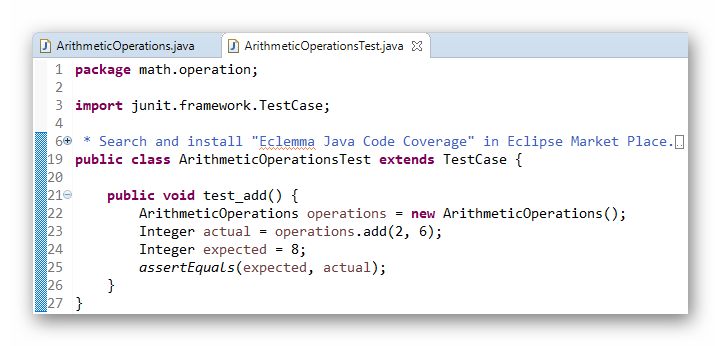

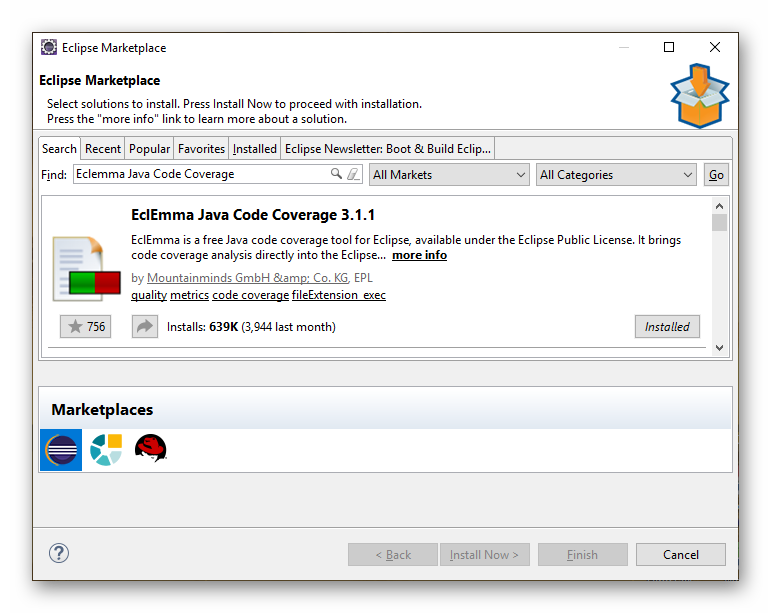

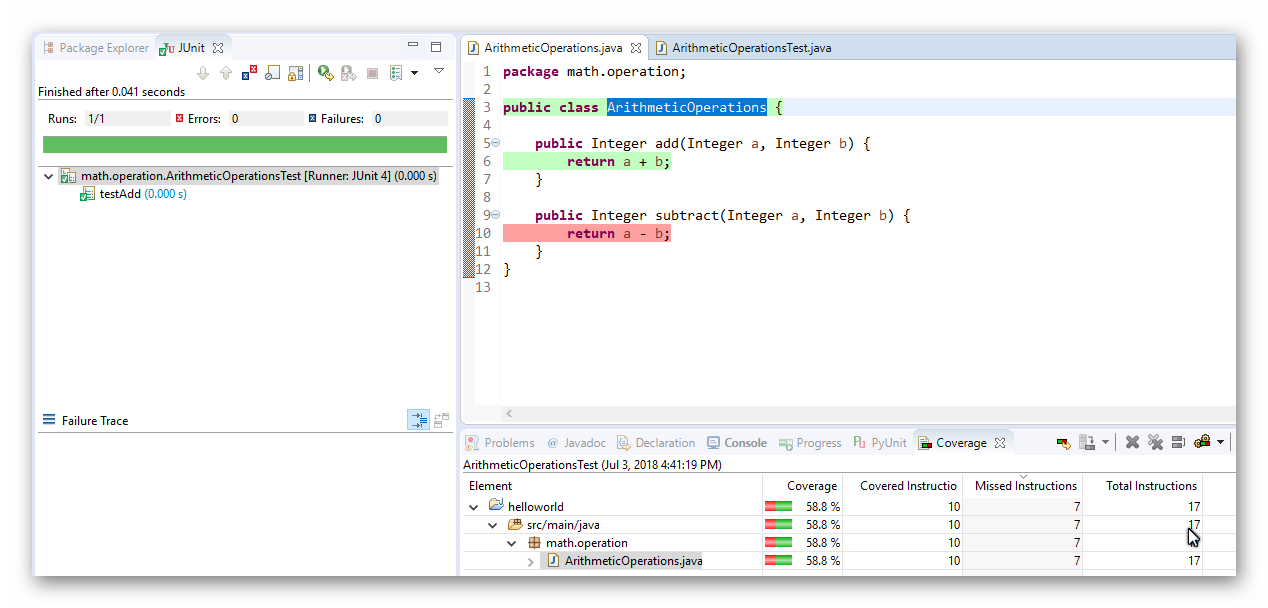

它对应的单元测试 “com.example.model.SimpleCounterTest.java” 的内容是:

package com.example.model;

import static org.junit.Assert.assertEquals;

import org.junit.Test;

public class SimpleCounterTest {

@Test

public void test_basic_usage() {

SimpleCounter sc = new SimpleCounter();

assertEquals(0, sc.getValue());

sc.increase();

assertEquals(1, sc.getValue());

sc.increase();

assertEquals(2, sc.getValue());

sc.increase();

assertEquals(3, sc.getValue());

}

@Test

public void test_extended_usage() {

SimpleCounter sc = new SimpleCounter(5);

assertEquals(5, sc.getValue());

sc.increase();

assertEquals(6, sc.getValue());

sc.increase();

assertEquals(7, sc.getValue());

sc.increase();

assertEquals(8, sc.getValue());

}

}

资源文件 “logback.xml” 的内容是:

<?xml version="1.0" encoding="UTF-8"?>

<configuration>

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<layout class="ch.qos.logback.classic.PatternLayout">

<Pattern>

%d{yyyy-MM-dd HH:mm:ss} [%thread] %-5level %logger{36} - %msg%n

</Pattern>

</layout>

</appender>

<logger name="com.example.controller" level="debug" additivity="false">

<appender-ref ref="STDOUT" />

</logger>

<root level="error">

<appender-ref ref="STDOUT" />

</root>

</configuration>

Spring MVC 的配置文件 “mvc-dispatcher-servlet.xml” 的内容是:

<beans xmlns="http://www.springframework.org/schema/beans"

xmlns:context="http://www.springframework.org/schema/context"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="

http://www.springframework.org/schema/beans

http://www.springframework.org/schema/beans/spring-beans.xsd

http://www.springframework.org/schema/context

http://www.springframework.org/schema/context/spring-context.xsd">

<context:component-scan base-package="com.example.controller" />

<bean

class="org.springframework.web.servlet.view.InternalResourceViewResolver">

<property name="prefix">

<value>/WEB-INF/pages/</value>

</property>

<property name="suffix">

<value>.jsp</value>

</property>

</bean>

</beans>

Web 应用程序的配置文件 “web.xml” 的内容是:

<web-app xmlns="http://java.sun.com/xml/ns/javaee"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://java.sun.com/xml/ns/javaee

http://java.sun.com/xml/ns/javaee/web-app_2_5.xsd"

version="2.5">

<display-name>Counter Web Application</display-name>

<servlet>

<servlet-name>mvc-dispatcher</servlet-name>

<servlet-class>org.springframework.web.servlet.DispatcherServlet</servlet-class>

<load-on-startup>1</load-on-startup>

</servlet>

<servlet-mapping>

<servlet-name>mvc-dispatcher</servlet-name>

<url-pattern>/</url-pattern>

</servlet-mapping>

<context-param>

<param-name>contextConfigLocation</param-name>

<param-value>/WEB-INF/mvc-dispatcher-servlet.xml</param-value>

</context-param>

<listener>

<listener-class>org.springframework.web.context.ContextLoaderListener</listener-class>

</listener>

</web-app>

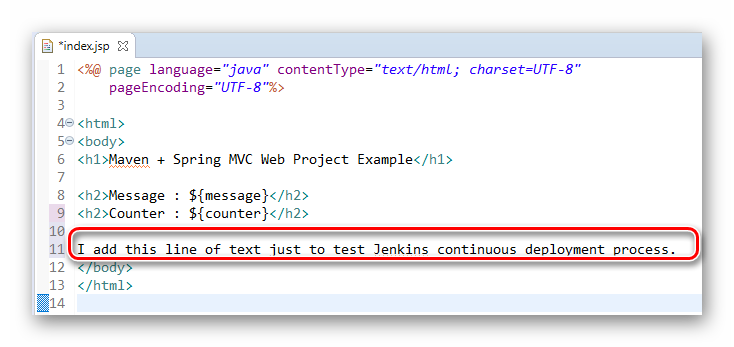

唯一的页面 “index.jsp”(注意它位于“WEB-INF/pages”文件夹下) 的内容如下:

<%@ page language="java" contentType="text/html; charset=UTF-8" pageEncoding="UTF-8"%>

<html>

<body>

<h1>Maven + Spring MVC Web Project Example</h1>

<h2>Message : ${message}</h2>

<h2>Counter : ${counter}</h2>

</body>

</html>

打开命令行窗口中,切换当前路径到 “CounterWebApp” 的文件夹下,用 Maven 生成 Eclipse 的项目文件(“.classpath” 和 “.project”)。执行此命令:

# generate Eclipse web project files.

mvn eclipse:eclipse -Dwtpversion=2.0

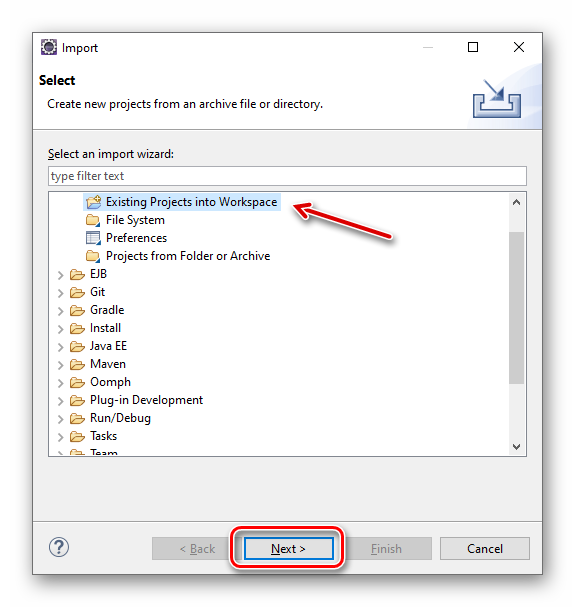

打开 Eclipse 集成开发环境,点选菜单“File | Import... ”导入这个项目。

图3.1.2 Eclipse 导入 CounterWebApp 项目之第1步

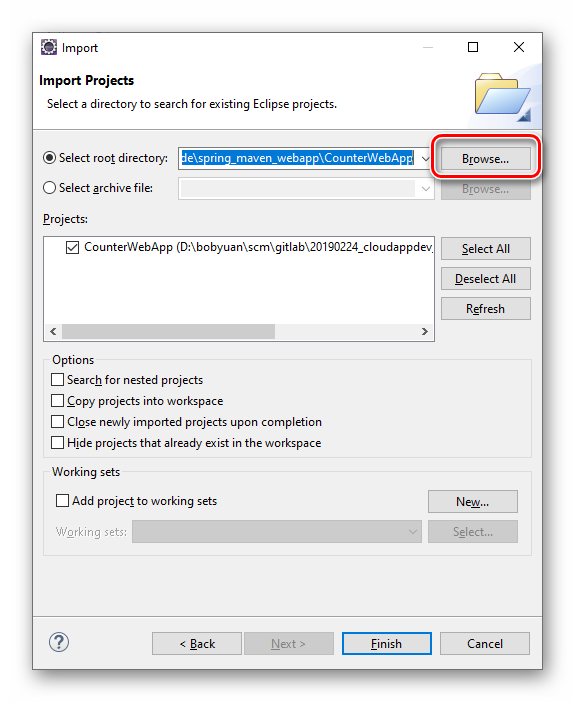

图3.1.3 Eclipse 导入 CounterWebApp 项目之第2步

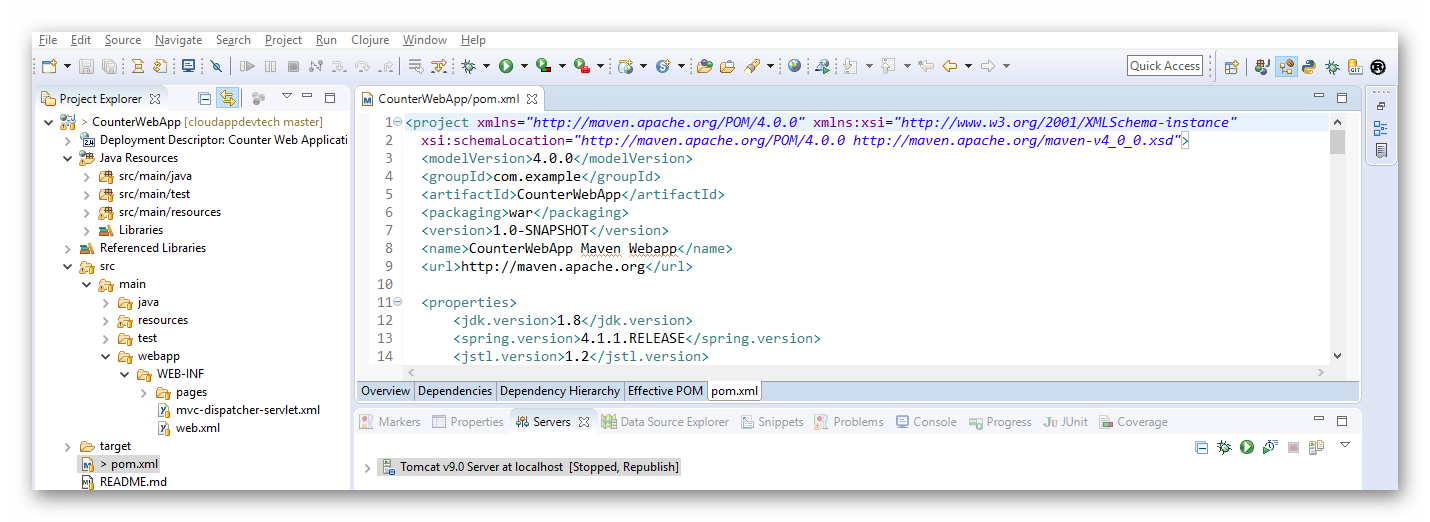

导入后,项目在 Eclipse 里将如下所示。

图3.1.4 Eclipse 导入 CounterWebApp 项目之完成

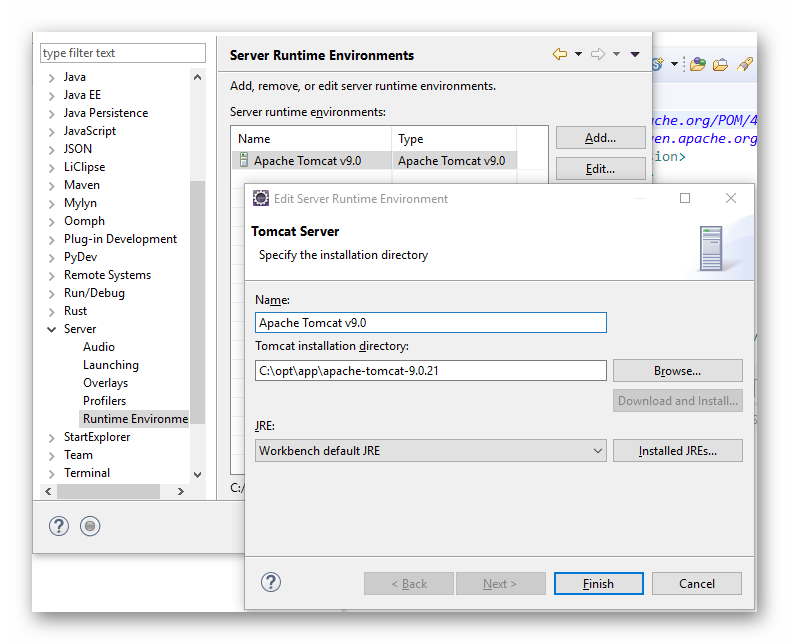

假定本机的开发环境安装了 Apache Tomcat 9.0。添加 Tomcat Server 环境如下:

图3.1.5 Eclipse 设置 Tomcat Server 运行环境

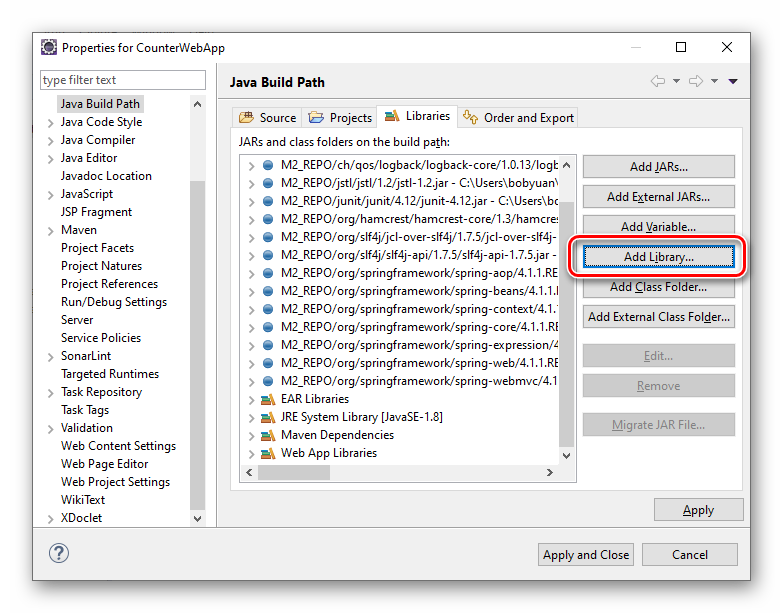

按 “Add Library...” 按钮,添加 Web 应用程序服务器的 API:

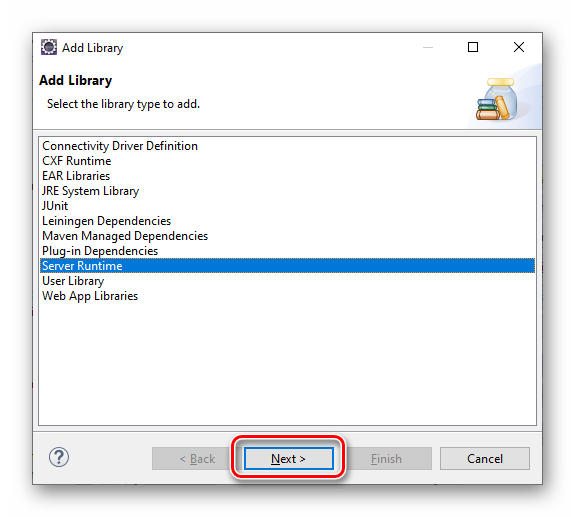

图3.1.6 Eclipse 设置 Tomcat Server 运行环境之添加库第1步

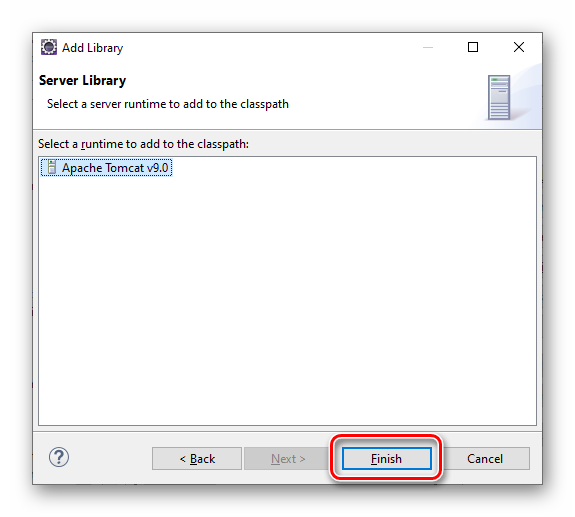

图3.1.7 Eclipse 设置 Tomcat Server 运行环境之添加库第2步

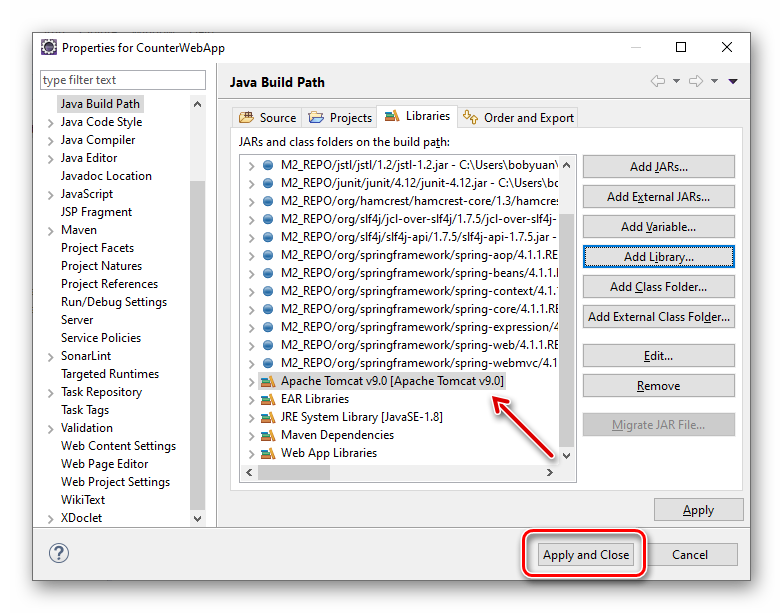

图3.1.8 Eclipse 设置 Tomcat Server 运行环境之添加库第3步

按“Finish”按钮完成。注意下面的“Apache Tomcat v9.0 [Apache Tomcat v9.0”,是刚才新添加的:

图3.1.9 Eclipse 设置 Tomcat Server 运行环境之完成

在 Eclipse 里检查一下,整个项目应该没有任何的错误标记。

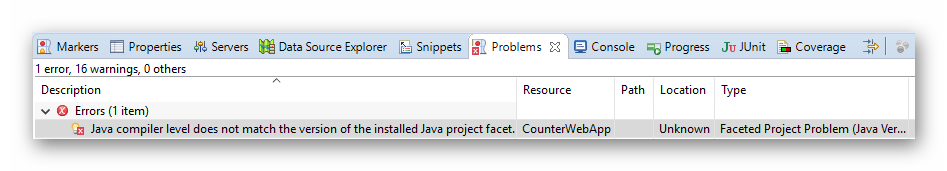

如果我们在“Problems”视图窗口中看到这样的错误:

图3.1.10 Eclipse 错误视图窗口

注,如果您找不到“Problems”视图窗口,可以通过菜单“Window | Show View | Problems”打开它。

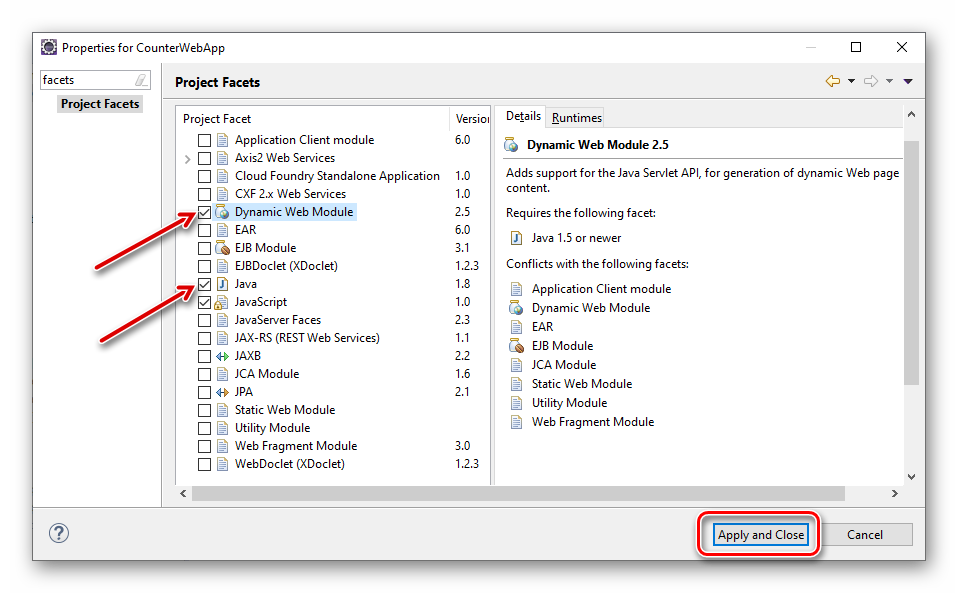

根据错误提示,我们可以在项目设置里面,搜索“facets”,做如下设置。

图3.1.11 Eclipse 设置 Project Facets

至此,整个 CounterWebApp 应用程序项目的代码已经建立完毕。

# 3.2 运行 Web 应用程序

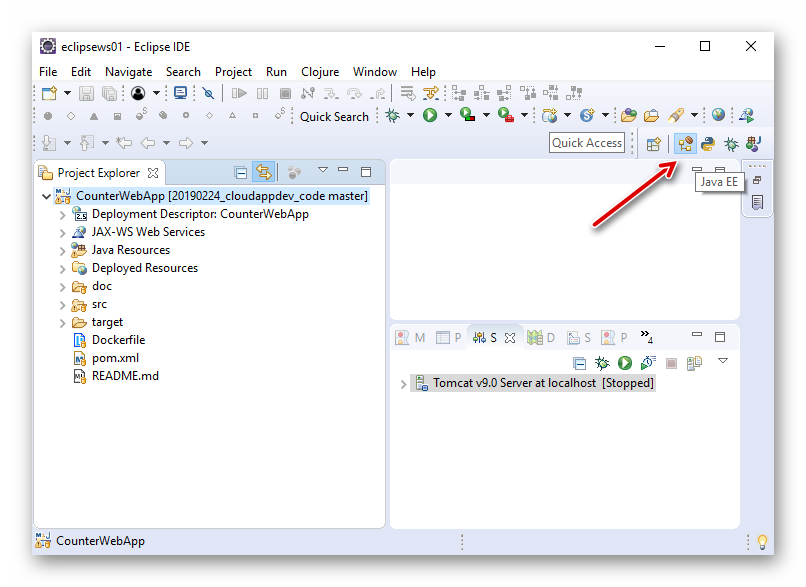

在 Eclipse IDE 里,我们可以让这个 Web 应用程序在本地 Tomcat 应用服务器上运行,主要目的是用于代码开发过程中的调试。

配置好 Tomcat Server 后,切换到“Java EE”的视图,选中 CounterWebApp 项目,选择菜单 “Run | Run As | Run on Server”。

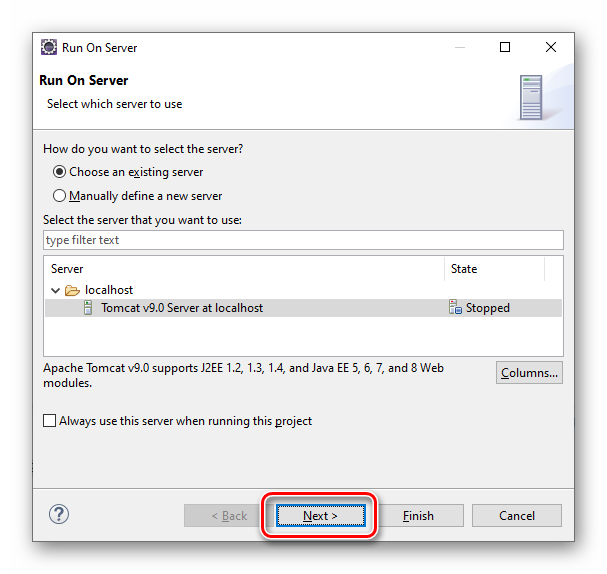

图3.2.1 Eclipse 运行 CounterWebApp 第1步

图3.2.2 Eclipse 运行 CounterWebApp 第2步

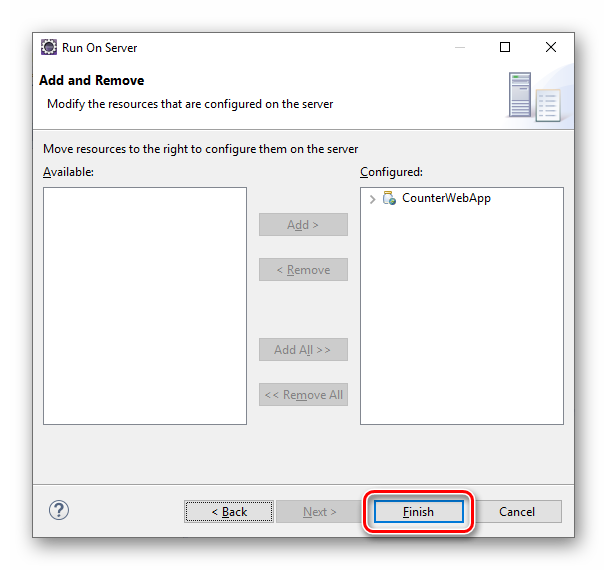

图3.2.3 Eclipse 运行 CounterWebApp 第3步

按“Finish”按钮,即可以将此 CounterWebApp 发布到 Tomcat Server 中运行。

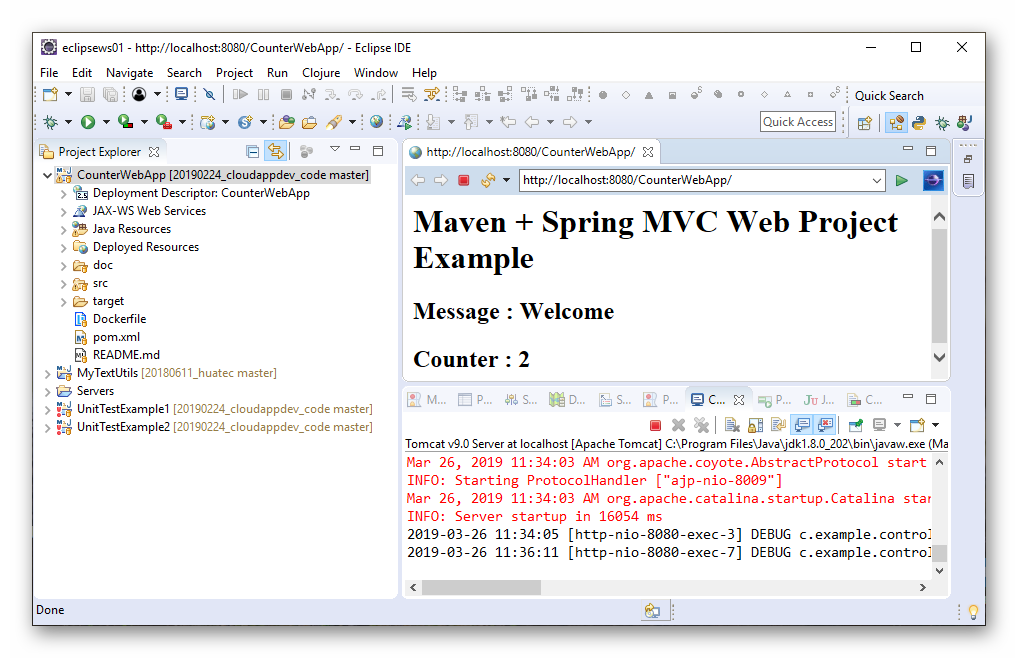

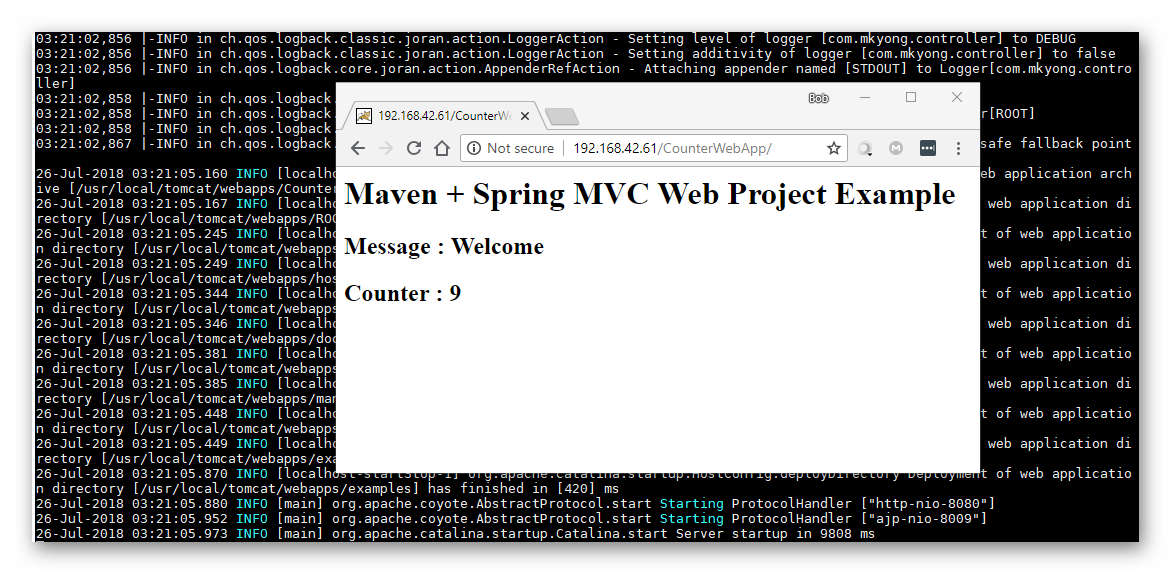

下图中我们可以看到,它已经正常运行。每次刷新这个页面,可以看到计数器会增加1。

图3.2.4 Eclipse 运行 CounterWebApp 结果

如果选择菜单 “Run | Debug As | Debug on Server”,则可以在调试模式下将此 CounterWebApp 发布到 Tomcat Server 中运行。适用于开发过程中的代码调试。

回到命令行窗口,我们来试试用 Maven 来打包和启动此 Web 应用程序。

我们先用 Maven 来生成发行包,将会在 “target” 文件夹中生成 “CounterWebApp.war” 文件:

mvn package

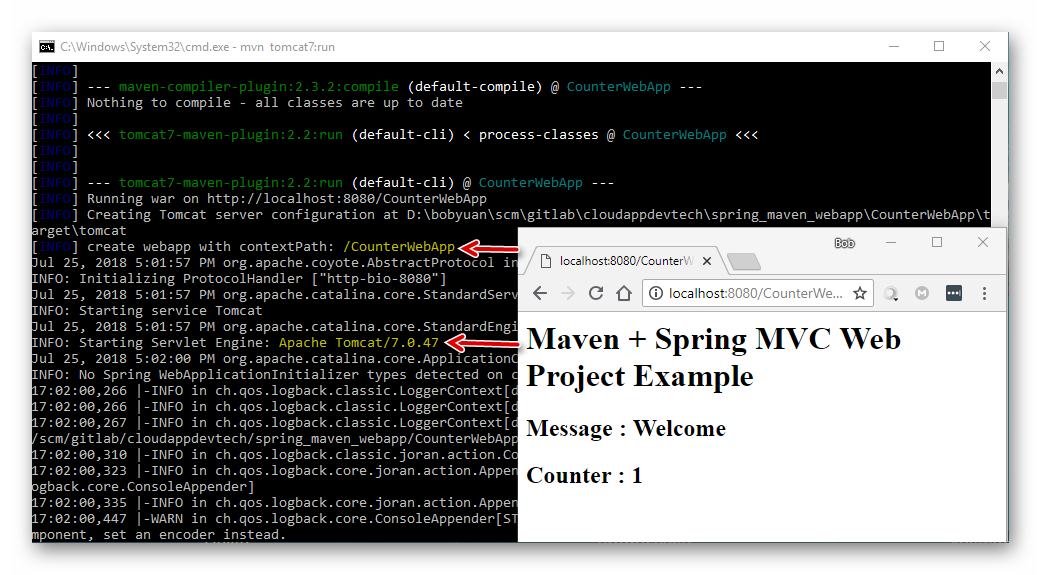

再直接用 Maven 来运行这个 Web 应用程序,用于测试 CounterWebApp 是否可以正常工作。只是这次 Maven 将自动选择用 “Apache Tomcat 7.0.47” 来作为应用服务器:

mvn tomcat7:run

图3.2.5 通过 Maven 运行 CounterWebApp

从上图示例中,我们可以看到 CounterWebApp 运行正常。

# 习题

- 简单列举选择主流的开发技术的好处。

- “pom.xml” 文件的用途是什么?该怎样使用它?

- “.gitignore” 文本文件的用途是什么?它应该放在哪儿?

- Windows 中怎样关闭资源浏览器的“隐藏已知文件类型的扩展名”选项?

- Windows 中怎样创建或保存这种没有文件名只有扩展名的文件(例如“.gitignore”)?

- “web.xml” 文件的用途是什么?它应该放在哪儿?

# 第4章 分布式版本控制系统 Git

分布式版本控制系统(Distributed Version Control System, DVCS)是一种不需要中心服务器来管理文件版本的方法,但是它也可以使用中心服务器。也即,中心服务器是可选的。

知名的分布式版本控制系统有:

- Git (https://git-scm.com (opens new window)) Git(读音为/gɪt/)是 Linus Torvalds 为了帮助管理 Linux 内核开发而编写的一个开放源码的版本控制软件。它采用 C 语言实现,是开源界目前最广泛使用的分布式版本控制系统。Git 是基于 GNU General Public License version 2.0 (GPLv2) 授权的开源项目。

- Mercurial (https://www.mercurial-scm.org/ (opens new window)) Mercurial 是一个轻量级分布式版本控制系统,采用 Python 语言实现,因而天生跨平台支持更完善。它易于学习和使用,扩展性强。Mercurial 是基于 GNU General Public License version 2.0 (GPLv2) 授权的开源项目。

知名的集中式版本控制系统有:

- Subversion (http://subversion.apache.org/ (opens new window))

- CVS (http://www.nongnu.org/cvs/ (opens new window))

相比集中式版本控制系统,分布式版本控制系统的主要优点是:

- 它比集中式的版本控制系统更灵活。因为它除了支持传统集中式的工作流,还支持其他各种工作流; 例如使用 Git,每个开发者通过克隆(git clone),在本地机器上拷贝一个完整的 Git 版本库。开发者可以提交到本地,变更可以合并到 DVCS 的任何其他用户的本地版本库中, 实现非常灵活的工作流。

- 它比集中式版本控制系统快得多。它不依赖于服务器端软件的支持就可以工作。因为大多数操作可以在客户机本地执行,不需要通过网络操作。

鉴于 Git 在开源界的广泛使用,本书将只使用 Git 作为版本控制系统。

# 4.1 Git 快速入门

以下将以 Windows Pro 64-bit 为平台,讲述 Git 的安装,以及常见的基本命令行操作。注意,Git 本是 Linux 上原生的应用程序,涉及的 Git 命令也当然都适用于 Linux。

# 4.1.1 Windows 上安装 Git

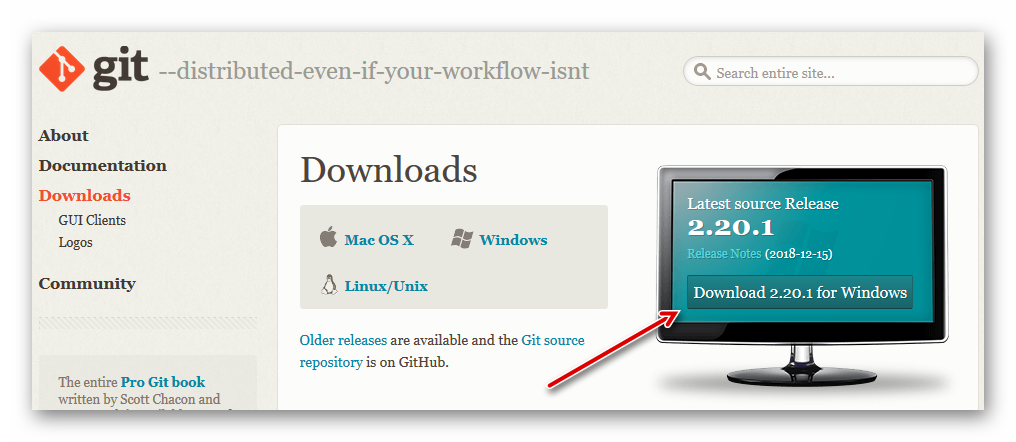

图4.1.1 Git For Windows 的下载页面

默认的安装路径是 C:\Program Files\Git,安装程序会自动添加 C:\Program Files\Git\cmd 到系统 PATH 环境变量中。安装完成后,打开命令行窗口,查看版本,命令如下:

git --version

按下列命令配置它(需替换用户自己的名字和邮箱):

git config --global user.name "YourName"

git config --global user.email "email@example.com"

git config --global gui.encoding "utf-8"

它将在 %USERPROFILE% 里自动创建一个文本文件 .gitconfig,内容如下:

C:\Users\bobyuan>type .gitconfig

[user]

name = YourName

email = email@example.com

[gui]

encoding = utf-8

这里创建的是当前用户的全局配置信息。对于单个具体的 Git 项目,如果不指定的话将继承上面的全局配置,当然,也可以指定本项目内私有的配置信息,即不使用 --global 参数。私有的配置信息将保存在项目文件夹内的 .git\config 文件里。

如果为了方便,避免每次访问远程仓库的时候 Git 都问你登录的用户名和密码,希望将登录用户名和密码保存在本地,可以使用以下命令。它将把登录成功的用户名和密码保存在 %USERPROFILE% 里“.git-credentials”文件中,同样是个文本文件。

# to store the passwords in .git-credentials in your home directory.

git config --global credential.helper store

而对于单个具体 Git 项目私有的配置,即不使用 --global参数,可以这样。

# to store the passwords in your specific Git project.

git config credential.helper store

# let Git to resume to asking you for credentials every time.

git config --unset credential.helper

另外,此安装包自带了一个极为简单的图形界面,运行 git-gui 来打开。

图4.1.2 Git For Windows 自带的图形用户界面

如果我们主要是在 Windows 上工作,免费的 Git 图形界面软件值得推荐的是 TortoiseGit (网址是 https://tortoisegit.org/ (opens new window))。图形界面的使用不是本文讨论的范畴,它只是为了方便脱离命令行使用,原理都是一样的。如果我们掌握了 Git 命令行操作,理解了 Git 的工作原理,那么图形界面软件的操作也肯定是不在话下了。

# 4.1.2 常见的基本命令行操作

# 1)本地版本库

在本地创建一个文件夹 learngit,通过 git init 命令把这个目录初始化成 Git 可以管理的版本库(repository)。为了避免出现一些不必要的麻烦,请注意文件夹路径不要包含中文,空格等字符。

D:\TEMP>mkdir learngit

D:\TEMP>cd learngit

D:\TEMP\learngit>git init

Initialized empty Git repository in D:/TEMP/learngit/.git/

我们可以看到一个隐藏文件夹 .git,它里面有多个文件,是 Git 在本地的版本库。

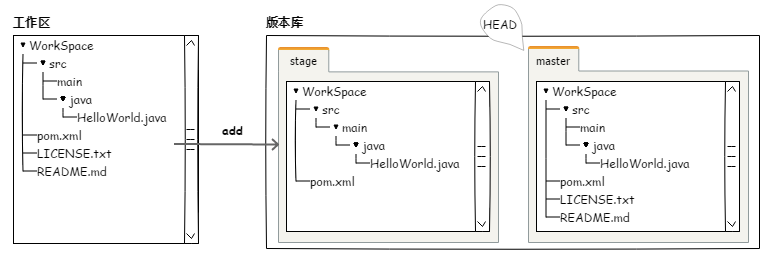

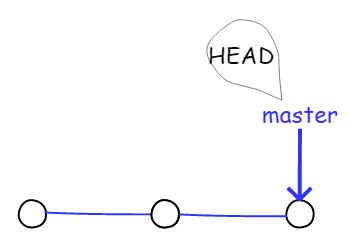

Git 的版本库里存了很多东西,其中最重要的就是称为 Stage(或者叫 Index)的暂存区,还有 Git 为我们自动创建的第一个分支 master,以及指向 master 的一个指针 HEAD。

提交到版本库需要分2步走:先是将文件添加(add)到暂存区,再一并提交(commit)到版本库里的master分支上。简单的示例如下图。

图4.1.3 Git 的版本库

小结,涉及创建本地版本库的常用命令有:

- 初始化本地版本库:

git init

# 2)添加并提交

新建一个文本文件 readme.txt。

D:\TEMP\learngit>echo Git is a version control system. > readme.txt

D:\TEMP\learngit>type readme.txt

Git is a version control system.

把它加到暂存区,再提交到版本库里。

D:\TEMP\learngit>git add readme.txt

D:\TEMP\learngit>git commit -m "add readme.txt into repository"

[master (root-commit) 0cd3695] add readme.txt into repository

1 file changed, 1 insertion(+)

create mode 100644 readme.txt

用 git log 查看提交记录,并用 git status 查看当前的工作区状态。

D:\TEMP\learngit>git log

commit b2054aba8f7be9049b35aec08574fde93547a11a (HEAD -> master)

Author: bobyuan <yuan.bob@outlook.com>

Date: Tue Mar 12 10:34:11 2019 +0800

add readme.txt into repository

D:\TEMP\learngit>git status

On branch master

nothing to commit, working tree clean

再多创建几个文件,将它们都提交到版本库里:

D:\TEMP\learngit>echo file1 content > file1.txt

D:\TEMP\learngit>echo file2 content > file2.txt

D:\TEMP\learngit>echo file3 content > file3.txt

D:\TEMP\learngit>git add file1.txt file2.txt file3.txt

D:\TEMP\learngit>git status

On branch master

Changes to be committed:

(use "git reset HEAD <file>..." to unstage)

new file: file1.txt

new file: file2.txt

new file: file3.txt

D:\TEMP\learngit>git commit -m "add file1, file2 and file3"

[master 2165d38] add file1, file2 and file3

3 files changed, 3 insertions(+)

create mode 100644 file1.txt

create mode 100644 file2.txt

create mode 100644 file3.txt

我们可以看到,提交成功后工作区空间便是空的了。用 git log 可以看到这次提交的记录。

D:\TEMP\learngit>git status

On branch master

nothing to commit, working tree clean

D:\TEMP\learngit>git log

commit 7c77f840f332074cb75085a31a8c5e862382055c (HEAD -> master)

Author: bobyuan <yuan.bob@outlook.com>

Date: Tue Mar 12 10:35:26 2019 +0800

add file1, file2 and file3

commit b2054aba8f7be9049b35aec08574fde93547a11a

Author: bobyuan <yuan.bob@outlook.com>

Date: Tue Mar 12 10:34:11 2019 +0800

add readme.txt into repository

小结,涉及添加并提交到本地版本库的常用命令有:

- 添加文件到暂存区:

git add <file> - 提交到本地版本库:

git commit -m "a short description" - 查看提交记录:

git log - 查看当前状态:

git status

# 3)修改并提交

给 readme.txt 增加一行文字。

D:\TEMP\learngit>echo Git is a free software. >> readme.txt

D:\TEMP\learngit>type readme.txt

Git is a version control system.

Git is a free software.

我们可以通过 git status 看到,提示 readme.txt 文件已经更改。

D:\TEMP\learngit>git status

On branch master

Changes not staged for commit:

(use "git add <file>..." to update what will be committed)

(use "git checkout -- <file>..." to discard changes in working directory)

modified: readme.txt

no changes added to commit (use "git add" and/or "git commit -a")

如果此时我们对当前的修改不满意,想要回退到之前提交的版本,可以参照上面的提示,用命令 git checkout -- readme.txt 回退。当前的修改将被丢弃。注意,命令中的“--”很重要,没有它,就变成了“切换到另一个分支”的命令,

而如果我们认可当前的修改,我们就可以把它加入到工作区,然后提交到版本库。

D:\TEMP\learngit>git add readme.txt

D:\TEMP\learngit>git commit -m "append a line into readme.txt"

[master 03ac17e] append a line in readme.txt

1 file changed, 1 insertion(+)

提交后,工作区的状态已经空了,且 git log 可以看到这次提交的记录。

D:\TEMP\learngit>git status

On branch master

nothing to commit, working tree clean

D:\TEMP\learngit>git log

commit 22ddccf734d1568391a0e84d1d2b07c02d2601b8 (HEAD -> master)

Author: bobyuan <yuan.bob@outlook.com>

Date: Tue Mar 12 10:39:04 2019 +0800

append a line into readme.txt

commit 7c77f840f332074cb75085a31a8c5e862382055c

Author: bobyuan <yuan.bob@outlook.com>

Date: Tue Mar 12 10:35:26 2019 +0800

add file1, file2 and file3

commit b2054aba8f7be9049b35aec08574fde93547a11a

Author: bobyuan <yuan.bob@outlook.com>

Date: Tue Mar 12 10:34:11 2019 +0800

add readme.txt into repository

在有些场景下,若出现了人为错误,希望修改先前的提交,可以用 --amend 命令。例如:

场景1: 如果提交后,不满意之前的提交信息(即 -m 参数后面跟的描述信息),可以修改它。命令格式如下:

git commit --amend -m "New commit message"

例如在下面的例子中,我们把之前的提交信息“append a line into readme.txt”改成了“New commit message”。

D:\TEMP\learngit>git commit --amend -m "New commit message"

[master 67e8599] New commit message

Date: Tue Mar 12 10:39:04 2019 +0800

1 file changed, 1 insertion(+)

从 git log 中可见,修改后描述从之前的“append a line into readme.txt”已经变成了“New commit message”。

D:\TEMP\learngit>git log

commit 67e8599c82a0623e2f77fbeab3aea77a46f7f764 (HEAD -> master)

Author: bobyuan <yuan.bob@outlook.com>

Date: Tue Mar 12 10:39:04 2019 +0800

New commit message

commit 7c77f840f332074cb75085a31a8c5e862382055c

Author: bobyuan <yuan.bob@outlook.com>

Date: Tue Mar 12 10:35:26 2019 +0800

add file1, file2 and file3

commit b2054aba8f7be9049b35aec08574fde93547a11a

Author: bobyuan <yuan.bob@outlook.com>

Date: Tue Mar 12 10:34:11 2019 +0800

add readme.txt into repository

场景2:当你提交之后,发现还有一个文件给漏掉了,想把它加到之前的提交上,而描述不变。命令格式如下:

git add another_file.txt

git commit --amend --no-edit

例如在下面的例子中,我们新增了一个文件 another_file.txt,把它加到先前的提交上。

D:\TEMP\learngit>echo It is another file that is needed. > another_file.txt

D:\TEMP\learngit>type another_file.txt

It is another file that is needed.

D:\TEMP\learngit>git add another_file.txt

D:\TEMP\learngit>git commit --amend --no-edit

[master b2750d1] New commit message

Date: Tue Mar 12 10:39:04 2019 +0800

2 files changed, 2 insertions(+)

create mode 100644 another_file.txt

从 git log 中我们可以看到,最近的提交 ID 变化了。之前的提交是“67e8599c82a0623e2f77fbeab3aea77a46f7f764”,而现在是“b2750d179ac0ca566c6ba9dc8c88824d99a6086b”。

D:\TEMP\learngit>git log

commit b2750d179ac0ca566c6ba9dc8c88824d99a6086b (HEAD -> master)

Author: bobyuan <yuan.bob@outlook.com>

Date: Tue Mar 12 10:39:04 2019 +0800

New commit message

commit 7c77f840f332074cb75085a31a8c5e862382055c

Author: bobyuan <yuan.bob@outlook.com>

Date: Tue Mar 12 10:35:26 2019 +0800

add file1, file2 and file3

commit b2054aba8f7be9049b35aec08574fde93547a11a

Author: bobyuan <yuan.bob@outlook.com>

Date: Tue Mar 12 10:34:11 2019 +0800

add readme.txt into repository

小结,涉及修改并提交到本地版本库的常用命令有:

- 文件修改后提交到本地版本库,需要先添加(add)再提交(commit)。

- 如果要修改先前提交信息,或者将漏掉的文件加入到之前的提交,可以用

--amend选项。

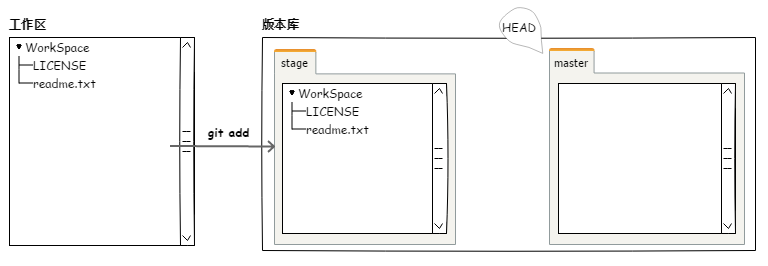

# 4)暂存区

我们再次修改 readme.txt,给它尾部增加一行文字,同时,创建了一个新文件 LICENSE 。查看状态,可以看到提示说,readme.txt 已被修改过(modified),而 LICENSE 未被版本管理跟踪(Untracked)。

D:\TEMP\learngit>echo Git has a mutable index called stage. >> readme.txt

D:\TEMP\learngit>echo License Information > LICENSE

D:\TEMP\learngit>git status

On branch master

Changes not staged for commit:

(use "git add <file>..." to update what will be committed)

(use "git checkout -- <file>..." to discard changes in working directory)

modified: readme.txt

Untracked files:

(use "git add <file>..." to include in what will be committed)

LICENSE

no changes added to commit (use "git add" and/or "git commit -a")

若要将它们提交,依然是分2步走:先添加,再提交。

在添加后,我们可以看到这2个文件已经进入暂存区。如下图所示:

D:\TEMP\learngit>git add readme.txt LICENSE

D:\TEMP\learngit>git status

On branch master

Changes to be committed:

(use "git reset HEAD <file>..." to unstage)

new file: LICENSE

modified: readme.txt

图4.1.4 暂存区,添加文件到暂存区

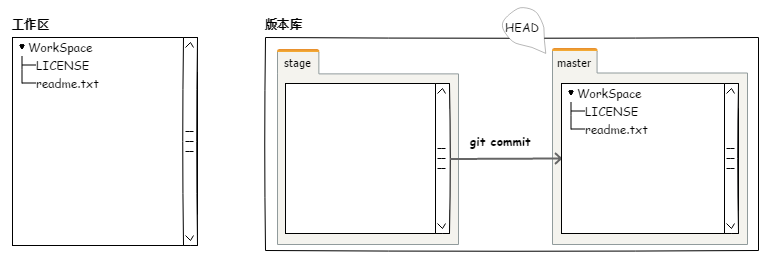

提交后,暂存区就清空了。

D:\TEMP\learngit>git commit -m "modify readme.txt and add LICENSE"

[master be0af06] modify readme.txt and add LICENSE

2 files changed, 2 insertions(+)

create mode 100644 LICENSE

D:\TEMP\learngit>git status

On branch master

nothing to commit, working tree clean

图4.1.5 暂存区,提交文件到版本库

暂存区(Stage)提供了一个缓冲,我们把当前工作区(即当前文件夹)的文件先添加到暂存区,然后一次性提交到本地版本库。有暂存区的好处是,如果添加文件过程中发生人为错误还来得及修改。

需要注意的是,当前工作区内的文件修改后(此文件之前已经入库),一定要添加到缓存区后才能被提交。如果我们修改后,忘记再次添加到缓存区,则提交时只会将缓存区内的文件提交,而不会把我们工作区内新的修改带上。

下面我们试看利用暂存区回滚的情况。

我们再给 readme.txt 增加一行文字。

D:\TEMP\learngit>echo But my boss still prefers SVN. >> readme.txt

D:\TEMP\learngit>type readme.txt

Git is a version control system.

Git is a free software.

Git has a mutable index called stage.

But my boss still prefers SVN.

D:\TEMP\learngit>git status

On branch master

Changes not staged for commit:

(use "git add <file>..." to update what will be committed)

(use "git checkout -- <file>..." to discard changes in working directory)

modified: readme.txt

no changes added to commit (use "git add" and/or "git commit -a")

因为还没添加到缓存区,如果想要丢弃修改,按提示 git checkout -- <file>... 所述命令,回到最近一次提交的情况。具体命令如下:

D:\TEMP\learngit>git checkout -- readme.txt

D:\TEMP\learngit>type readme.txt

Git is a version control system.

Git is a free software.

Git has a mutable index called stage.

要是不小心已经将它添加到暂存区了:

D:\TEMP\learngit>echo But my boss still prefers SVN. >> readme.txt

D:\TEMP\learngit>git status

On branch master

Changes not staged for commit:

(use "git add <file>..." to update what will be committed)

(use "git checkout -- <file>..." to discard changes in working directory)

modified: readme.txt

no changes added to commit (use "git add" and/or "git commit -a")

D:\TEMP\learngit>git add readme.txt

D:\TEMP\learngit>git status

On branch master

Changes to be committed:

(use "git reset HEAD <file>..." to unstage)

modified: readme.txt

我们可以按提示所述 git reset HEAD <file> 命令将它移除暂存区(Unstage):

D:\TEMP\learngit>git reset HEAD readme.txt

Unstaged changes after reset:

M readme.txt

D:\TEMP\learngit>git status

On branch master

Changes not staged for commit:

(use "git add <file>..." to update what will be committed)

(use "git checkout -- <file>..." to discard changes in working directory)

modified: readme.txt

no changes added to commit (use "git add" and/or "git commit -a")

我们可以继续按提示 git checkout -- <file>... 所述命令,丢弃修改,返回到最近一次提交的情况。

D:\TEMP\learngit>type readme.txt

Git is a version control system.

Git is free software.

Git has a mutable index called stage.

My stupid boss still prefers SVN.

D:\TEMP\learngit>git checkout -- readme.txt

D:\TEMP\learngit>type readme.txt

Git is a version control system.

Git is free software.

Git has a mutable index called stage.

D:\TEMP\learngit>git status

On branch master

nothing to commit, working tree clean

小结,涉及暂存区的常用命令有:

将已经添加到暂存区的文件撤销。

git reset HEAD <file>若要将本地文件的修改丢弃,退回到最近一次提交到本地版本库的样子。

git checkout -- <file_name>

# 5)删除与改名

如果由于误操作删除了某个文件,可以很方便地按 git checkout -- <file>... 恢复到最近一次提交的情况。这与之前丢弃本地修改的例子一样。

D:\TEMP\learngit>del readme.txt

D:\TEMP\learngit>type readme.txt

The system cannot find the file specified.

D:\TEMP\learngit>git checkout -- readme.txt

D:\TEMP\learngit>type readme.txt

Git is a version control system.

Git is free software.

Git has a mutable index called stage.

如果我们确实是想删除某个文件,例如“file3.txt”,可以用 git rm <file>... 命令操作。

D:\TEMP\learngit>git rm file3.txt

rm 'file3.txt'

然后,提交到版本库。

D:\TEMP\learngit>git status

On branch master

Changes to be committed:

(use "git reset HEAD <file>..." to unstage)

deleted: file3.txt

D:\TEMP\learngit>git commit -m "deleted file3.txt"

[master ba5eb05] deleted file3.txt

1 file changed, 1 deletion(-)

delete mode 100644 file3.txt

如果一个文件已经被提交到版本库中了,那么不用担心误删,但是要注意,我们只能恢复文件到版本库里的版本。也就是说,这将会丢失最近一次提交之后的修改。

类似的,移动或改名的命令是:git mv <source> <destination>。例如,我们将文件“file2.txt”改名为“file2_renamed.txt”:

D:\TEMP\learngit>git mv file2.txt file2_renamed.txt

然后,提交到版本库:

D:\TEMP\learngit>git status

On branch master

Changes to be committed:

(use "git reset HEAD <file>..." to unstage)

renamed: file2.txt -> file2_renamed.txt

D:\TEMP\learngit>git commit -m "rename file2.txt"

[master eca88d6] rename file2.txt

1 file changed, 0 insertions(+), 0 deletions(-)

rename file2.txt => file2_renamed.txt (100%)

可以显示它的更多信息:

D:\TEMP\learngit>git show file2_renamed.txt

commit eca88d631b8f59edf2b075ebbeae9c83e8d80a26 (HEAD -> master)

Author: bobyuan <yuan.bob@outlook.com>

Date: Tue Mar 12 11:54:02 2019 +0800

rename file2.txt

diff --git a/file2_renamed.txt b/file2_renamed.txt

new file mode 100644

index 0000000..00db75b

--- /dev/null

+++ b/file2_renamed.txt

@@ -0,0 +1 @@

+file2 content

小结,涉及删除、移动或改名的常用命令有:

- 将某个文件删除:

git rm <file> - 将某个文件或文件夹移动或改名:

git mv <source> <destination> - 显示某个文件的多项信息:

git show <file>

# 6)分支

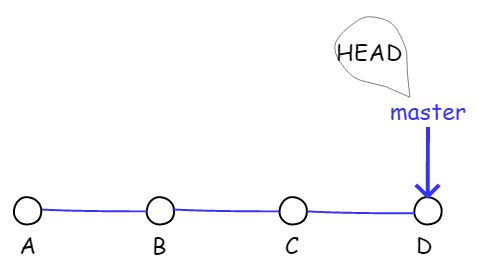

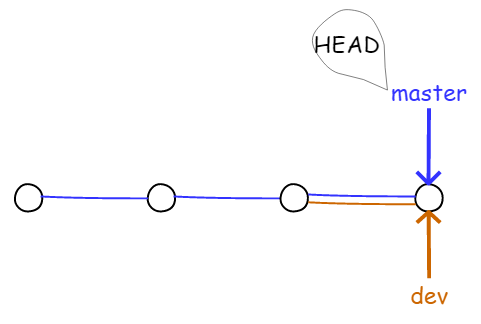

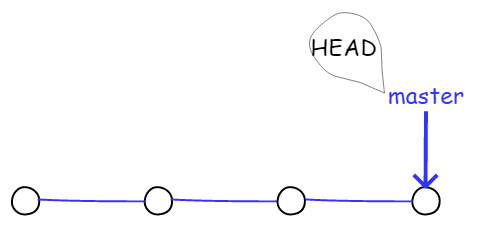

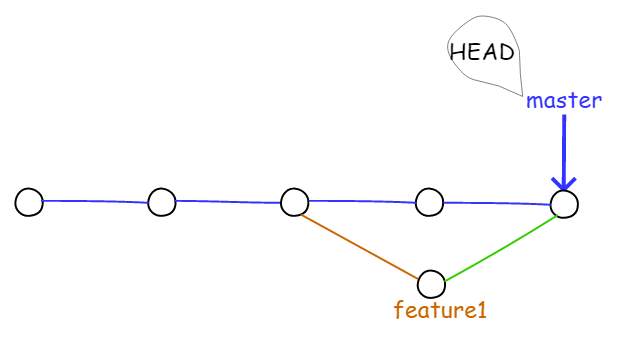

Git 把每次提交串成一条时间线,这条时间线就是一个分支(branch)。截止到目前,只有一条时间线,在Git里,这个分支叫主分支,即 master 分支。HEAD 严格来说不是指向提交,而是指向 master,master 才是指向提交的分支名称,所以,HEAD 指向的就是当前分支。

一开始的时候,master 分支是一条线,Git 用 master 指向最新的提交,再用 HEAD 指向 master,就能确定当前分支以及当前分支的提交点,具体如图所示:

图4.1.6 分支

每提交一次,master 分支都会向前移动一步。这样,随着我们不断提交,master 分支的线也越来越长。例如下图所示为经过三次提交后的情形。

图4.1.7 增加一次提交

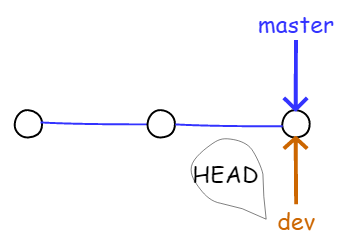

例如,当创建新的分支 dev 时,Git 会新建一个 dev 指针指向 master 相同的提交,再把 HEAD 指向 dev,就表示当前分支在 dev上。如下图所示:

图4.1.8 新建 dev 分支

Git 能快速创建一个分支,因为除了增加一个 dev 指针、改变 HEAD 的指向外,工作区的文件不需要任何变化。

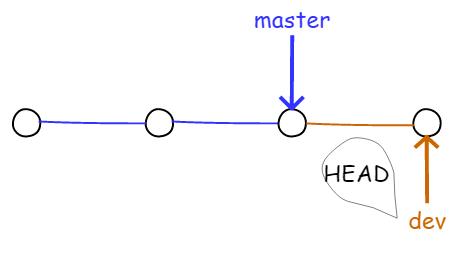

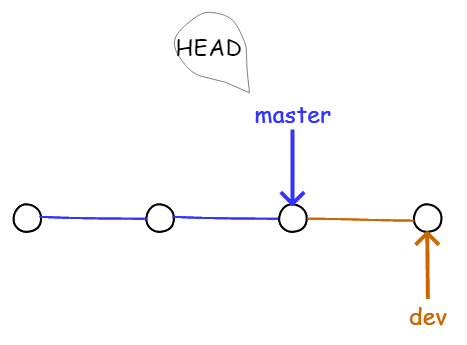

然而,从现在开始,对工作区的修改和提交就是针对 dev 分支了,比如新提交一次后,dev 指针往前移动一步,而 master 指针没变。如下图所示:

图4.1.9 在 dev 分支上提交

假如在 dev 上的工作完成了,就可以把 dev 合并到 master 上。Git 是直接把 master 指向 dev 的当前提交,就完成了合并。如下图所示:

图4.1.10 在 master 分支上合并 dev 分支

可见 Git 合并分支也很快。只改变了指针,工作区内容不需要变动,效率非常高!

合并完分支后,可以删除不用的 dev 分支。删除 dev 分支就是删掉 dev 指针,之后就剩下了一条 master 分支。如下图所示:

图4.1.11 删除不用的 dev 分支

下面我们示范操作。

创建分支,并切换到新的分支上:

D:\TEMP\learngit>git branch dev

D:\TEMP\learngit>git checkout dev

Switched to branch 'dev'

注意,在实际工作中,以上两步其实可以简化成一条命令:

git checkout -b dev

我们查看一下分支情况(当前是在打“*”号的分支上)。

D:\TEMP\learngit>git branch

* dev

master

修改 readme.txt,增加一行文字:

D:\TEMP\learngit>echo Creating a new branch is quick. >> readme.txt

D:\TEMP\learngit>type readme.txt

Git is a version control system.

Git is free software.

Git has a mutable index called stage.

Creating a new branch is quick.

然后提交:

D:\TEMP\learngit>git add readme.txt

D:\TEMP\learngit>git commit -m "append a line of text to readme.txt"

[dev 5f1bd73] append a line of text to readme.txt

1 file changed, 1 insertion(+)

现在,dev 分支的工作完成,我们就可以切换回 master 分支。

D:\TEMP\learngit>git checkout master

Switched to branch 'master'

需要注意的是,切换到其他分支时,当前分支必须没有修改,或者修改已经提交到版本库中了,否则会切换失败。

切换回 master 分支后,再查看一下 readme.txt 文件,刚才添加的内容不见了!那是因为之前提交的是在 dev 分支上,而 master 分支此刻的提交点并没有变。结果如下图所示:

图4.1.12 切换回 master 分支

现在,我们把 dev 分支的工作成果合并到 master 分支上:

D:\TEMP\learngit>git merge dev

Updating eca88d6..5f1bd73

Fast-forward

readme.txt | 1 +

1 file changed, 1 insertion(+)

git merge 命令用于合并指定分支到当前分支。合并后,再查看 readme.txt 的内容,可以看到,和 dev 分支的最新提交是完全一样的。

Git 提示我们,这次合并是快进模式(Fast-forward),也就是直接把 master 指向 dev 的当前提交,所以合并速度非常快。不是每次合并都能 Fast-forward,后面会介绍其它方式的合并。

合并完成后,就可以删除 dev 分支了。删除后查看分支,可以看到只剩下了 master 分支:

D:\TEMP\learngit>git branch -d dev

Deleted branch dev (was 5f1bd73).

D:\TEMP\learngit>git branch

* master

Git 创建、合并和删除分支非常快,所以 Git 推荐使用分支完成某个任务。这和直接在 master 分支上工作效率是一样的,且更安全(不影响 master 分支),更灵活(自己的分支只有自己可见,且不能预判什么时候能开发完),特别适用于多人协作开发的场合:

- 假如在分支上的任务完成,可以合并到

master分支后再将此分支删掉; - 如果分支上的任务完成得不理想,则可以直接丢弃,不进行合并,直接将此分支删除。

小结,涉及分支的常用命令有:

查看分支:

git branch创建分支:

git branch <branch_name>切换分支:

git checkout <branch_name>创建+切换分支:

git checkout -b <branch_name>合并某分支到当前分支:

git merge <branch_name>删除分支:

git branch -d <branch_name>

# 7)解决冲突

在合并分支的操作中,一般情况下 Git 会自动合并文本文件的修改,但是,若同一个文件的同一行存在不同的修改时,就需要人工参与合并,解决冲突后再次提交。

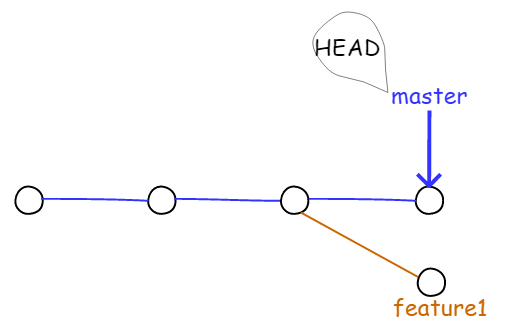

例如,我们创建一个新的 feature1 分支,在新分支上开发:

D:\TEMP\learngit>git checkout -b feature1

Switched to a new branch 'feature1'

修改 readme.txt 文件,增加了一行文字:

D:\TEMP\learngit>echo This line will cause conflict. >> readme.txt

D:\TEMP\learngit>type readme.txt

Git is a version control system.

Git is a free software.

Git has a mutable index called stage.

Creating a new branch is quick.

This line will cause conflict.

然后在 feature1 分支上:

D:\TEMP\learngit>git add readme.txt

D:\TEMP\learngit>git commit -m "add a line to readme.txt that will in conflict."

[feature1 b5fe885] add a line to readme.txt that will in conflict.

1 file changed, 1 insertion(+)

切换回到 master 分支。

D:\TEMP\learngit>git checkout master

Switched to branch 'master'

这次也是修改 readme.txt 文件,增加了一行文字,但稍许不同(它们都处在同一行,即第5行):

D:\TEMP\learngit>echo This line will cause conflict while merging. >> readme.txt

D:\TEMP\learngit>type readme.txt

Git is a version control system.

Git is free software.

Git has a mutable index called stage.

Creating a new branch is quick.

This line will cause conflict while merging.

在 master 分支上提交:

D:\TEMP\learngit>git add readme.txt

D:\TEMP\learngit>git commit -m "add a line to readme.txt, it for sure will result a conflict."

[master fe8dbec] add a line to readme.txt, it for sure will result a conflict.

1 file changed, 1 insertion(+)

现在,master 分支和 feature1 分支各自都分别有新的提交,变成了下图所示情况:

图4.1.13 master 和 feature1 分支都有新的提交

这种情况下,Git 无法执行“快速合并”,只能试图把各自的修改合并起来,但这种合并就可能会发生冲突:

D:\TEMP\learngit>git merge feature1

Auto-merging readme.txt

CONFLICT (content): Merge conflict in readme.txt

Automatic merge failed; fix conflicts and then commit the result.

可见发生了冲突!Git 告诉我们 readme.txt 文件存在冲突,必须手动解决冲突后再提交。用git status 也可以查看到发生冲突的文件:

D:\TEMP\learngit>git status

On branch master

You have unmerged paths.

(fix conflicts and run "git commit")

(use "git merge --abort" to abort the merge)

Unmerged paths:

(use "git add <file>..." to mark resolution)

both modified: readme.txt

no changes added to commit (use "git add" and/or "git commit -a")

我们可以直接查看 readme.txt 的内容。它变成了这样:

D:\TEMP\learngit>type readme.txt

Git is a version control system.

Git is a free software.

Git has a mutable index called stage.

Creating a new branch is quick.

<<<<<<< HEAD

This line will cause conflict while merging.

=======

This line will cause conflict.

>>>>>>> feature1

Git 用 <<<<<<<,=======,>>>>>>> 标记分割不同分支的内容,便于我们对比后合并。

我们修改 readme.txt 后保存。内容如下:

D:\TEMP\learngit>type readme.txt

Git is a version control system.

Git is a free software.

Git has a mutable index called stage.

Creating a new branch is quick.

This line will now have no conflict, merged manually.

再次提交,这次成功了。

D:\TEMP\learngit>git add readme.txt

D:\TEMP\learngit>git commit -m "conflict resolved."

[master fa56be4] conflict resolved.

现在,master 分支和 feature1 分支变成了下图所示的情形。

图4.1.14 在 master 分支上合并 feature1 分支

用带参数的 git log 查看分支的合并情况。

D:\TEMP\learngit>git log --graph --pretty=oneline --abbrev-commit

* fa56be4 (HEAD -> master) conflict resolved.

|\

| * b5fe885 (feature1) add a line to readme.txt that will in conflict.

* | fe8dbec add a line to readme.txt, it for sure will result a conflict.

|/

* 5f1bd73 append a line of text to readme.txt

* eca88d6 rename file2.txt

* ba5eb05 deleted file3.txt

* 8ff8d96 modify readme.txt and add LICENSE

* b2750d1 New commit message

* 7c77f84 add file1, file2 and file3

* b2054ab add readme.txt into repository

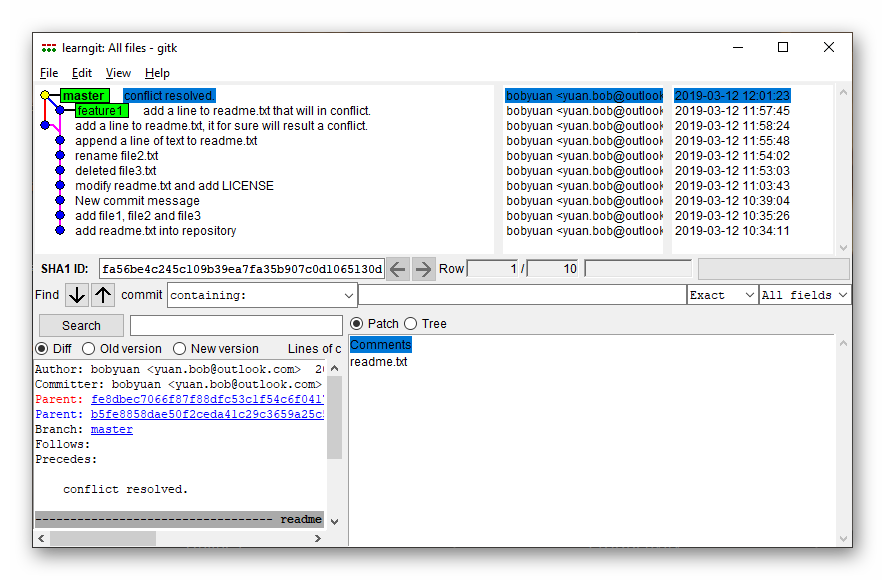

我们还可以运行 gitk 图形界面来看分支情况。如下图所示:

图4.1.15 运行 gitk 图形界面

最后,合并后不再需要的 feature1 分支,须删除:

D:\TEMP\learngit>git branch -d feature1

Deleted branch feature1 (was b5fe885).

当 Git 无法自动合并分支时,就产生了冲突,需要手工修改发生冲突的文件,编辑成为我们希望的内容,再提交即可。

小结,涉及解决冲突的常用命令有:

- 合并另一分支到当前分支:

git merge <another_branch_name> - 冲突解决后,再次提交:

git commit -m "a short description" - 合并完成后,删除另一分支:

git branch -d <another_branch_name> - 图形化显示提交记录:

git log --graph --pretty=oneline --abbrev-commit

# 8)远程版本库

以 Git 托管服务 GitHub 为例,在上面新建立一个远程版本库(Repository),然后将它克隆到本地(Clone),作为本地版本库。我在本地版本库上做修改,完成后提交到本地库(Commit),再推送到远程版本库上(Push)。其他合作开发者也可以进行同样的操作,于是就可以通过远程版本库来协作开发了。如果需要让本地库和远程库同步,可执行拉操作(Pull),大多数情况下 Git 会自动合并(Merge),但如果有冲突(Conflict),那么也可以解决冲突后,再次提交并推送到远程版本库上。

这就是作为团队协作开发使用远程版本库的常见模式。如果是单个人开发,则这样做的好处是,远程版本库可以作为备份,从而保证数据安全。

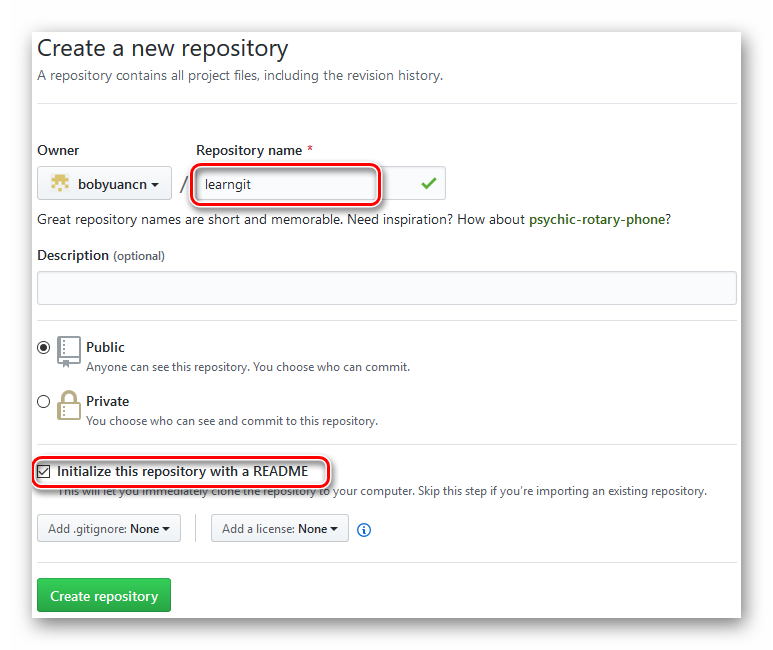

在 GitHub 上创建一个“learngit”的远程版本库,如下图所示:

图4.1.16 创建新的代码库

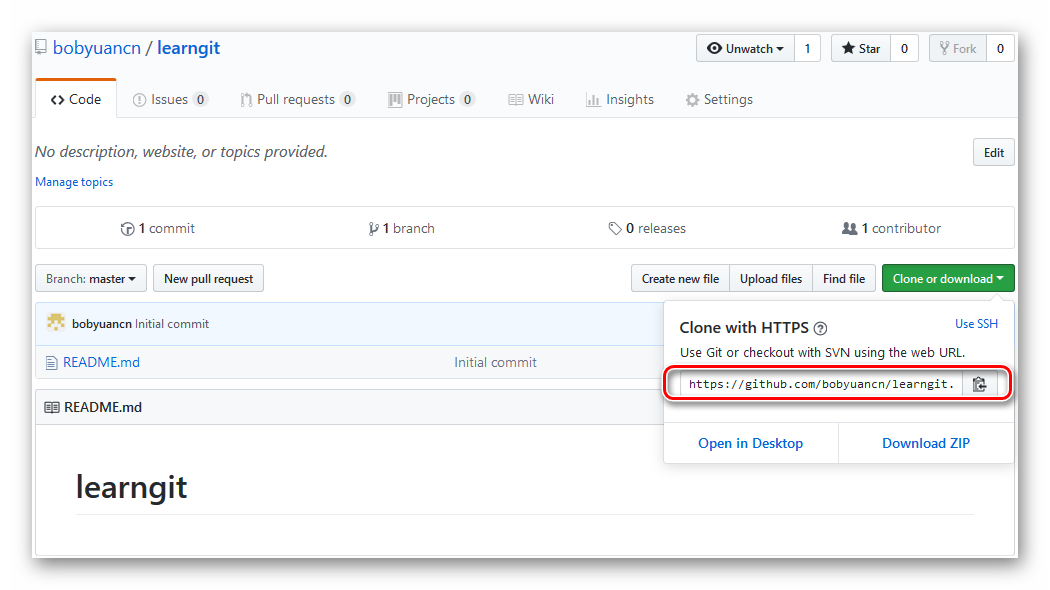

创建成功后,按“Clone or download”按钮,会出现下拉窗口,显示了克隆此远程版本库的URL:

https://github.com/bobyuancn/learngit.git

记住这个 URL,它将用在后面的克隆命令中。代码库的克隆链接位置如下图所示:

图4.1.17 代码库的克隆链接

将它克隆到本地,使用命令git clone <remote_repo_url>,如下:

D:\TEMP>mkdir github

D:\TEMP>cd github

D:\TEMP\github>git clone https://github.com/bobyuancn/learngit.git

Cloning into 'learngit'...

remote: Enumerating objects: 3, done.

remote: Counting objects: 100% (3/3), done.

remote: Total 3 (delta 0), reused 0 (delta 0), pack-reused 0

Unpacking objects: 100% (3/3), done.

结果显示,本地只有一个“README.md”文本文件:

D:\TEMP\github>cd learngit

D:\TEMP\github\learngit>type README.md

# learngit

我们用文本编辑器打开它,修改成为如下内容并保存:

# learngit

This is my first Git based project.

检查一下“README.md”的内容,将它提交到本地库:

D:\TEMP\github\learngit>type README.md

# learngit

This is my first Git based project.

D:\TEMP\github\learngit>git add README.md

D:\TEMP\github\learngit>git commit -m "Add a line of text to README.txt"

[master bdedcc7] Add a line of text to README.txt

1 file changed, 2 insertions(+), 1 deletion(-)

再把当前工作的主分支 master 推送到服务器上的远程版本库中,使用命令git push origin master,如下:

D:\TEMP\github\learngit>git push origin master

Enumerating objects: 5, done.

Counting objects: 100% (5/5), done.

Writing objects: 100% (3/3), 304 bytes | 304.00 KiB/s, done.

Total 3 (delta 0), reused 0 (delta 0)

To https://github.com/bobyuancn/learngit.git

678719e..bdedcc7 master -> master

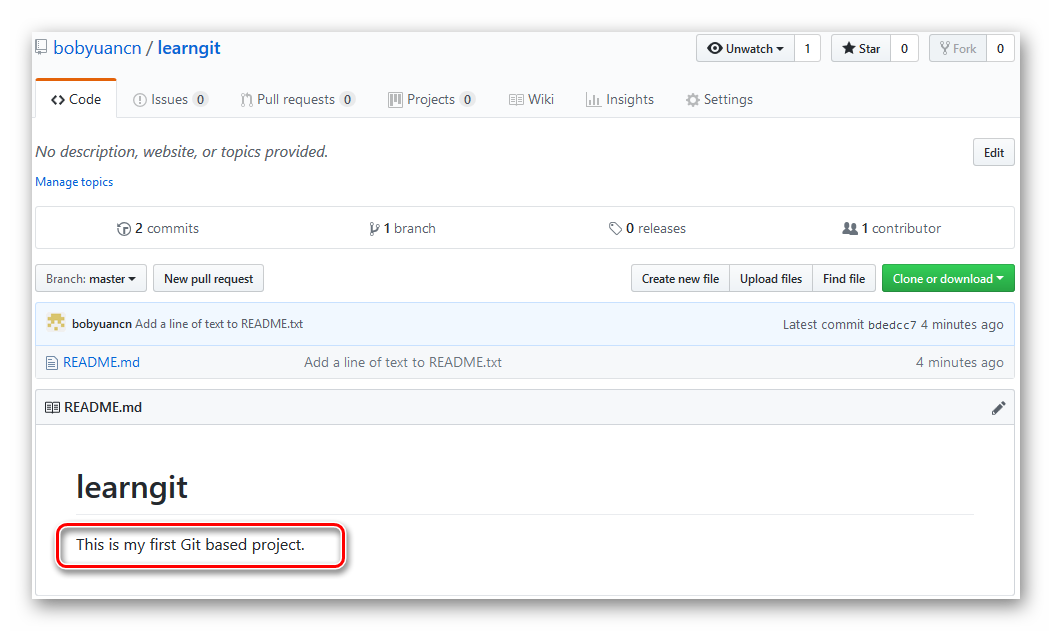

用浏览器访问此远程版本库(https://github.com/bobyuancn/learngit),发现我们的修改已经存在了,如下图所示:

图4.1.18 查看版本库的变更

若有需要从远程版本库同步到本地库,使用命令git pull,如下:

D:\TEMP\github\learngit>git pull

Already up to date.

分布式版本系统在本地工作完全不需要考虑远程库的存在,没有联网时也可以正常工作;而集中式版本控制系统 (如 Subversion)在没有联网的时候是无法工作的!当有网络的时候,再把本地提交推送到远程版本库。

小结,涉及远程版本库的常用命令有:

- 将远程版本库克隆到本地库:

git clone <remote_repo_url> - 将本地库的修改推送到远程版本库:

git push ... - 将远程版本库同步到本地库:

git pull

# 9)“.gitignore”文件

“.gitignore”是一个纯文本文件,置于工作区中,方便 Git 过滤掉那些不需要版本控制的文件,例如:

- 操作系统自动生成的文件,例如:

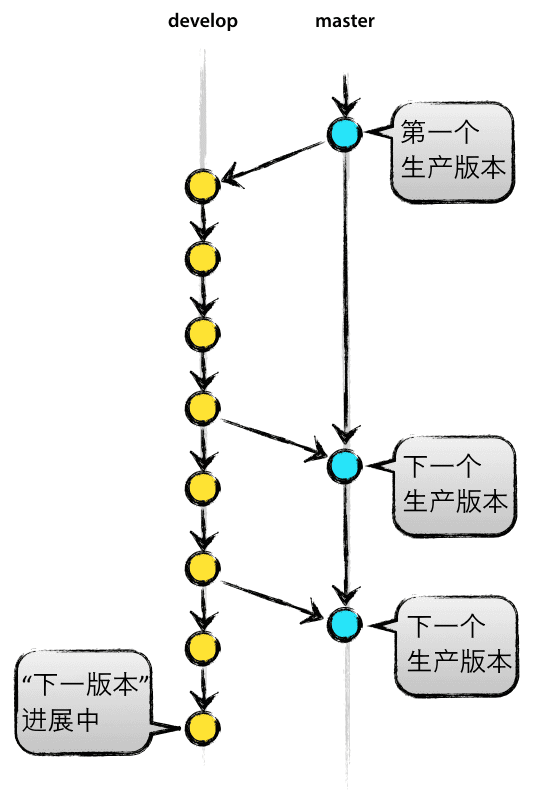

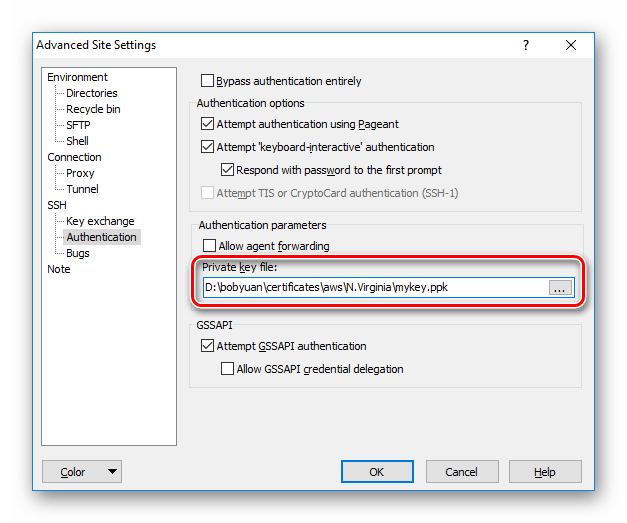

Thumbs.db, ehthumbs.db, Desktop.ini - 编译生成的中间文件、可执行文件等,例如: